参考了https://blog.csdn.net/b285795298/article/details/88683987

假设您已经了解线性回归.

又假设您十分了解sigmoid 函数.

我们知道, 线性回归是这样的:

给定数据集, 其中,

,线性回归试图学习到一个线性模型,尽可能地输出正确标记.

吴恩达老师说:

如果我们要用线性回归算法来解决一个分类问题,(对于分类,y 取值为 0 或者 1),但如果你使用的是线性回归,那么假设函数的输出值可能远大于 1,或者远小于 0,就算所有训练样本的标签 y 都是 0 或 1但是如果算法得到的值远大于 1 或者远小于 0 的话,就会感觉很奇怪。所以我们在接下来的要研究的算法就叫做逻辑回归算法,这个算法的性质是:它的输出值永远在 0 到 1 之间。

---------------------

作者:一心想做工程师

来源:CSDN

原文:https://blog.csdn.net/b285795298/article/details/88683987

版权声明:本文为博主原创文章,转载请附上博文链接!

LR和SVM都是分类算法

- LR和SVM都是监督学习算法。

- LR和SVM都是判别模型。

- 如果不考虑核函数,LR和SVM都是线性分类算法,也就是说他们的分类决策面都是线性的。

说明:LR也是可以用核函数的.但LR通常不采用核函数的方法.(计算量太大)

LR和SVM不同点:

1、LR采用log损失,SVM采用合页(hinge)损失。

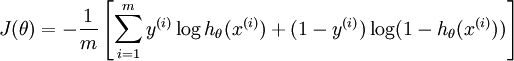

逻辑回归的损失函数:

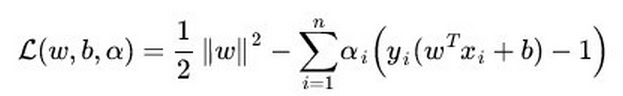

支持向量机的目标函数:

逻辑回归方法基于概率理论,假设样本为1的概率可以用sigmoid函数来表示,然后通过极大似然估计的方法估计出参数的值(基于统计的,其损失函数是人为设定的凸函数) 。支持向量机基于几何间隔最大化原理,认为存在最大几何间隔的分类面为最优分类面.(有严格的推导)

2、LR对异常值敏感,SVM对异常值不敏感(抗燥能力,SVM要强)(https://www.jianshu.com/p/1a41a1567b87)。支持向量机只考虑局部的边界线附近的点,而逻辑回归考虑全局(远离的点对边界线的确定也起作用,虽然作用会相对小一些)。LR模型找到的那个超平面,是尽量让所有点都远离他,而SVM寻找的那个超平面,是只让最靠近中间分割线的那些点尽量远离,即只用到那些支持向量的样本。

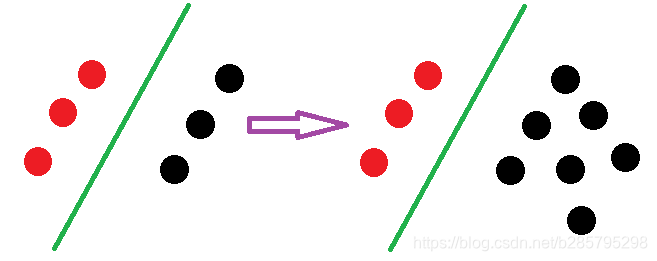

支持向量机改变非支持向量样本并不会引起决策面的变化:

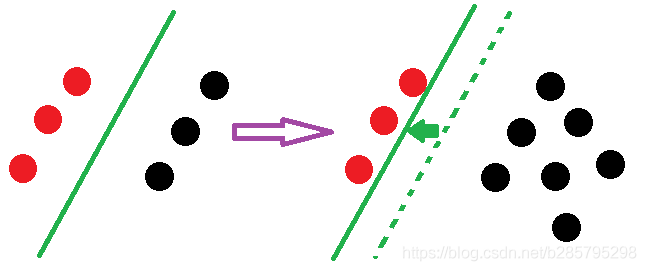

逻辑回归中改变任何样本都会引起决策面的变化:

LR则受所有数据点的影响,如果数据不同类别strongly unbalance,一般需要先对数据做balancing。(引自http://www.zhihu.com/question/26768865/answer/34078149)

更多参考下:https://blog.csdn.net/b285795298/article/details/81977271