TensorRT的环境配置请参考:【TensorRT】Win10配置TensorRT环境。

一、下载模型

一定要下载http://download.tensorflow.org/models/object_detection/ssd_inception_v2_coco_2017_11_17.tar.gz这个模型,现在github上官方的ssd_inception_v2模型应该是做了更新,放在这个例子里不能运行成功。

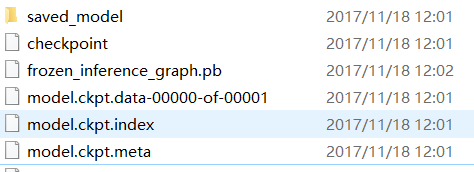

下载之后解压。

把这个文件夹拷贝到TensorRT-6.0.1.5\samples\sampleUffSSD里面。

二、转换uff文件

这里要用到安装的uff里面的一个python脚本,在Anaconda3\envs\xxx\Lib\site-packages\uff\bin下面。

激活conda的tensorflow虚拟环境。进入TensorRT-6.0.1.5\samples\sampleUffSSD路径下。

python3 xxx\Anaconda3\envs\tf14_gpu\Lib\site-packages\uff\bin\convert_to_uff.py \

ssd_inception_v2_coco_2017_11_17/frozen_inference_graph.pb -O NMS \

-p config.py \

-o ssd_inception_v2_coco_2017_11_17/sample_ssd_relu6.uff把生成的sample_ssd_relu6.uff文件拷贝到TensorRT-6.0.1.5\data\ssd文件夹下。

三、推理

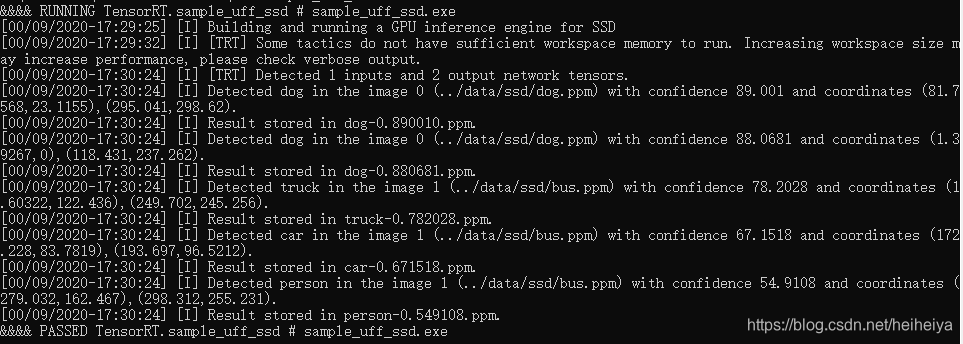

打开TensorRT-6.0.1.5\samples\sampleUffSSD下的sample_uff_ssd.sln,生成。

进入到TensorRT-6.0.1.5\bin路径下运行sample_uff_ssd.exe。

结果图: