本文主要介绍CMU在2016年发表在ACL的一篇论文:Hierarchical Attention Networks for Document Classification及其代码复现。

该论文是用于文档级情感分类(document-level sentiment classification)的,其模型架构如下:

整个网络结构包括四个部分:

1)词序列编码器

2)基于词级的注意力层

3)句子编码器

4)基于句子级的注意力层

整个网络结构由双向GRU网络和注意力机制组合而成,具体的网络结构公式如下:

词序列编码器

给定一个句子中的单词 ,其中 i 表示第 i 个句子,t 表示第 t 个词。通过一个词嵌入矩阵

将单词转换成向量表示,具体如下所示:

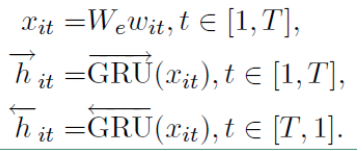

接下来看看利用双向GRU实现的整个编码流程:

最终的

词级的注意力层

注意力层的具体流程如下:

上面式子中, 是

的隐层表示,

是经 softmax 函数处理后的归一化权重系数,

是一个随机初始化的向量,之后会作为模型的参数一起被训练,

就是我们得到的第 i 个句子的向量表示。

句子编码器

也是基于双向GRU实现编码的,其流程如下:

公式和词编码类似,最后的 也是通过拼接得到的

句子级注意力层

注意力层的流程如下,和词级的一致

最后得到的向量 就是文档的向量表示,这是文档的高层表示。接下来就可以用可以用这个向量表示作为文档的特征

分类