1、需要的工具

centos7

winscp(使用它上传jdk和hadoop的压缩包)

putty(远程登录linux)

jdk-7u80-linux-x64.tar.gz

hadoop-2.6.0-cdh5.7.0.tar.gz(这里的hadoop使用的cdh,现在企业大部分使用这个)

虚拟机vmvare14.X

2、虚拟机配置

https://www.jb51.net/article/118850.htm(安装这个教程去搭建vmvare)

3、配置ssh

不同的linux系统安装命令的不同,我用的centos7所以不需要安装,系统自身携带。

配置ssh免密登录

命令:ssh-keygen -t rsa(然后三次回车,啥也别写)

命令:cd .shh

命令:cp ~/.ssh/id_rsa.pub ~/.ssh/authorized_keys

接下里看看测试是否成功

命令:ssh localhost

命令:exit

命令:ssh hadoop

4、关闭防火墙

命令:service firewalld stop

命令:systemctl disable firewalld.service

命令:service firewalld status

5、安装jdk

解压jdk

tar -zxvf jdk-7u80-linux-x64.tar.gz (自己认为将jdk压缩包放在解压的目录就可以)

我自己将jdk放在/home/app

配置环境变量

命令:vi ~/.bash_profile(打开这个文件添加下面的环境变量,其它的不要改变)

export JAVA_HOME=/home/app/jdk1.7.0_80

export PATH=

PATH

接下来使环境生效:命令: source ~/.bash_profile

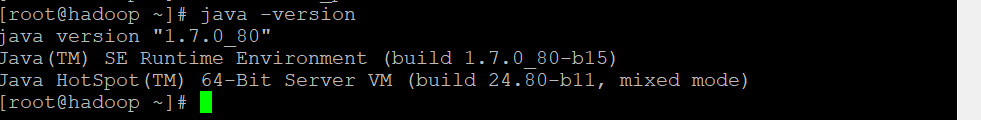

使用命令:java -version查看javajdk是否配置成功

6、安装hadoop

解压hadoop(和jdk一样,我放在/hoem/app目录下了)

命令:tar -zxvf hadoop-2.6.0-cdh5.7.0.tar.gz

解压完成之后先了解hadoop目录下文件结构

(1)bin

客户端文件 .com后缀是win的 .sh是linux的

(2)etc

(3)sbin

(4)配置文件(在etc目录下的hadoop)

首先进入etc目录下

命令:vi hadoop-env.sh

a:hadoop-env.sh(vi hadoop-env.sh)

hadoop-env.sh(vi hadoop-env.sh)

将export JAVA_HOME=${JAVA_HOME}注释掉

在下边加上:export JAVA_HOME=/home/app/

b:b:vi core-site.xml

b:vi core-site.xml

core-site.xml(vi core-site.xml )

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:8020</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/app/tmp</value>

</property>

c:vi hdfs-site.xml

hdfs-site.xml(vi hdfs-site.xml)

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

!!!!!!!!!!!!!!!!!!!!!

在你的win下找到hosts目录添加下面的命令

虚拟机的ip 指向机器名

10.32.137.251 hadoop

(5)格式化

仅仅第一次执行,不可重复执行

bin(客户端)目录下

./hdfs namenode -format

sbin目录下 启动进程 关闭进程

./start-dfs.sh

./stop-dfs.sh

4、测试hadoop是否搭建成功

在linux成功的标记(在sbin目录下输入jps)显示下面三个内容就成功了

SecondaryNameNode

DataNode

NameNode

在浏览器测试

http://hadoop:50070(浏览器如果出现hdfs管理平台测试成功)

可能遇到的问题:

(1)防火墙没关,切记防火墙一定要关

(2)ssh只能连接localhost无法连接你自己设置的用户名,你需要进去etc目录下的hosts添加

你linux的ip 指向你的用户名

配置你的slaves时,将localhost删除改为你自己的用户名(这里的用户名和你上边刚才ip指向的用户名

名是相同的)

注意你的用户名是否在创建虚拟机的时候创建的(如果是这样,上面的所提到的用户名就是创建虚拟机

时用户名)

(3)无法格式化

./hdfs namenode -format报错,可能是上面(2)用户名没有设置好,就会导致格式化出错。所以用户名一定设置好。

(4)在sbin使用jps在linuxhadoop启动成功,但是浏览器却无法显示hdfs管理平台。

原因就是自己win的主机没有配置hosts,找到hosts下边配置hosts,在里边加入linux的ip指向你的用户名。