理解

回归关注的是一个唯一的因变量(预测变量)和一个或多个数值型自变量之间的关系。首先假设因变量和自变量之间遵循线性关系。

单一线性回归:只有一个单一的自变量

多元回归:多个自变量

概念

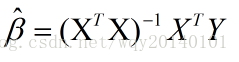

普通最小二乘估计:(最小二乘法)不多叙述

相关系数:范围在-1到1之间,越靠两端证明越相关,接近0表示不存在线性关系。一般0.1-0.3为弱相关,0.3-0.5中相关,大于0.5为强相关。

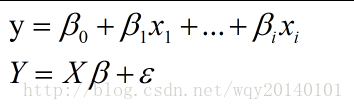

多元回归

第二个公式里面的自变量和因变量均为向量

我们要求出使得y的预测值与真实值之间的误差平方和最小的贝塔。

R语言代码:

> reg<-function(y,x){x<-as.matrix(x)

+ x<-cbind(Intercept=1,x) #将额外的一列加入矩阵x并将该列赋值为1

+ slove(t(x) %*% x) %*% t(x) %*% y} #slove求逆矩阵 %*%代表矩阵相乘提高模型性能

添加非线性关系(比如加入一列age2,将age平方后赋值,增大年龄的影响)转换

将一个数值型变量转换为一个二进制指标

我们可以假设,一个特征的影响不是积累的,而是当特征的取值达到一个给定的阈值才产生影响。例如,我们可以添加一个特征,当年龄达到18的时候赋值为1,否则赋值为0.- 模型的设定——加入相互作用的影响

当两个特征存在共同的影响时,比如吸烟和肥胖同时影响健康,称为相互作用。可以在建模过程加入这一条件。

回归树和模型树

回归树: 没有用到回归方法,而是基于到达节点的案例的平均值做成预测

模型树:和回归树以大致相同的方式生长,但是每个叶子节点,根据到达该节点的案例建立多元线性回归模型。

两者的差别:节点不是以一个数值预测终止,而是以一个线性模型终止。

例子:在葡萄酒质量评估当中,根据葡萄酒的一系列指标来给葡萄酒打分0-10,如果使用回归树,那么最终我们得到的树的叶子节点能够直接预测出某条件下葡萄酒的得分。而如果使用回归树,在这个树的每一个节点,都会产生一个对应该节点的线性模型,每一个模型对于每个特征在最后的贡献都不同。