Hinge Loss

表达式为:

Li=j=yi∑max(0,sj−syi+1)

实际上可以写成:

f(n)=j=yi∑{0,sj−syi+1,if syi>sj+1otherwise

其中

syi是指第

i个样本的对应的其正确标签的得分,

sj是指这个样本对应的第

j个标签的得分。

即对于第

i个样本,有:

sj=f(xi;W)j

syi=f(xi;W)yi

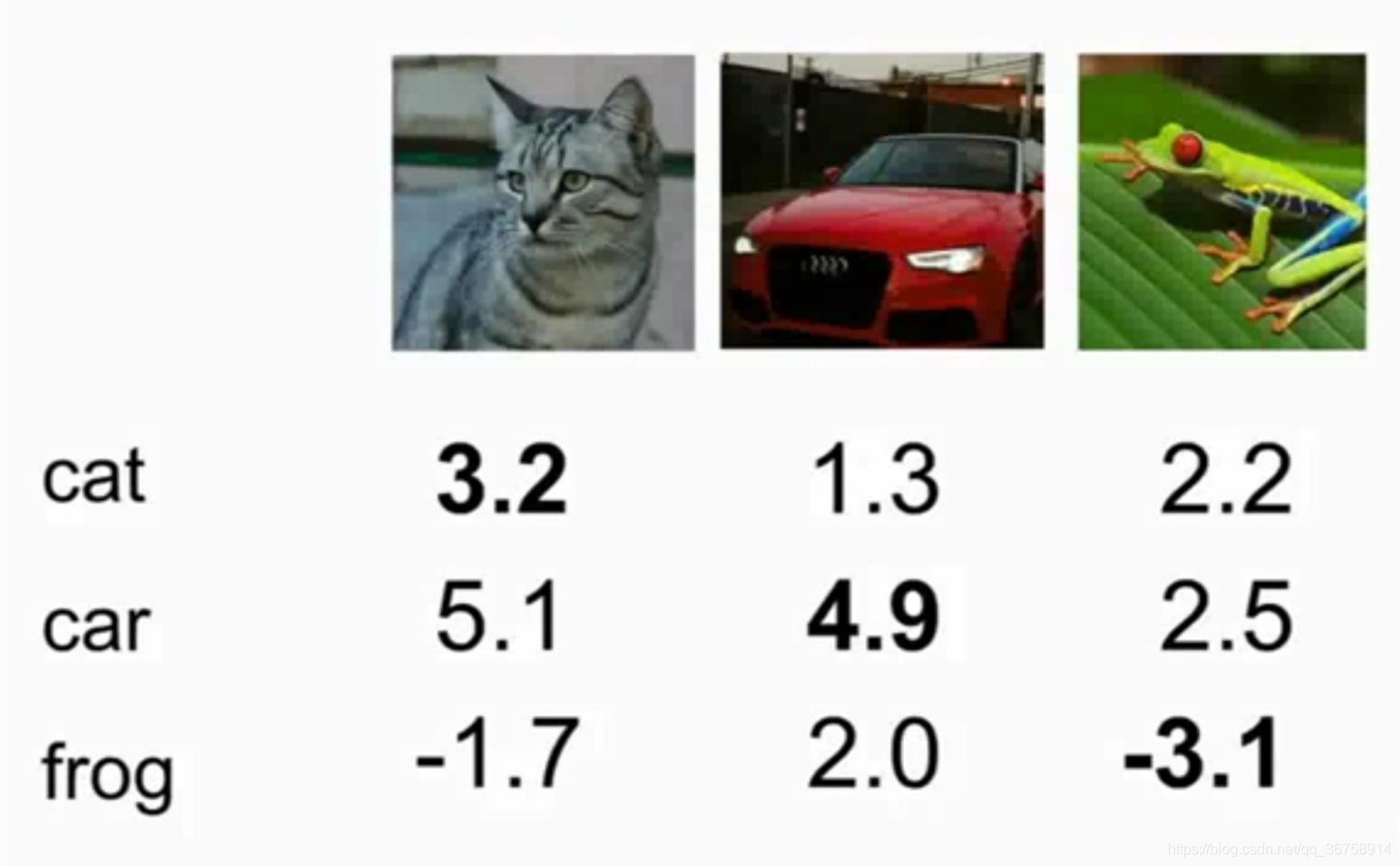

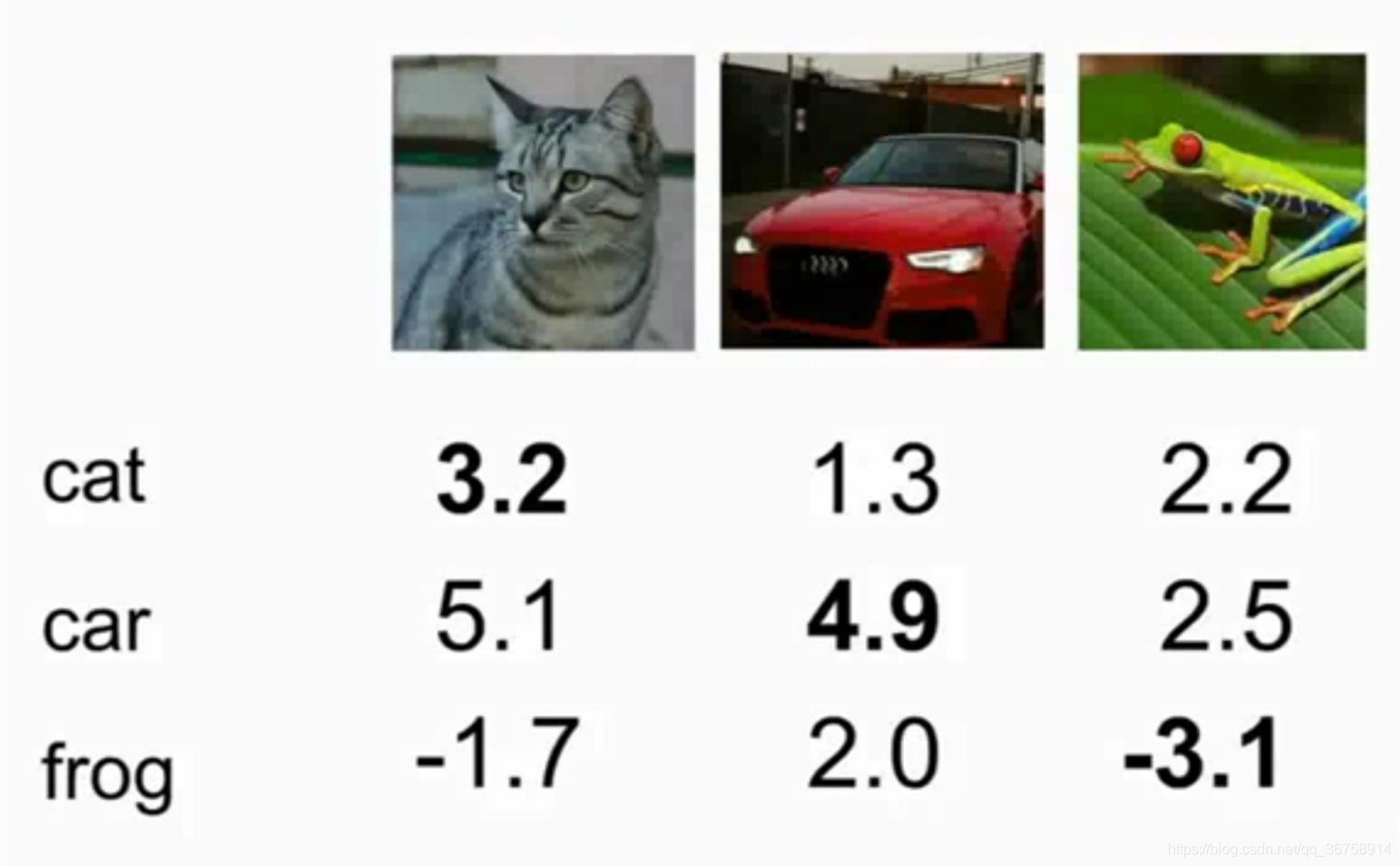

比如下图中,对三张图片进行分类,一共有

cat,car,frog三类。每张图片对应的每个类别的得分如下:

则对于第一张图片,它的hinge loss 为:

则对于第一张图片,它的hinge loss 为:

(5.1−3.2+1)+0=2.9

对于第二张图片,它的hinge loss 为:

0+0=0

对于第三张图片,它的hinge loss 为:

(2.2−(−3.1)+1)+(2.5−(−3.1)+1)=12.9

所以对于这个包含三张图片的数据集来说,其hinge loss为:

L=N1i=1∑NLi

=(2.9+0+12.9)/3=5.27

注:使

L=0的权重

W并不唯一,如

2W同样可以使损失为0。

我们关心的是分类器在测试集而不是训练集中的效果,所以为了防止过拟合,我们使用正则化。

L=N1i=1∑Nj=yi∑max(0,f(xi;W)j−f(xi;W)yi+1)+λR(W)

L2正则化中,

R(W)=∑k∑lWk,l2。

L1正则化中,

R(W)=∑k∑l∣Wk,l∣。

弹性网络(

Elasticnet)正则化中,

R(W)=∑k∑lβWk,l2+∣Wk,l∣。(其实就是

L1+L2)

Softmax loss

输入

xi时,将一张图片定义为第

k个标签的概率为

P(Y=k∣X=xi)=∑jesjesk,其中

s=f(xi;W)。

定义

Li=−logP(Y=yi∣X=xi)=−log(∑jesjesk)。

具体计算过程如下图:

同样地,对于

softmax,正则化同样适用解决过拟合问题。

同样地,对于

softmax,正则化同样适用解决过拟合问题。

则对于第一张图片,它的hinge loss 为:

则对于第一张图片,它的hinge loss 为: 同样地,对于

,正则化同样适用解决过拟合问题。

同样地,对于

,正则化同样适用解决过拟合问题。