VGG和AlexNet都是很经典的模型。而VGG也是在AlexNet的基础之上进行改进的。AlexNet每层仅仅含有一个Convolution层,filter的大小7x7;VGG每层含有2~4个Conv层,filter的大小是3x3(能感受空间最小的filter)。

个人认为,整个文章相比于AlexNet最大的亮点就是更深的卷积层,以及最小的filter。

在本文中,作者讨论了ConvNet架构设计的另一个重要方面-深度。最后,固定了结构的其他参数,并通过添加更多的卷积层来稳定地增加网络的深度,这种方法的可行性是因为在所有层中都使用了非常小的(3*3)的卷积滤波器。

在训练期间,ConvNet的输入是固定大小的224 * 224的RGB图像。唯一的预处理是从每个像素值上减去在训练集上计算的平均RGB值。

图像通过一堆卷积层(是一堆),其中使用具有非常小的接收野的filter:3 * 3(这是捕获左/右,上/下,中心概念的最小尺寸)。卷积步长固定为1个像素;卷积层的输入的空间填充是使得在卷积之后保留空间分辨率,如,对于一个3 * 3的卷积层来说填充是1个像素。

在其中一个配置中,使用了1 * 1的卷积过滤器,这可以看作是输入通道的线性变换(之后接一个非线性变换)。

空间池化是由5个最大池化层执行的,基在一些卷积层后面(不是所有的卷积层之后都跟着最大池化层)。最大池化是在2*2的像素窗口上执行的,步长为2。

关于卷积层

2个3×3的卷积核进行卷积之后,和1个5×5的卷积效果是一样的;3个3×3的卷积核和1个7*7的卷积核进行卷积后的效果是一样的。但是作者为何选择几个3*3而不是一个n×n?

以 (1个7*7=3个3*3为例) :

第一:对于3个3*3,可以引入三个非线性修正层,而不是一个,这使得决策函数更具有辨别力。

第二:减少了参数的数量:假设三层3*3的卷积层的一个堆的输入和输出都具有C个通道(PS:通道就是卷积层的输出数量,还需要注意的是输入也是C个通道,后面的公式就好理解了)。这个堆就由3×(3²C²)=27C²个权重参数化(PS:第一个3是3层,第二个3的平方是filter的大小,因为输入也是C个通道,输出C个通道的每一个的权重都对应着C个,所以是C²)。同时,一个单独的7*7的卷积层将会需要7²C²=49C²个参数,比上面的多了81%还多。这可以被看成是对7*7的卷积过滤器强加了一个正则化,迫使它们通过3*3滤波器(在其间注入非线性)进行分解。

第三:VGG的Channel明显大于AlexNet。猜测VGG的之所以能够达到更高的精准性,源自于更多的Channel数。而由于filter size的减小,channel可以大幅度增加,更多的信息可以被提取。(文章中没有提到,但是在某位作者的博客中看到了。觉得很有道理)

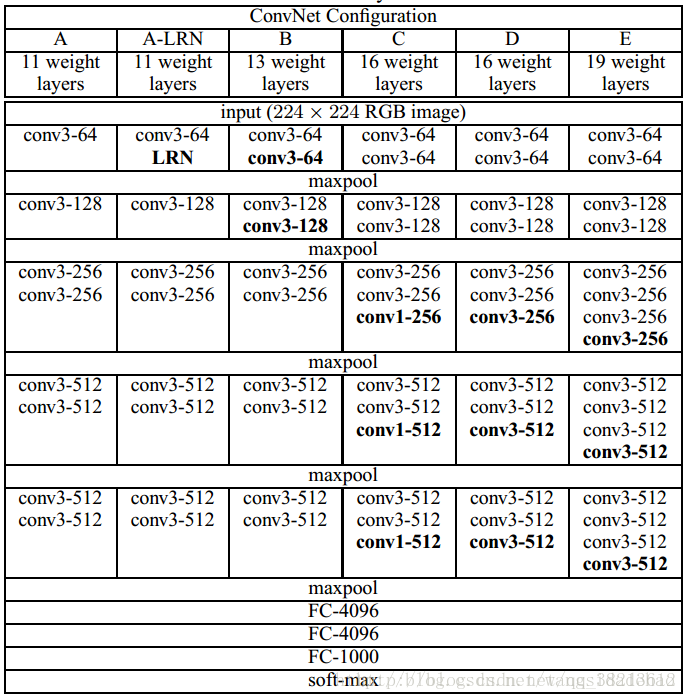

表一:ConvNet配置(以列展示)。配置的深度从左(A)向右(E)增加,因为添加了更多的层(添加的层以粗体表示)。卷积层参数表示成“conv<感受野大小>-<通道数量>”。为了简洁,未展示ReLU激活函数

训练图像大小

训练尺度:S(训练图像的最小侧)

原则上S可以取不小于224的任何值:

对于S=224来说,裁剪将会捕获整个的图像统计数据,将会完整横跨训练图像的最小边。

对于S ≫ 224,裁剪将会对应于图像的一小部分,包括一个小对象,或者对象的一部分。

考虑两种方法来设置训练尺寸S。

第一种就是固定S,这对应于单一尺寸的训练(注意,在抽样裁剪内的图像内容仍然可以代表多尺度的图像统计数据)。

在我们的实验中,我们评估了以两个固定尺寸训练的模型:S = 256(其在先前的工作中被广泛使用(Krizhevsky et al., 2012; Zeiler & Fergus, 2013; Sermanet et al., 2014))和S = 384。给定ConvNet配置,我们首先使用S = 256训练网络。为了加速S=384网络的训练,使用S=256预训练的权重初始化训练,并且我们使用了较小的初始学习率0.001。

设置S的第二种方法是多尺度训练,其中通过从某个范围[Smin, Smax](我们使用Smin=256,并且Smax=512)随机采样S来单独地重新缩放每个训练图像。因为图像中的对象可以具有不同的大小,因此在训练期间将这一点考虑进去是非常有益的。这也可以看成是通过尺寸抖动的训练集增加,其中单个模型被训练以识别大范围尺度上的对象。出于速度上的考虑,我们通过微调具有相同配置的单尺度模型的所有层来训练多尺度模型,用固定的S = 384来预训练。