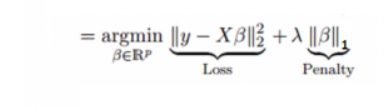

Lasso 的基本思想是在回归系数的绝对值之和小于一个常数的约束条件下,使残差平方和最小化,从而能够产生某些严格等于0 的回归系数,得到可以解释的模型。

Lasso(Least absolute shrinkage and selection operator, Tibshirani(1996))方法是一种压缩估计。它通过构造一个罚函数得到一个较为精炼的模型,使得它压缩一些系数,同时设定一些系数为零。因此保留了子集收缩的优点,是一种处理具有复共线性数据的有偏估计。

https://www.zhihu.com/question/37031188

https://blog.csdn.net/hzw19920329/article/details/77200475

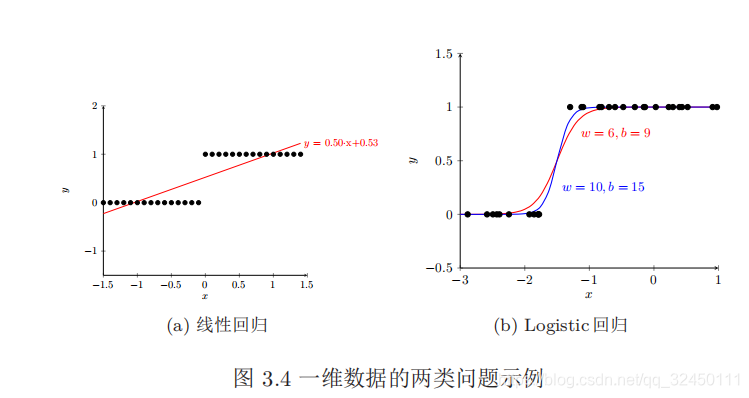

线性回归和逻辑回归的区别

https://blog.csdn.net/jiaoyangwm/article/details/81139362

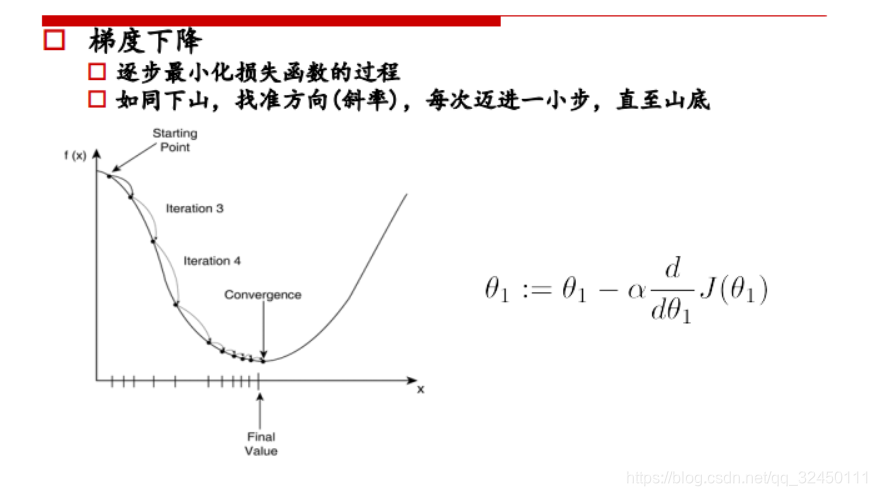

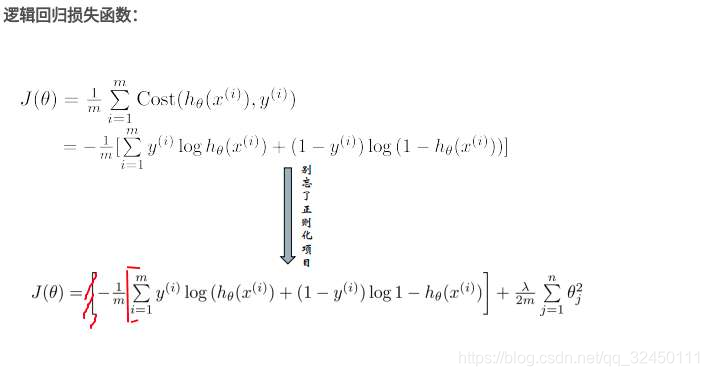

求极值的数学思想,对公式求导=0即可得到极值,但是工业上计算量很大,公式很复杂,所以从计算机的角度来讲,求极值是利用梯度下降法。

只是方便数学计算

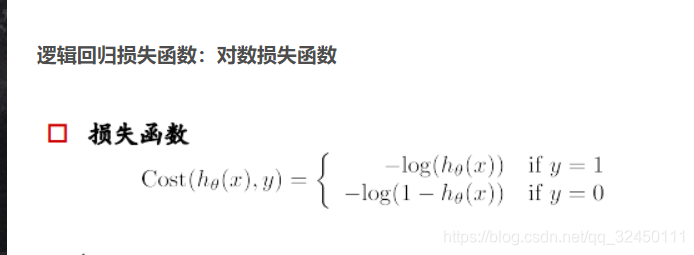

解释:如果一个样本为正样本,那么我们希望将其预测为正样本的概率p越大越好,也就是决策函数的值越大越好,则logp越大越好,逻辑回归的决策函数值就是样本为正的概率;

如果一个样本为负样本,那么我们希望将其预测为负样本的概率越大越好,也就是(1-p)越大越好,即log(1-p)越大越好。

区别

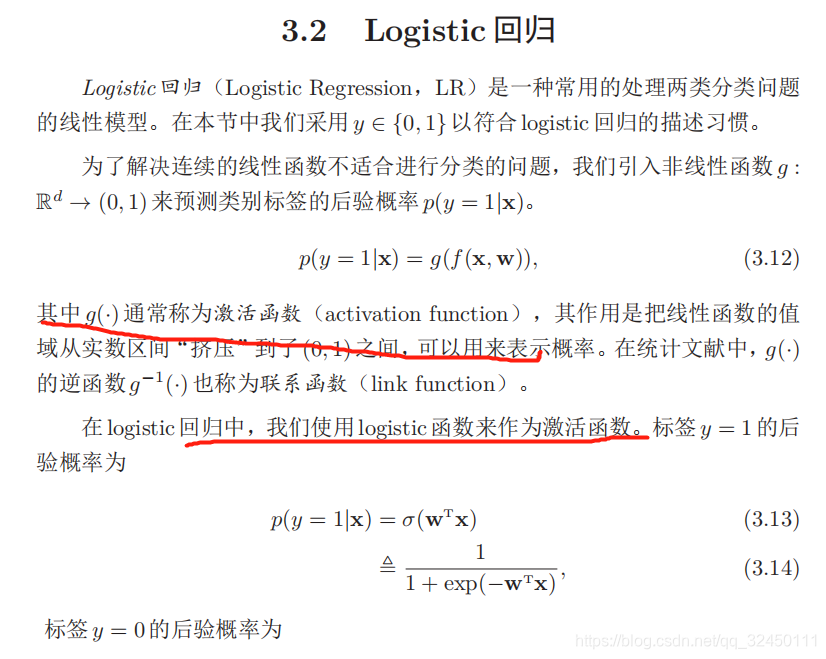

1.其实就是相当于把非线性引入到了线性回归中就变成了逻辑回归

2. 第二个就是在加了log

首先看 伯努利分布下,似然函数的意义: 在知道模型和样本的前提下,求出 样本为正的概率为p 的可能性(即似然值)

https://blog.csdn.net/zhenghaitian/article/details/80968986

nndl LR是交叉熵损失函数

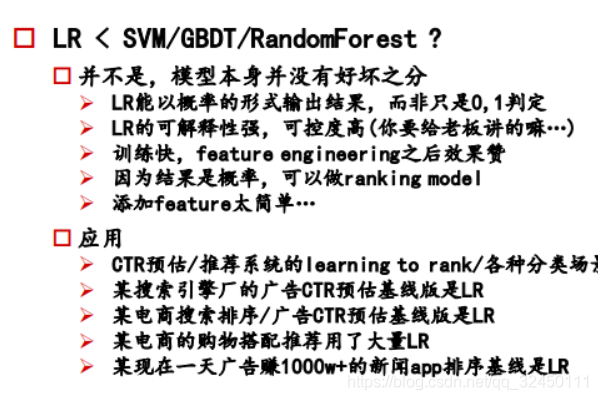

SVM