版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/a940902940902/article/details/89385393

1.信息熵

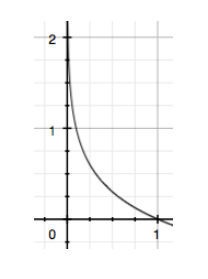

在信源中有n个独立取值的信号,每种信号出现的可能性分布为 p1,p2 ,…pn,且各个符号的出现相互独立,那么整体信源的不确定性为单个符号不确定性的统计平均值(单个信号不确定性为 log(1/p)) 称为信息熵 即 H(U) =E[- log( p )]=-∑ pi log(pi),当所有 pi 取值均相等 即 1/N 时 信息熵取到最大值

上图可见 当一件事情发生的概率越大的时候 其包含的信息量越小 混乱程度也就越小

2. 交叉熵

交叉熵主要用来度量两个概率分布的差异

假设我们具有两个分布 p,q 其中p为真实分布,q为预测分布

H(p,q)=-∑(pi log qi)(当i只有两类取值的时候 就变成了 -(yilog pi+(1-yi)log(1-pi))

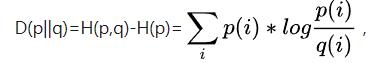

3.K-L散度

对于同一个随机变量 具有两个不同的概率分布 P(x),Q(x),可以使用KL散度来度量这两个分布的差异 按照真实分布来衡量样本的信息熵 H§=-∑ p log§ ,如果使用错误分布来表示真实分布的平均编码长度为 H(p,q)=-∑(pi log qi)