http://playground.tensorflow.org

安装 tf

对tensorflow进行测试

import tensorflow as tf

sess = tf.Session()

a = tf.constant(1)

b = tf.constant(1)

print(sess.run(tf.add(a,b)))

tensorflow使用张量来表示所有数据

关于张量 https://www.jianshu.com/p/2a0f7f7735ad

#常量定义

#原型 tf.constant(数据,dtype = tf.string/int/float32...)

constant = tf.constant(1)

constantstring = tf.constant('Hello')

#变量定义

a = tf.Variable(1.0,dtype = tf.float32)

这些就是TensorFlow最基本的框架

# -*- coding: utf-8 -*-

"""

Created on Sat Mar 16 18:56:53 2019

@author: Administrator

"""

import tensorflow as tf

hello = tf.constant('hello,tensorflow!') #定义常变量

sess = tf.Session() #建立一个session

print(sess.run(hello)) #通过session运行run中的变量

sess.close()

#with session

a = tf.constant(3)

b = tf.constant(4)

with tf.Session() as sess:

print("相加%i" % sess.run(a+b))

print("相乘%i" % sess.run(a*b))

#注入

c = tf.placeholder(tf.int16) #占位

d = tf.placeholder(tf.int16)

add = tf.add(c,d)

mul = tf.multiply(c,d)

with tf.Session() as sess2:

#输出

print("相加%i" % sess2.run(add, feed_dict = {c:3,d:4}))

print("相加%i" % sess2.run(mul, feed_dict = {c:5,d:6}))

print(sess2.run([add,mul],feed_dict = {c:5,d:6}))

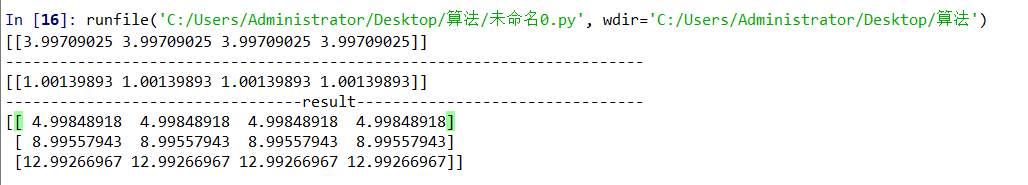

矩阵计算

import tensorflow as tf

import numpy as np

#制造数据集

inputX = np.random.rand(3000,1) #通过本函数可以返回一个或一组服从标准正态分布的随机样本值

noise = np.random.normal(0,0.05,inputX.shape) #随机生成噪声数据

outputY = inputX * 4 + 1 + noise #实际值

#设计节点(模型参数)

weight1 = tf.Variable(np.random.rand(inputX.shape[1],4))

bias1 = tf.Variable(np.random.rand(inputX.shape[1],4))

x1 = tf.placeholder(tf.float64,[None,1]) #占位符 等待数据输入 列为1行数不确定

y1_ = tf.matmul(x1,weight1) + biasl #预测值(可以看成一种算子)

y = tf.placeholder(tf.float64,[None,1]) #占位符 等待数据输入 列为1行数不确定

loss = tf.reduce_mean(tf.reduce_sum(tf.square((y1_ - y)),reduction_indices = [1] )) #计算方差

train = tf.train.GradientDescentOptimizer(0.25).minimize(loss) #使用梯度下降

#初始化框架

init = tf.global_variables_initializer() #初始化框架

sess = tf.Session()

sess.run(init)

for i in range(1000): #最多执行1000次

sess.run(train,feed_dict = {x1:inputX,y:outputY}) #使用train这种算子进行运算

print(weight1.eval(sess))#输出weight

print("-----------------------------------------------------------------------")

print(bias1.eval(sess))#输出biasl

print("---------------------------------result--------------------------------")

x_data = np.matrix([[1.],[2.],[3.]]) #代入x_data计算

print(sess.run(y1_,feed_dict = {x1:x_data})) #使用y1这种算子进行运算

而且可以看到每次拟合的数值是不一样的

下面再加入一层网络

import tensorflow as tf

import numpy as np

#制造数据集

inputX = np.random.rand(3000,1) #通过本函数可以返回一个或一组服从标准正态分布的随机样本值

noise = np.random.normal(0,0.05,inputX.shape) #随机生成噪声数据

outputY = inputX * 4 + 1 + noise #实际值

#设计节点(模型参数)

#第一层

weight1 = tf.Variable(np.random.rand(inputX.shape[1],4))

bias1 = tf.Variable(np.random.rand(inputX.shape[1],4))

x1 = tf.placeholder(tf.float64,[None,1]) #占位符 等待数据输入 列为1行数不确定

y1_ = tf.matmul(x1,weight1) + bias1 #预测值(可以看成一种算子)

#第二层

weight2 = tf.Variable(np.random.rand(4,1))

bias2 = tf.Variable(np.random.rand(inputX.shape[1],1))

y2_ = tf.matmul(y1_,weight2) + bias2 #预测值(可以看成一种算子)

y = tf.placeholder(tf.float64,[None,1]) #占位符 等待数据输入 列为1行数不确定

loss = tf.reduce_mean(tf.reduce_sum(tf.square((y2_ - y)),reduction_indices = [1] )) #计算方差

train = tf.train.GradientDescentOptimizer(0.25).minimize(loss) #使用梯度下降

#初始化框架

init = tf.global_variables_initializer() #初始化框架

sess = tf.Session()

sess.run(init)

for i in range(1000): #最多执行1000次

sess.run(train,feed_dict = {x1:inputX,y:outputY}) #使用train这种算子进行运算

print(weight.eval(sess))#输出weight

print("-----------------------------------------------------------------------")

print(biasl.eval(sess))#输出biasl

print("---------------------------------result--------------------------------")

x_data = np.matrix([[1.],[2.],[3.]]) #代入x_data计算

print(sess.run(y2_,feed_dict = {x1:x_data})) #使用y2这种算子进行运算关于函数:

关于维度(涉及reduction_indices函数)

reduction_indices

作者:黄璞

链接:https://www.zhihu.com/question/51325408/answer/125426642

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

0. 到底操作哪个维度??

sum这个操作完全可以泛化为任意函数,我们就以sum为例,来看看各种情况。

首先是1维(按照tensorflow的说法其实是0维,后面会说)就是这样:

a = 1 sum(a) => 1那么看看2维的情况,为了看的更清楚,特意写成了矩阵的形式:

a = [[1,2], [3,4]] sum(a) => ???仔细观察,那么问题来了,

sum(a)到底应该是多少?有人说,当然是[3, 7](“横着加”[[1+2],[3+4]]),有人说 不应该是[4, 6](“竖着加”[[1+3],[2+4]])吗?还有人或说,不应该是10(全加在一起)吗?谁是对的?

都是对的。

所以,对于多维数组元素的相加,如果不指定“如何加”,结果是未定义的,之所以有些时候没有指定也可以得到结果,是因为不同的软件或框架有默认的行为。对于tensorflow,默认行为是最后一种,也就是全加在一起。

1. 什么是维度?什么是轴(axis)?如何索引轴(axis)?

注:对Axis比较熟悉的读者可跳过这部分解释,只看加粗字体。

这是一个很大的问题,到底什么是维度呢?维基百科说:

维度,又称维数,是数学中独立参数的数目。在物理学和哲学的领域内,指独立的时空坐标的数目。

0维是一点,没有长度。1维是线,只有长度。2维是一个平面,是由长度和宽度(或曲线)形成面积。3维是2维加上高度形成“体积面”。虽然在一般人中习惯了整数维,但在分形中维度不一定是整数,可能会是一个非整的有理数或者无理数。妈呀,好复杂,我只是想写个tensorflow代码呀。

那么,编程时,你就可以简单的认为:

维度是用来索引一个多维数组中某个具体数所需要最少的坐标数量。

把这句话多读几遍,我想你肯定会有所顿悟。这里之所以说第一个1维的例子时0维,是因为,一个数字根本不需要索引,因为就只有一个呀。所有不同维度的形式如下:

0维,又称0维张量,数字,标量:1

1维,又称1维张量,数组,vector:[1, 2, 3]

2维,又称2维张量,矩阵,二维数组:[[1,2], [3,4]]

3维,又称3维张量,立方(cube),三维数组:[ [[1,2], [3,4]], [[5,6], [7,8]] ]

n维:你应该get到点了吧~

再多的维只不过是是把上一个维度当作自己的元素

1维的元素是标量,2维的元素是数组,3维的元素是矩阵。

从0维到3维,边看边念咒语“维度是用来索引一个多维数组中某个具体数所需要最少的坐标。”

在纸上写写看,想要精确定位一个数字,需要几个数字呢?比如上面例子中的3维数组,我们想要3这个数字,至少要3个数字定位,它的坐标是(0为索引起点):[0, 1, 0]

好了,现在就能说了,什么是轴(axis),如何索引axis(代码中常用的变量名,后文就用axis代表轴)。

什么是axis,编程时,你就可以简单的认为:

axis是多维数组每个维度的坐标。

同样,把这句话多读几遍,我想你一定有体悟。

还拿3维来说,数字3的坐标是[0, 1, 0],那么第一个数字0的axis是0,第二个数字1的axis是1,第三个数字0的axis是2。

让我们再看看我们是如何得到3这个数字的:

- 找到3所在的2维矩阵在这个3维立方的索引:0

- 找到3所在的1维数组在这个2维矩阵的索引:1

- 找到3这个数这个1维数组的索引:0

(这里最好写在纸上看一看,括号比较多。)

也就是说,对于[ [[1,2], [3,4]], [[5,6], [7,8]] ]这个3维情况,[[1,2],[3,4]], [[5,6], [7,8]]这两个矩阵(还记得吗,高维的元素低一个维度,因此三维立方的元素是二维矩阵)的axis是0,[1,2],[3,4],[5,6],[7,8]这4个数组(二维矩阵的元素是一维数组)的axis是1,而1,2,3,4,5,6,7,8这8个数的axis是2。

越往里axis就越大,依次加1。

那么,对于3维的情况,令a = [ [[1,2], [3,4]], [[5,6], [7,8]] ],tf.reduce_sum(a, axis=1)应该输出[[ 4, 6], [12, 14]],这就是处在axis=1的4个数组相加的结果,并reduce掉了一个维度。

这里需要注意的是,axis可以为负数,此时表示倒数第axis个维度,这和Python中列表切片的用法类似。

那么什么是reduce呢?

2. 什么是reduce

reduce这个词字面上来讲,大多称作“归约”,但这个词太专业了,以至于第一眼看不出来意思。我更倾向于解释为“塌缩”,这样就形象多了。对一个n维的情况进行reduce,就是将执行操作的这个维度“塌缩”。还是上面tf.reduce_sum(a, axis=1)的例子,输出[[ 4, 6], [12, 14]]是二维,显然是被“塌缩”了,塌缩的哪个维度呢?就是被操作的维度,第2个维度,也就是axis=1(0开始索引)。tf.reduce_sum(a, axis=1)具体执行步骤如下:

- 找到a中axis=1的元素,也就是[1,2],[3,4],[5,6],[7,8]这4个数组(两两一组,因为前两个和后两个的地位相同)

- 在axis=1的维度进行相加也就是[1,2]+[3,4]=[4,6],[5,6]+[7,8]=[12, 14]

- “塌缩”这一维度,也就是说“掉一层方括号”,得出[[ 4, 6], [12, 14]]

接下来是一个附加问题:

3. 什么是keepdims

上面的reduce已经解释了,“塌缩”的是被操作的维度,那么keepdims也就是保持维度,直观来看就是“不掉一层方括号”,不掉哪层方括号呢?就是本来应该被塌缩的那一层(详细解释见评论)。tf.reduce_sum(a, axis=1, keepdims=True)得出[[[ 4, 6]], [[12, 14]]],可以看到还是3维。这种尤其适合reduce完了要和别的同维元素相加的情况。

最后来做个练习吧,对于四维情况[ [ [[1,2], [3,4]] ], [ [[3,4], [5,6]] ] ],对axis=0,1,2,3分别在草稿纸上进行演算后,用tensorflow做个验证吧~

tf.reduce_mean 函数用于计算张量tensor沿着指定的数轴(tensor的某一维度)上的的平均值,主要用作降维或者计算tensor(图像)的平均值。

1.tf.multiply()两个矩阵中对应元素各自相乘

格式: tf.multiply(x, y, name=None)

参数:

x: 一个类型为:half, float32, float64, uint8, int8, uint16, int16, int32, int64, complex64, complex128的张量。

y: 一个类型跟张量x相同的张量。

返回值: x * y element-wise.

注意:

(1)multiply这个函数实现的是元素级别的相乘,也就是两个相乘的数元素各自相乘,而不是矩阵乘法,注意和tf.matmul区别。

(2)两个相乘的数必须有相同的数据类型,不然就会报错。2.tf.matmul()将矩阵a乘以矩阵b,生成a * b。

格式: tf.matmul(a, b, transpose_a=False, transpose_b=False, adjoint_a=False, adjoint_b=False, a_is_sparse=False, b_is_sparse=False, name=None)

参数:

a: 一个类型为 float16, float32, float64, int32, complex64, complex128 且张量秩 > 1 的张量。

b: 一个类型跟张量a相同的张量。

transpose_a: 如果为真, a则在进行乘法计算前进行转置。

transpose_b: 如果为真, b则在进行乘法计算前进行转置。

adjoint_a: 如果为真, a则在进行乘法计算前进行共轭和转置。

adjoint_b: 如果为真, b则在进行乘法计算前进行共轭和转置。

a_is_sparse: 如果为真, a会被处理为稀疏矩阵。

b_is_sparse: 如果为真, b会被处理为稀疏矩阵。

name: 操作的名字(可选参数)

返回值: 一个跟张量a和张量b类型一样的张量且最内部矩阵是a和b中的相应矩阵的乘积。

注意:

(1)输入必须是矩阵(或者是张量秩 >2的张量,表示成批的矩阵),并且其在转置之后有相匹配的矩阵尺寸。

(2)两个矩阵必须都是同样的类型,支持的类型如下:float16, float32, float64, int32, complex64, complex128。

引发错误:np.random.rand()函数 https://blog.csdn.net/qq_40130759/article/details/79535575