多元线性回归

主要是对于线性回归的深化

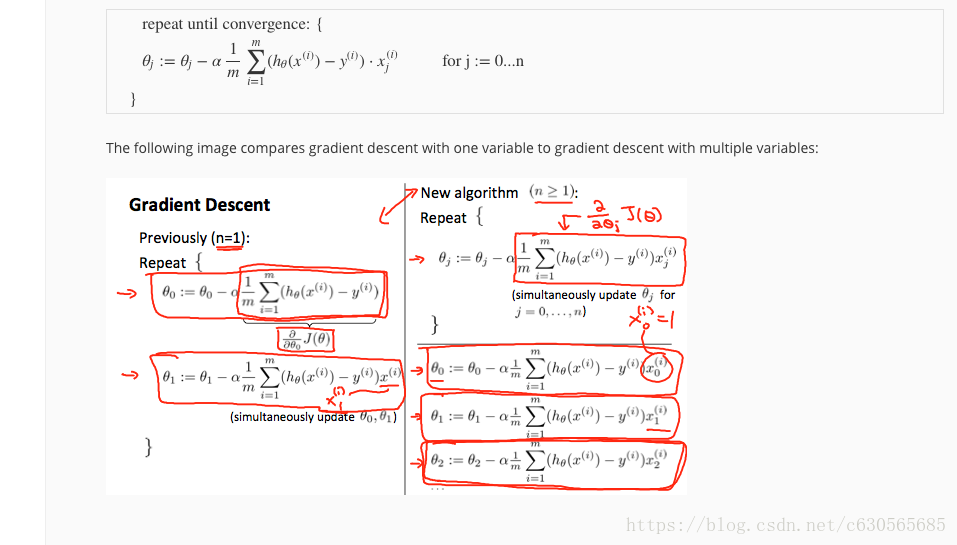

针对每一次迭代中的第j的参数,将前一次的该参数值减去步长a*代价函数对于此参数的导数,注意多参数时需要先完成本次迭代即更新完n个参数之后才能进行下一次更新,不能将刚更新的参数带入到后更新的参数更新过程中去。

坐标系理解就是在此参数的维度上不断靠近最低点,每次都减去步长乘斜率,而随着迭代,斜率会越来越小最终降为0,到达此参数维度上的最低点,而拥有多个参数同事到达最低点时即代价函数达到最小,拟合结束。

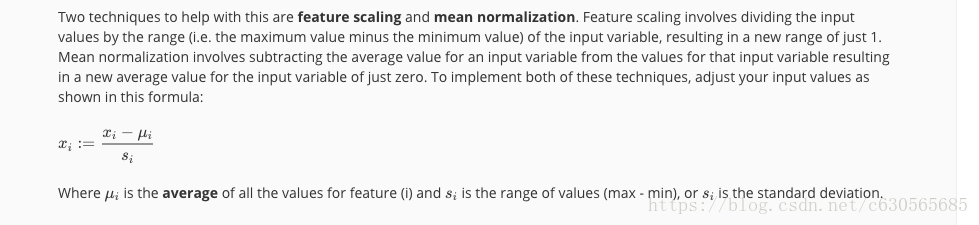

针对数据集样本有多个属性,各个属性xi定义域的大小相差悬殊,这导致在后面迭代回归时速度较慢,效率较低,因此采用图中的方式将数据集的数据进行规格化(我取的名字)。xi=(原来的xi-此属性上所有数据的平均值)/此属性的max-min