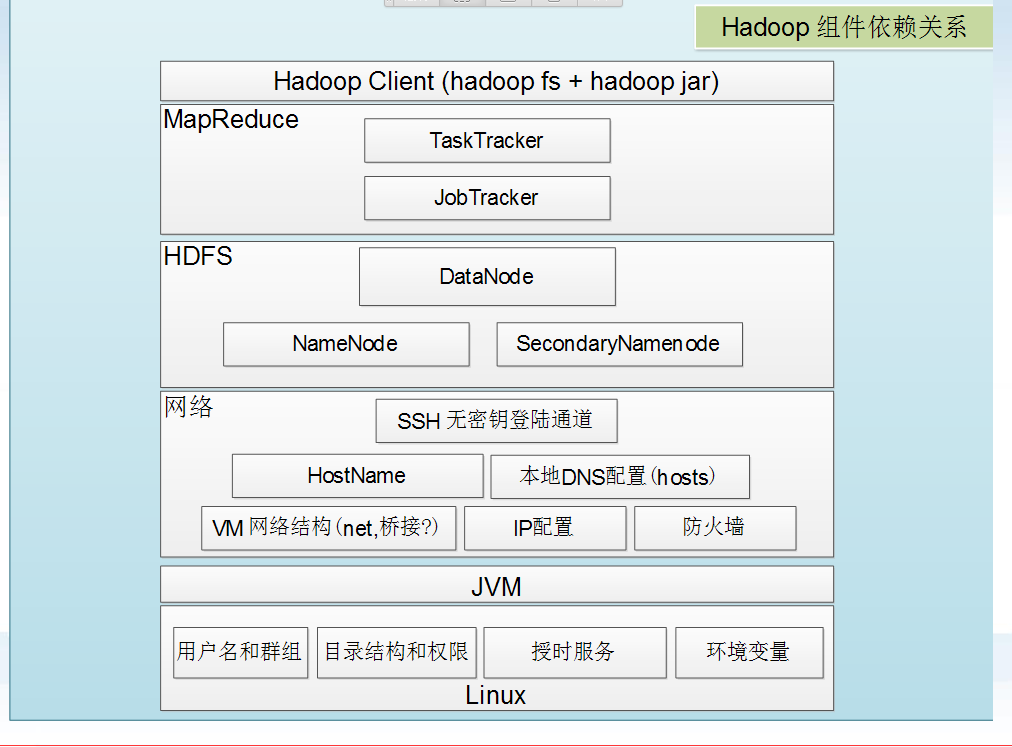

一、hadoop组件依赖关系

二、hadoop日志格式:

两种日志,分别以out和log结尾:

1 以log结尾的日志:通过log4j日志记录格式进行记录的日志,采用日常滚动文件后缀策略来命名日志文件,内容比较全。

2 以out结尾的日志:记录标准输出和标注错误的日志,内容比较少。默认的情况,系统保留最新的5个日志文件。

可以在/etc/hadoop/hadoop-env.sh中进行配置:

33 #Where log files are stored. $HADOOP_HOME/logs by default. 34 #export HADOOP_LOG_DIR = ${HADOOP_HOME}/logs

日志名称的解释:

二、hadoop启动和停止:

第一种方式:

启动:

start-dfs.sh

start-mapred.sh(hadoop 2.x为 start-yarn.sh)

停止:

stop-dfs.sh

stop-mapred.sh(Hadoop 2.x为 stop-yarn.sh)

全部启动:

start-all.sh

启动顺序:NameNode --> DataNode --> Secondary NameNode --> JobTracker --> TaskTracker

全部停止:

stop-all.sh

停止顺序:JobTracker --> TaskTracker --> NameNode --> DataNode --> Secondary NameNode

第二种方式(守护进程逐一启动和关闭):

启动:

1 hadoop-daemon.sh start namenode 2 hadoop-daemon.sh start datanoe 3 hadoop-daemon.sh start secondarynamenode 4 hadoop-daemon.sh start jobtracker 5 hadoop-daemon.sh start tasktracker

启动顺序和上面的启动顺序一样:NameNode --> DataNode --> Secondary NameNode --> JobTracker --> TaskTracker

停止:

1 1 hadoop-daemon.sh stop jobtracker 2 2 hadoop-daemon.sh stop tasktracker 3 3 hadoop-daemon.sh stop namenode 4 4 hadoop-daemon.sh stop datanoe 5 5 hadoop-daemon.sh stop secondarynamenode