1.机器学习的一些概念:

a.有监督学习:训练数据既有特征(feature)又有标签(lable),通过训练,让机器可以自己找到特征和标签之间的联系,在面对只有特征没有标签的数据时,可以判断出标签。

b.无监督学习:训练样本的标记信息未知,,目标是通过对无标记训练样本的学习来揭示数据的内在性质,及规律,为进一步的数据分析提供基础,此类学习任务中研究最多,应用最广的是聚类,其他的无监督算法还有密度估计、异常检测等

c.半监督学习:训练集同时包含有标记样本数据和未标记样本数据,不需要人工干预,让学习器不依赖外界交互、自动的利用未标记样本来提升学习性能,就是半监督学习

d.主动学习:有的时候,有列表的数据比较稀少,而没有类标的数据很多,但是对数据进行人工标注又非常昂贵,这时候,学习算法可以主动地提出一些标注请求,将一些经过筛选的数据提交给专家进行标注,这哥筛选过程也就是主动学习主要研究的地方

注:半监督学习和主动学习属于利用未标记数据的学习技术,只是其基本思想不同。

e.泛化能力:泛化能力就是模型对未知数据的预测能力。在实际当中,我们通常通过测试误差来评价学习方法的泛化能力。

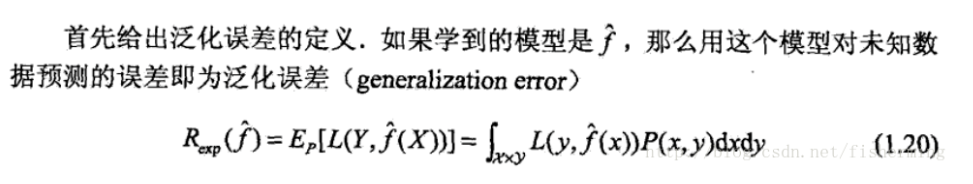

f.泛化误差的定义:泛化误差就是所学习到的模型的风险函数或期望损失

g.泛化误差上界:学习方法的泛化能力分析往往是通过研究泛化误差的概率上界进行的,简称为泛化误差上界,具体来说,就是通过比较两种学习方法的泛化误差上界的大小来比较他们的优劣。泛化误差上界通常具有以下性质:

i.他是样本容量的函数,当样本容量增加时,泛化上界趋于0

ii.他是假设空间容量的函数,假设空间容量越大,模型就越难学,泛化误差上界就越大。

h.欠拟合:欠拟合就是模型没有很好的捕捉到数据特征,不能够很好的拟合数据。在训练集上表现为高偏差,低方差

欠拟合解决方法:

§添加其他特征项

§添加多项式特征,将线性模型通过添加二次项或者三次项让模型泛化能更强。

§减少正则化参数,正则化的目的是用老防止过拟合的,但是现在模型出现了欠拟合,则需要减少正则化参数

i.过拟合:过拟合就是模型把数据学习的太彻底了,以至于把噪声数据的特征也学习到了,这样就导致后期测试的时候不能很好的识别数据,即不能正确的分类。在训练集上具有高方差和低偏差

过拟合解决方法:

§重新清晰数据

§增大数据的训练量

§采用正则化方法。

j.交叉验证:交叉验证是在机器学习建立模型和验证模型参数是常用的方法。交叉验证,顾名思义,就是重复的使用数据,把得到的样本数据进行切分,组合为不同的训练集和测试集,用训练集来训练模型,用测试集来评估模型预测的好坏。在此基础上可以得到多组不同的训练集和测试集,某次训练集中的某样本在下次可能成为测试集中的样本,即所谓“交叉”。交叉验证根据切分的方法不同,交叉验证分为下面三种:

§简单交叉验证

§S折交叉验证

§留一交叉验证