前情提要—— 网上关于目标检测框架——faster r_cnn有太多太好的博文,这是我在组会讲述faster r_cnn这一框架时被人问到的一个点,当时没答上来,于是会下好好百度和搜索一下研究了一下这个问题。

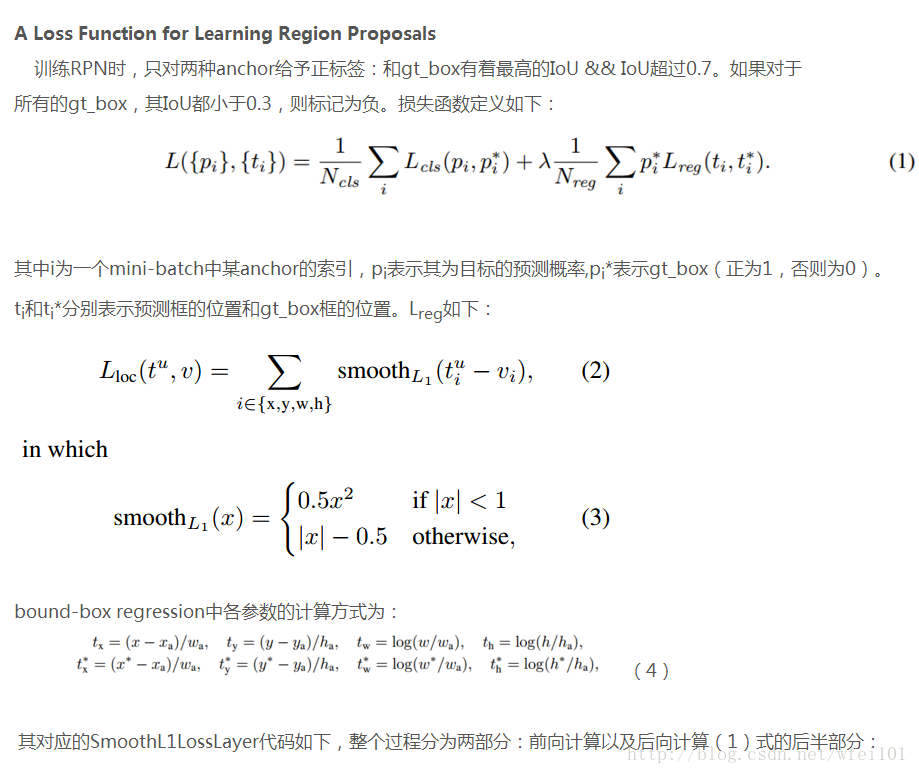

先看faster r_cnn的对bounding_box的回归损失函数:

百度百科的解释是:对于边框的预测是一个回归问题。通常可以选择平方损失函数(L2损失):f(x)=x^2。但这个损失对于比较大的误差的惩罚很高。我们可以采用稍微缓和一点绝对损失函数(L1损失):f(x)=|x|,它是随着误差线性增长,而不是平方增长。但这个函数在0点处导数不唯一(这里应该是0点两边的导数,因为0点处导数不存在),因此可能会影响收敛。一个通常的解决办法是在0点附近使用平方函数使得它更加平滑。它被称之为平滑L1损失函数,它通过一个参数sigma来控制平滑的区域。

牛客网的解释:是当预测值与目标值相差很大时,L2 Loss的梯度为(x-t),容易产生梯度爆炸,L1 Loss的梯度为常数,通过使用Smooth L1 Loss,在预测值与目标值相差较大时,由L2 Loss转为L1 Loss可以防止梯度爆炸。