Beyond Correlation Filters: Learning Continuous Convolution Operators for Visual Tracking

论文地址:https://arxiv.org/pdf/1608.03773.pdf https://github.com/martin-danelljan/Continuous-ConvOp

Discriminative Correlation Filters(DCF) 在目标追踪方面表现出极大的优势。其成功的关键在于能有效地利用训练样本的所有平移版本作为可利用的负样本。但是,DCF 模式本身被限定在单分辨率特征图上,极大地束缚了其潜力。这篇论文突破传统的 DCF 方法,提出了一个新的训练连续卷积滤波器的方法。作者使用一个内插模型把学习问题放置于连续的空间域中。它能有效地集成多分辨率深度特征图,在3个目标跟踪 benchmarks 上表现优越:OTB-2015(+ 5.1% in mean OP), Temple-Color(+4.6% in mean OP), VOT2015(在失败率上降低了20%)。此外,此方法能进行亚像素(sub-pixel)定位,这对高精度的特征点追踪至关重要。

目标跟踪是一个计算视频中目标轨迹的任务,这是计算机视觉中的基础问题之一。目标或特征点跟踪在机器人和安防等领域有着广泛应用。近些年,基于 DCF 的方法在目标跟踪 benchmarks 上成绩斐然。DCF 方法训练一个 相关滤波器(correlation filter) 来预测目标分类分数。与其他方法不同,DCF 通过离散傅里叶变换,高效地利用训练样本所有的空间位移 。

CNNs 在很多任务上的表现令人印象深刻,因而产生了将其与 DCF 跟踪器结合的想法。CNN 包括了卷积,归一化与池化等多层。最近,最后的卷积层的特征图已经被运用到图像分类。深层卷积的特征有足够的判别度,同时保存了空间和结构信息。但是近期基于 DCF 的方法则展现了浅层卷积层的重要性,这些层提供了更高的分辨率,对于精准的目标定位至关重要。然而,如何将多个卷积层融入 DCF 框架仍有待探讨。

传统 DCF 模式受限于单精度特征图。因此,所有的特征通道必须有一样的空间分辨率,比如 HOG 描述器。这个限制阻碍了具有不同分辨率的卷积层进行融合。解决这个限制的直接方法就是,对所有的特征通道重新采样,使得它们的分辨率一致。但是,重新采样的过程不仅繁琐,而且增加了人工干预的成分。

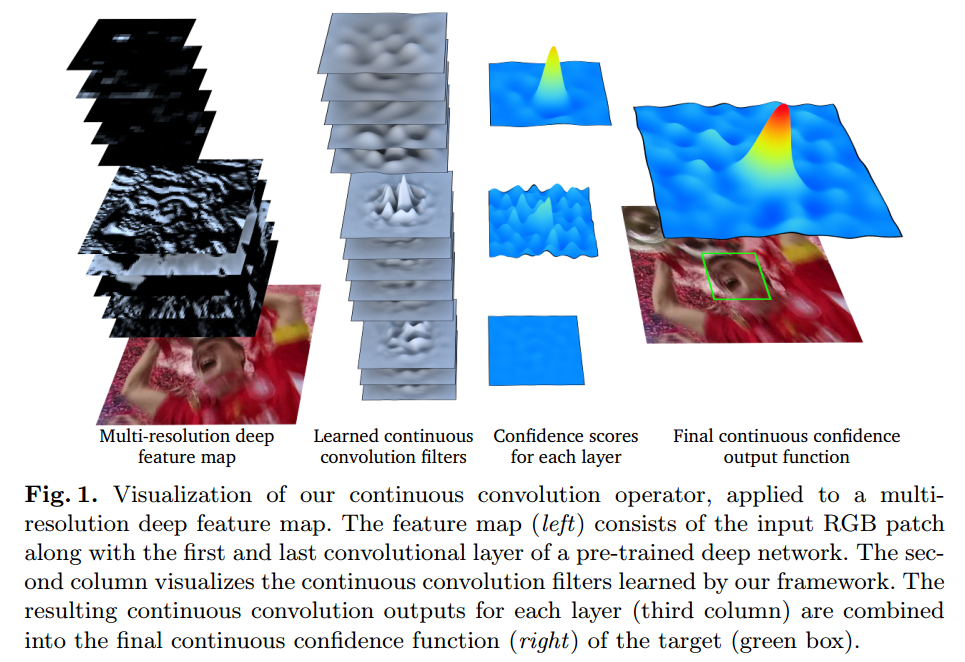

这篇论文提出了一个在连续空间域中学习卷积算子的新型方法。它在训练样本上使用了一个内插模型,学习一组卷积滤波器,对目标物体生成一个连续域置信图(continuous-domain confidence map)。这使得多分辨率特征图在一个联合学习的方法中完美融合。图一展示了在融合多分辨率特征图时,连续卷积算子(continuous convolution operator)操作的可视化。

除了多分辨率融合,此连续域学习方法能够精准地进行亚像素定位,这是通过将训练样本利用亚像素精度的连续置信图进行标定得到的。我们的方法因此适用于准确的特征点跟踪。作在 MPI Sintel 数据集上进行了准确性和鲁棒性测试。

DCF 方法在目标追踪上成绩不错。它以滑动窗口的方式,利用循环相关特性 (circular correlation)特性来训练回归器。最初,DCF 方法被限制在单特征通道。后来,DCF 框架被推广到了多通道特征图。多通道的 DCF 允许使用高维度特征来提升追踪效果,比如 HOG 和 Color Names。除了加入多通道特征,DCF 框架现已通过加入尺度估计,非线性核,长时跟踪,以及改善循环卷积的周期效应,极大地提高了性能。

最近人们发现,CNNs 最后的卷积层对图像分类很有用,另一方面,浅层卷积层很适合用于目标追踪。较深的卷积层判别力强,能找出复杂的特征。浅的卷积层识别的特征较简单,但是空间分辨率高,很适合定位使用。作者在联合学习框架中提出了一个新型的连续方程,用于融合多个不同空间分辨率的卷积层。

与目标追踪不同,特征点追踪是要高精度地计算关键点的运动轨迹。经典方法有 Kanade-Lucas-Tomasi 追踪器。 KLT 追踪器是一个生成模型,最小化两个图片区域的均方误差。但是,作者针对特征点追踪,提出了一个可区分性的基于学习的方法。

本文方法 :提出了一个理论框架,在连续空间域中学习可区分性的卷积算子。和传统 DCF 方法比,它有2个优势:

自然地融合多通道特征图,例如卷积层和多分辨率HOG特征及色彩特征的结合;

能够精准进行亚像素定位。

作者在这篇论文里使用了连续傅里叶分析里的概念和结论。为了清晰可见,作者首先介绍了一维空间中的数据学习方法(只有一个 spatial variable 的函数)。然后推广到高维空间,包括图像。

我们考虑复值函数

g

:

R

→

C

g: \mathbb{R}\rightarrow \mathbb{C}

g : R → C

L

2

(

T

)

L^2(T)

L 2 ( T )

g

g

g

T

>

0

T>0

T > 0

L

2

(

T

)

L^2(T)

L 2 ( T )

⟨

⋅

,

⋅

⟩

\langle \cdot,\cdot \rangle

⟨ ⋅ , ⋅ ⟩

g

,

h

∈

L

2

(

T

)

g,h\in L^2(T)

g , h ∈ L 2 ( T )

⟨

g

,

h

⟩

=

1

T

∫

0

T

g

(

t

)

h

(

t

)

‾

d

t

,

g

∗

h

(

t

)

=

1

T

∫

0

T

g

(

t

−

s

)

h

(

s

)

d

s

.

(

1

)

\langle g,h \rangle = \frac{1}{T}\int_0^T g(t)\overline{h(t)}dt,\quad\quad g\ast h(t) = \frac{1}{T}\int_0^T g(t-s)h(s) ds.\quad\quad\quad (1)

⟨ g , h ⟩ = T 1 ∫ 0 T g ( t ) h ( t ) d t , g ∗ h ( t ) = T 1 ∫ 0 T g ( t − s ) h ( s ) d s . ( 1 )

横线表示复数共轭。(1)式中作者定义了循环卷积算子(circular convolution operator)

∗

:

L

2

(

T

)

×

L

2

(

T

)

→

L

2

(

T

)

.

\ast: L^2(T)\times L^2(T) \rightarrow L^2(T).

∗ : L 2 ( T ) × L 2 ( T ) → L 2 ( T ) .

在推导过程中,作者使用了复数指数函数

e

k

(

t

)

=

e

i

2

π

T

k

t

e_k(t) = e^{i \frac{2\pi}{T}kt}

e k ( t ) = e i T 2 π k t

{

e

k

}

−

∞

∞

\{e_k\}^{\infin}_{-\infin}

{ e k } − ∞ ∞

L

2

(

T

)

L^2(T)

L 2 ( T )

g

∈

L

2

(

T

)

g\in L^2(T)

g ∈ L 2 ( T )

g

^

[

k

]

=

⟨

g

,

e

k

⟩

\hat g[k]=\langle g,e_k \rangle

g ^ [ k ] = ⟨ g , e k ⟩

g

∈

L

2

(

T

)

g \in L^2(T)

g ∈ L 2 ( T )

g

=

∑

−

∞

+

∞

g

^

[

k

]

e

k

g=\sum_{-\infin}^{+\infin} \hat g[k]e_k

g = ∑ − ∞ + ∞ g ^ [ k ] e k

∣

∣

g

∣

∣

2

=

∣

∣

g

^

∣

∣

l

2

2

||g||^2=||\hat g||^2_{l^2}

∣ ∣ g ∣ ∣ 2 = ∣ ∣ g ^ ∣ ∣ l 2 2

∣

∣

g

∣

∣

2

=

⟨

g

,

g

⟩

||g||^2 = \langle g,g \rangle

∣ ∣ g ∣ ∣ 2 = ⟨ g , g ⟩

∣

∣

g

^

∣

∣

l

2

2

=

∑

−

∞

∞

∣

g

^

[

k

]

∣

2

||\hat g||^2_{l^2} = \sum_{-\infin}^{\infin} |\hat g[k]|^2

∣ ∣ g ^ ∣ ∣ l 2 2 = ∑ − ∞ ∞ ∣ g ^ [ k ] ∣ 2

l

2

l^2

l 2

g

∗

h

^

=

g

^

h

^

\widehat {g \ast h} = \hat g \hat h

g ∗ h

= g ^ h ^

g

h

^

=

g

^

∗

h

^

\widehat{gh}=\hat g \ast \hat h

g h

= g ^ ∗ h ^

g

^

∗

h

^

[

k

]

:

=

∑

l

=

−

∞

∞

g

^

[

k

−

l

]

h

^

[

l

]

\hat g \ast \hat h[k] := \sum_{l=-\infin}^{\infin} \hat g[k-l] \hat h[l]

g ^ ∗ h ^ [ k ] : = ∑ l = − ∞ ∞ g ^ [ k − l ] h ^ [ l ]

目的是基于训练样本

x

j

x_j

x j

x

j

x_j

x j

D

D

D

x

j

1

,

⋯

,

x

j

D

x_j^1,\cdots,x_j^D

x j 1 , ⋯ , x j D

N

d

N_d

N d

x

j

d

x_j^d

x j d

x

j

d

∈

R

N

d

x_j^d \in \mathbb{R}^{N_d}

x j d ∈ R N d

n

∈

{

0

,

⋯

,

N

d

}

n\in \{0,\cdots,N^d\}

n ∈ { 0 , ⋯ , N d }

x

j

d

[

n

]

x_j^d[n]

x j d [ n ]

χ

=

R

N

1

×

⋯

×

R

N

D

\chi = \mathbb{R}^{N_1}\times \cdots \times \mathbb{R}^{N_D}

χ = R N 1 × ⋯ × R N D

为了处理连续空间域内的学习问题,我们引入了训练样本的内插模型。我们将区间

[

0

,

T

)

∈

R

[0,T)\in \mathbb{R}

[ 0 , T ) ∈ R

T

T

T

T

T

T

d

d

d

J

d

:

R

N

d

→

L

2

(

T

)

J_d:\mathbb{R}^{N_d} \rightarrow L^2(T)

J d : R N d → L 2 ( T )

J

d

{

x

d

}

(

t

)

=

∑

n

=

0

N

d

−

1

x

d

[

n

]

b

d

(

t

−

T

N

d

n

)

(

2

)

J_d\{x^d\}(t) = \sum_{n=0}^{N_{d}-1}x^d[n]b_d(t-\frac{T}{N_d}n)\quad\quad\quad (2)

J d { x d } ( t ) = n = 0 ∑ N d − 1 x d [ n ] b d ( t − N d T n ) ( 2 )

插值样本

J

d

{

x

d

}

(

t

)

J_d\{x^d\}(t)

J d { x d } ( t )

b

d

∈

L

2

(

T

)

b_d\in L^2(T)

b d ∈ L 2 ( T )

x

d

[

n

]

x^d[n]

x d [ n ]

正如之前讨论的,我们的目标是学习一个线性卷积算子

S

f

:

χ

→

L

2

(

T

)

S_f: \chi \rightarrow L^2(T)

S f : χ → L 2 ( T )

x

∈

χ

x\in \chi

x ∈ χ

[

0

,

T

)

[0,T)

[ 0 , T )

s

(

t

)

=

S

f

{

x

}

(

t

)

s(t)=S_f\{x\}(t)

s ( t ) = S f { x } ( t )

s

(

t

)

∈

R

s(t)\in \mathbb{R}

s ( t ) ∈ R

t

∈

[

0

,

T

)

t\in [0,T)

t ∈ [ 0 , T )

在我们的连续域方程中,算子

S

f

S_f

S f

f

=

(

f

1

,

⋯

,

f

D

)

∈

L

2

(

T

)

D

f=(f^1,\cdots,f^D)\in L^2(T)^D

f = ( f 1 , ⋯ , f D ) ∈ L 2 ( T ) D

f

d

∈

L

2

(

T

)

f^d\in L^2(T)

f d ∈ L 2 ( T )

d

d

d 卷积算子 为:

S

f

{

x

}

=

∑

d

=

1

D

f

d

∗

J

d

{

x

d

}

,

x

∈

χ

(

3

)

S_f\{x\} = \sum_{d=1}^D f^d \ast J_d\{x^d\}, \quad \quad x\in \chi \quad\quad\quad (3)

S f { x } = d = 1 ∑ D f d ∗ J d { x d } , x ∈ χ ( 3 )

这里,每个特征通道首先用(2)插值 ,然后和对应的滤波器进行卷积 。记住卷积是在由(1)定义的连续域中应用的。最后一步,所有滤波器的卷积响应加起来产生了最后的置信函数 。

在标准的 DCF 中,每一个训练样本由一个代表期望卷积输出的离散函数标定。与之不同,我们的样本

x

j

∈

χ

x_j \in \chi

x j ∈ χ

y

j

∈

L

2

(

T

)

y_j\in L^2(T)

y j ∈ L 2 ( T )

y

j

y_j

y j

S

f

{

x

j

}

S_f\{x_j\}

S f { x j }

x

j

x_j

x j

f

f

f

m

m

m

{

x

i

,

x

j

}

1

m

⊂

χ

×

L

2

(

T

)

\{x_i, x_j\}^m_1 \subset \chi \times L^2(T)

{ x i , x j } 1 m ⊂ χ × L 2 ( T )

E

(

f

)

=

∑

j

=

1

m

α

j

∣

∣

S

f

{

x

j

}

−

y

j

∣

∣

2

+

∑

d

=

1

D

∣

∣

ω

f

d

∣

∣

2

(

4

)

E(f)=\sum_{j=1}^m \alpha_j ||S_f\{x_j\} - y_j||^2 + \sum_{d=1}^D ||\omega f^d||^2\quad\quad\quad (4)

E ( f ) = j = 1 ∑ m α j ∣ ∣ S f { x j } − y j ∣ ∣ 2 + d = 1 ∑ D ∣ ∣ ω f d ∣ ∣ 2 ( 4 )

这里,权重

α

j

≥

0

\alpha_j \geq 0

α j ≥ 0

ω

\omega

ω

ω

\omega

ω

ω

\omega

ω

ω

\omega

ω

[

0

,

T

)

[0,T)

[ 0 , T )

ω

∈

L

2

(

T

)

\omega \in L^2(T)

ω ∈ L 2 ( T )

∣

∣

ω

f

d

∣

∣

<

∞

||\omega f^d||<\infin

∣ ∣ ω f d ∣ ∣ < ∞

ω

\omega

ω

ω

^

[

k

]

\hat \omega[k]

ω ^ [ k ]

f

f

f

为了训练滤波器

f

f

f

J

d

{

x

d

}

^

[

k

]

=

X

d

[

k

]

b

^

d

[

k

]

\widehat {J_d\{x^d\}}[k] = X^d [k] \hat b_d [k]

J d { x d }

[ k ] = X d [ k ] b ^ d [ k ]

X

d

[

k

]

:

=

∑

n

=

0

N

d

−

1

x

d

[

n

]

e

−

i

2

π

N

d

n

k

,

k

∈

Z

X^d [k] := \sum_{n=0}^{N_d-1}x^d [n]e^{-i \frac{2\pi}{N_d}nk}, k\in \mathbb{Z}

X d [ k ] : = ∑ n = 0 N d − 1 x d [ n ] e − i N d 2 π n k , k ∈ Z

x

d

x^d

x d

S

f

{

x

}

^

[

k

]

=

∑

d

=

1

D

f

^

d

X

d

[

k

]

b

^

d

[

k

]

,

k

∈

Z

.

(

5

)

\widehat {S_f\{x\}}[k] = \sum_{d=1}^D \hat f^d X^d [k] \hat b_d [k], k\in \mathbb{Z}.\quad\quad\quad (5)

S f { x }

[ k ] = d = 1 ∑ D f ^ d X d [ k ] b ^ d [ k ] , k ∈ Z . ( 5 )

通过应用 Parseval’s formula 到(4)和利用(5),可以得到:

E

(

f

)

=

∑

j

=

1

m

α

j

∣

∣

∑

d

=

1

D

f

^

d

X

j

d

b

^

d

−

y

^

j

∣

∣

l

2

2

+

∑

d

=

1

D

∣

∣

ω

^

∗

f

^

d

∣

∣

l

2

2

(

6

)

E(f)=\sum_{j=1}^m \alpha_j ||\sum_{d=1}^D \hat f^d X_j^d \hat b_d - \hat y_j||^2_{l^2} + \sum_{d=1}^D ||\hat \omega \ast \hat f^d||^2_{l^2}\quad\quad\quad (6)

E ( f ) = j = 1 ∑ m α j ∣ ∣ d = 1 ∑ D f ^ d X j d b ^ d − y ^ j ∣ ∣ l 2 2 + d = 1 ∑ D ∣ ∣ ω ^ ∗ f ^ d ∣ ∣ l 2 2 ( 6 )

因此,泛函

E

(

f

)

E(f)

E ( f )

f

d

f^d

f d

f

^

d

[

k

]

\hat f^d[k]

f ^ d [ k ]

出于实际考虑,滤波器

f

f

f

V

=

s

p

a

n

{

e

k

}

−

K

1

K

1

×

⋯

×

s

p

a

n

{

e

k

}

−

K

D

K

D

V = span\{e_k\}^{K_1}_{-K_1} \times \cdots \times span\{e_k\}^{K_D}_{-K_D}

V = s p a n { e k } − K 1 K 1 × ⋯ × s p a n { e k } − K D K D

{

f

^

d

[

k

]

}

−

K

D

K

D

\{\hat f^d[k]\}^{K_D}_{-K_D}

{ f ^ d [ k ] } − K D K D

∣

k

∣

>

K

d

|k|>K_d

∣ k ∣ > K d

f

^

2

[

k

]

=

0

\hat f^2[k]=0

f ^ 2 [ k ] = 0

K

d

K_d

K d

d

d

d

f

^

d

[

k

]

\hat f^d[k]

f ^ d [ k ]

K

d

K_d

K d

K

d

=

⌊

N

d

2

⌋

K_d=\lfloor \frac{N_d}{2}\rfloor

K d = ⌊ 2 N d ⌋

d

d

d

x

d

x^d

x d

N

d

N_d

N d

为了推导满足

f

∈

V

f\in V

f ∈ V

f

^

d

=

(

f

^

d

[

−

K

d

]

⋯

f

^

d

[

K

d

]

)

T

∈

C

2

K

d

+

1

\bm{\hat f^d} = (\hat f^d[-K_d] \cdots \hat f^d[K_d])^T \in \mathbb{C}^{2K_d+1}

f ^ d = ( f ^ d [ − K d ] ⋯ f ^ d [ K d ] ) T ∈ C 2 K d + 1

f

^

=

[

(

f

^

1

)

T

,

⋯

,

(

f

^

D

)

T

]

T

\bm{\hat f}=[(\bm{\hat f}^1)^T, \cdots, (\bm{\hat f}^D)^T]^T

f ^ = [ ( f ^ 1 ) T , ⋯ , ( f ^ D ) T ] T

y

^

j

=

(

y

^

j

[

−

K

]

⋯

y

^

j

[

K

]

)

T

\bm{\hat y_j}=(\hat y_j[-K] \cdots \hat y_j[K])^T

y ^ j = ( y ^ j [ − K ] ⋯ y ^ j [ K ] ) T

y

j

y_j

y j

K

:

=

max

d

K

d

K:=\max \limits_{d} K_d

K : = d max K d

L

L

L

ω

^

[

k

]

\hat \omega[k]

ω ^ [ k ]

∣

k

∣

>

L

|k|>L

∣ k ∣ > L

ω

^

[

k

]

=

0

\hat \omega [k]=0

ω ^ [ k ] = 0

W

d

W_d

W d

(

2

K

d

+

2

L

+

1

)

×

(

2

K

d

+

1

)

(2K_d+2L+1)\times (2K_d+1)

( 2 K d + 2 L + 1 ) × ( 2 K d + 1 )

W

d

f

^

d

=

v

e

c

ω

^

∗

f

^

d

W_d \bm{\hat f}^d = vec \hat \omega \ast \hat f^d

W d f ^ d = v e c ω ^ ∗ f ^ d

W

W

W

W

=

W

1

⊕

⋯

⊕

W

D

W=W_1\oplus \cdots \oplus W_D

W = W 1 ⊕ ⋯ ⊕ W D

f

∈

V

f\in V

f ∈ V

E

V

(

f

^

)

=

∑

j

=

1

m

α

j

∣

∣

A

j

f

^

−

y

^

j

∣

∣

2

2

+

∣

∣

W

f

^

∣

∣

2

2

(

7

)

E_V(\bm{\hat f}) = \sum_{j=1}^m \alpha_j ||A_j \bm{\hat f} - \hat y_j||^2_2 + ||W \bm{\hat f}||^2_2 \quad \quad \quad (7)

E V ( f ^ ) = j = 1 ∑ m α j ∣ ∣ A j f ^ − y ^ j ∣ ∣ 2 2 + ∣ ∣ W f ^ ∣ ∣ 2 2 ( 7 )

这里,矩阵

A

j

=

[

A

j

1

,

⋯

,

A

j

D

]

A_j = [A^1_j, \cdots, A_j^D]

A j = [ A j 1 , ⋯ , A j D ]

2

K

+

1

2K+1

2 K + 1

2

K

d

+

1

2K_d+1

2 K d + 1

d

d

d

A

j

d

A^d_j

A j d

{

X

j

d

[

k

]

b

^

d

[

k

]

}

−

K

d

K

d

\{X_j^d [k] \hat b_d [k]\}^{K_d}_{-K_d}

{ X j d [ k ] b ^ d [ k ] } − K d K d

∣

∣

⋅

∣

∣

2

||\cdot||_2

∣ ∣ ⋅ ∣ ∣ 2

C

M

\mathbb{C}^M

C M

为了获得正规方程的简化表达形式,我们定义样本矩阵

A

=

[

A

1

T

,

⋯

,

A

m

T

]

A=[A_1^T,\cdots,A_m^T]

A = [ A 1 T , ⋯ , A m T ]

Γ

=

α

1

I

⊕

⋯

⊕

α

m

I

\Gamma = \alpha_1 I \oplus \cdots \oplus \alpha_m I

Γ = α 1 I ⊕ ⋯ ⊕ α m I

y

^

=

[

y

^

1

T

,

⋯

,

y

^

m

T

]

\bm{\hat y} = [\bm{\hat y_1}^T, \cdots,\bm{\hat y_m}^T]

y ^ = [ y ^ 1 T , ⋯ , y ^ m T ]

(

A

H

Γ

A

+

W

H

W

)

f

^

=

A

H

Γ

y

^

(

8

)

(A^H\Gamma A+W^H W)\bm{\hat f} = A^H\Gamma \bm{\hat y}\quad \quad \quad (8)

( A H Γ A + W H W ) f ^ = A H Γ y ^ ( 8 )

这里,

H

^H

H

ω

\omega

ω

ω

^

[

k

]

\hat \omega[k]

ω ^ [ k ]

ω

\omega

ω

这里,我们描述了期望卷积输出

y

j

y_j

y j

b

d

b_d

b d

y

j

y_j

y j

b

d

b_d

b d

g

g

g

T

T

T

g

T

(

t

)

=

∑

−

∞

∞

g

(

t

−

n

T

)

g_T(t)=\sum_{-\infin}^{\infin} g(t-nT)

g T ( t ) = ∑ − ∞ ∞ g ( t − n T )

y

j

y_j

y j

b

d

b_d

b d

g

T

g_T

g T

g

(

t

)

g(t)

g ( t )

g

^

(

ξ

)

\hat g(\xi)

g ^ ( ξ )

g

^

T

[

k

]

=

1

T

g

^

(

k

T

)

\hat g_T[k] = \frac{1}{T} \hat g(\frac{k}{T})

g ^ T [ k ] = T 1 g ^ ( T k )

y

j

y_j

y j

b

d

b_d

b d

为了构造期望的卷积输出

y

j

y_j

y j

u

j

∈

[

0

,

T

)

u_j\in [0,T)

u j ∈ [ 0 , T )

y

j

y_j

y j

u

j

u_j

u j

e

x

p

(

−

(

t

−

u

j

)

2

2

σ

2

)

exp(-\frac{(t-u_j)^2}{2\sigma^2})

e x p ( − 2 σ 2 ( t − u j ) 2 )

y

^

j

[

k

]

=

2

π

σ

2

T

e

x

p

(

−

2

σ

2

(

π

k

T

)

2

−

i

2

π

T

u

j

k

)

.

\hat y_j[k] = \frac{\sqrt{2\pi \sigma^2}}{T} exp(-2\sigma^2 (\frac{\pi k}{T})^2 - i \frac{2\pi}{T}u_j k).

y ^ j [ k ] = T 2 π σ 2

e x p ( − 2 σ 2 ( T π k ) 2 − i T 2 π u j k ) .

变量

σ

2

\sigma^2

σ 2

b

d

b_d

b d

b

(

t

)

b(t)

b ( t )

b

d

b_d

b d

b

(

N

d

T

(

t

−

T

2

N

d

)

)

b(\frac{N_d}{T}(t-\frac{T}{2N_d}))

b ( T N d ( t − 2 N d T ) )

b

d

b_d

b d

b

^

d

[

k

]

=

1

N

d

e

x

p

(

−

i

π

N

d

k

)

b

^

(

k

N

d

)

\hat b_d[k] = \frac{1}{N_d} exp(-i \frac{\pi}{N_d}k)\hat b (\frac{k}{N_d})

b ^ d [ k ] = N d 1 e x p ( − i N d π k ) b ^ ( N d k )

前面提出的方程可以推广到任意维度,对于我们的跟踪应用,主要考虑二维的情况,但是更高维的可以进行类似处理。对于图像我们使用含两个变量的平方可积的周期函数

g

(

t

1

,

t

2

)

g(t_1,t_2)

g ( t 1 , t 2 )

L

2

(

T

1

,

T

2

)

L^2(T_1,T_2)

L 2 ( T 1 , T 2 )

e

k

1

,

k

2

(

t

1

,

t

2

)

=

e

i

2

π

T

1

k

1

t

1

e

i

2

π

T

2

k

2

t

2

e_{k_1,k_2}(t_1,t_2) = e^{i\frac{2\pi}{T_1}k_1 t_1} e^{i\frac{2\pi}{T_2}k_2 t_2}

e k 1 , k 2 ( t 1 , t 2 ) = e i T 1 2 π k 1 t 1 e i T 2 2 π k 2 t 2

y

j

y_j

y j

b

(

t

1

,

t

2

)

=

b

(

t

1

)

b

(

t

2

)

b(t_1,t_2) = b(t_1)b(t_2)

b ( t 1 , t 2 ) = b ( t 1 ) b ( t 2 )

我们将连续学习公式应用于两个问题:视觉目标跟踪和特征点跟踪。我们首先提出了基于最大化连续置信度函数的定位过程。这是目标和特征点追踪的通用框架。

目的是利用学习得到的滤波器

f

f

f

x

∈

χ

x\in \chi

x ∈ χ

s

=

S

f

{

x

}

s=S_f\{x\}

s = S f { x }

t

∈

[

0

,

T

)

t\in [0,T)

t ∈ [ 0 , T )

s

(

t

)

s(t)

s ( t )

s

(

T

n

2

K

+

1

)

s(\frac{T_n}{2K+1})

s ( 2 K + 1 T n )

n

=

0

,

⋯

,

2

K

n=0,\cdots,2K

n = 0 , ⋯ , 2 K

s

^

[

k

]

,

k

=

−

K

,

⋯

,

K

\hat s[k], k=-K,\cdots,K

s ^ [ k ] , k = − K , ⋯ , K

s

(

t

)

=

∑

−

K

K

s

^

[

k

]

e

k

(

t

)

s(t)=\sum_{-K}^K \hat s[k]e_k(t)

s ( t ) = ∑ − K K s ^ [ k ] e k ( t )

s

(

t

)

s(t)

s ( t )

我们提出基于3.2节介绍的连续学习公式的目标跟踪框架。我们采用从预先训练的深度网络中提取的多分辨率特征图

x

j

x_j

x j

x

j

x_j

x j

5

2

5^2

5 2

α

j

=

α

j

−

1

1

−

λ

\alpha_j = \frac{\alpha_{j-1}}{1-\lambda}

α j = 1 − λ α j − 1

λ

=

0.0075

\lambda = 0.0075

λ = 0 . 0 0 7 5

∑

j

α

j

=

1

\sum_j \alpha_j = 1

∑ j α j = 1

m

=

400

m=400

m = 4 0 0

ω

^

\hat \omega

ω ^

我们的连续卷积滤波器

f

f

f

O

(

D

)

\mathbb{O}(D)

O ( D )

f

^

\hat f

f ^

这里,我们描述基于我们的学习方法的特征点跟踪。为了计算效率,我们假设一个通道的特征图

(

D

=

1

)

(D=1)

( D = 1 )

ω

(

t

)

=

β

\omega(t) = \beta

ω ( t ) = β

f

^

[

k

]

=

∑

j

=

1

M

α

j

X

j

[

k

]

b

^

[

k

]

‾

y

^

j

[

k

]

∑

j

=

1

M

α

j

∣

X

j

[

k

]

b

^

[

k

]

∣

2

+

β

2

,

k

=

−

K

,

⋯

,

K

.

\hat f[k] = \frac{\sum_{j=1}^M \alpha_j \overline {X_j [k] \hat b [k]} \hat y_j [k]}{\sum_{j=1}^M \alpha_j |X_j [k] \hat b [k]|^2 + \beta^2}, k=-K, \cdots, K.

f ^ [ k ] = ∑ j = 1 M α j ∣ X j [ k ] b ^ [ k ] ∣ 2 + β 2 ∑ j = 1 M α j X j [ k ] b ^ [ k ] y ^ j [ k ] , k = − K , ⋯ , K .

在这里,为了清楚起见,我们已经放弃了特征维度索引。在这种情况下(单特征通道和恒定惩罚函数),训练方程(10)就类似于原始的MOSSE滤波器。然而,和原始的MOSSE相比,我们的连续方程有几个特点。首先,我们的公式采用由

b

^

\hat b

b ^

y

j

y_j

y j