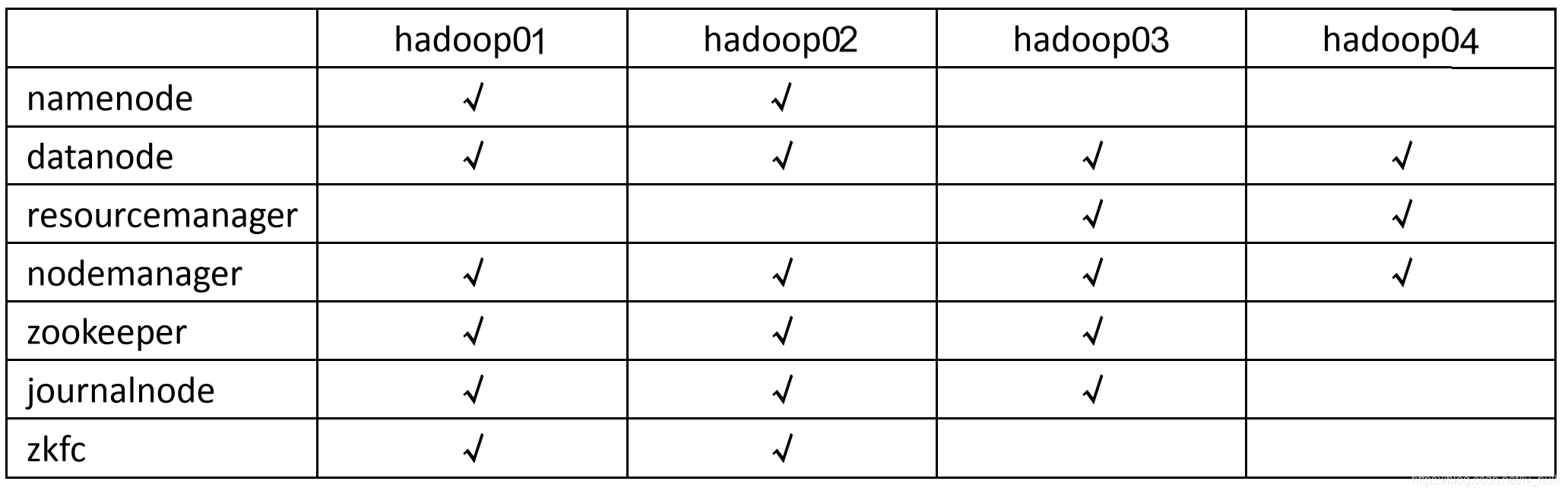

(一)集群规划

描述:hadoop HA 集群的搭建依赖于 zookeeper,所以选取三台当做 zookeeper 集群

总共准备了四台主机,分别是 hadoop01,hadoop02,hadoop03,hadoop04

其中 hadoop01 和 hadoop02 做 namenode 的主备切换,hadoop03 和 hadoop04 做

resourcemanager 的主备切换

(二)集群服务器准备

(二)集群服务器准备

安装准备

1)主机名

2)ip

3)hosts

4)防火墙

5)selinux

6)普通用户的sudoers权限

7)修改系统的启动级别 3

8)安装jdk

9)ssh免密码登录

10)时间同步 ha必须做时间同步

sudo ntpdate ntp1.aliyun.com

(三)集群安装

1)上传

2)解压

tar -xvzf hadoop-2.7.6.tar.gz

3)配置环境变量

export HADOOP_HOME=/home/hadoop/apps/hadoop-2.7.6

export ZOOKEEPER_HOME=/home/hadoop/apps/zookeeper-3.4.10

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$ZOOKEEPER_HOME/bin

source /etc/profile

验证:hadoop version

4)修改hadoop的配置文件

$HADOOP_HOME/etc/hadoop

hadoop-env.sh

修改:

export JAVA_HOME=/home/hadoop/apps/jdk1.8.0_73

core-site.xml

<!-- 指定 hdfs 的 访问入口 namenode的入口 这里的HadoopHA 就相当于两个namenode的组名-->

<property>

<name>fs.defaultFS</name>

<value>hdfs://HadoopHA /</value>

</property>

<!-- 指定 hadoop 数据存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/data/hadoopdata/</value>

</property>

<!-- 指定 zookeeper 集群访问地址 -->

<property>

<name>ha.zookeeper.quorum</name>

<value>hadoop01:2181,hadoop02:2181,hadoop03:2181</value>

</property>

hdfs-site.xml

<!-- 指定副本数 -->

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<!--指定 hdfs 两个namenode的 nameservice 为 HadoopHA ,需要和 core-site.xml 中保持一致-->

<property>

<name>dfs.nameservices</name>

<value>HadoopHA </value>

</property>

<!-- HadoopHA 下面有两个 NameNode,分别是 nn1,nn2 -->

<property>

<name>dfs.ha.namenodes.HadoopHA </name>

<value>nn1,nn2</value>

</property>

<!-- nn1 的 RPC 通信地址 -->

<property>

<name>dfs.namenode.rpc-address.HadoopHA .nn1</name>

<value>hadoop01:9000</value>

</property>

<!-- nn1 的 http 通信地址 web -->

<property>

<name>dfs.namenode.http-address.HadoopHA .nn1</name>

<value>hadoop01:50070</value>

</property>

<!-- nn2 的 RPC 通信地址 -->

<property>

<name>dfs.namenode.rpc-address.HadoopHA .nn2</name>

<value>hadoop02:9000</value>

</property>

<!-- nn2 的 http 通信地址 -->

<property>

<name>dfs.namenode.http-address.HadoopHA .nn2</name>

<value>hadoop02:50070</value>

</property>

<!-- 指定 NameNode 的 edits 元数据在 JournalNode 上的存放位置 端口8485-->

<property>

<name>dfs.namenode.shared.edits.dir</name>

<value>qjournal://hadoop01:8485;hadoop02:8485;hadoop03:8485/HadoopHA </value>

</property>

<!-- 指定 JournalNode 在本地磁盘存放数据的位置 -->

<property>

<name>dfs.journalnode.edits.dir</name>

<value>/home/hadoop/data/hadoopdata/journaldata</value>

</property>

<!-- 开启 NameNode 失败自动切换 -->

<property>

<name>dfs.ha.automatic-failover.enabled</name>

<value>true</value>

</property>

<!-- 配置失败自动切换实现方式 -->

<!-- 此处配置在安装的时候切记检查不要换行-->

<property>

<name>dfs.client.failover.proxy.provider.HadoopHA </name>

<value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value>

</property>

<!-- 配置隔离机制方法,多个机制用换行分割,即每个机制暂用一行-->

<property>

<name>dfs.ha.fencing.methods</name>

<value>

sshfence

shell(/bin/true)

</value>

</property>

<!-- 使用 sshfence 隔离机制时需要 ssh 免登陆 -->

<property>

<name>dfs.ha.fencing.ssh.private-key-files</name>

<value>/home/hadoop/.ssh/id_rsa</value>

</property>

<!-- 配置 sshfence 隔离机制超时时间 -->

<property>

<name>dfs.ha.fencing.ssh.connect-timeout</name>

<value>30000</value>

</property>

yarn-site.xml

<!-- 开启 RM 高可用 -->

<property>

<name>yarn.resourcemanager.ha.enabled</name>

<value>true</value>

</property>

<!-- 指定 RM 的 cluster id -->

<property>

<name>yarn.resourcemanager.cluster-id</name>

<value>yrc</value>

</property>

<!-- 指定 RM 的名字 -->

<property>

<name>yarn.resourcemanager.ha.rm-ids</name>

<value>rm1,rm2</value>

</property>

<!-- 分别指定 RM 的地址 -->

<property>

<name>yarn.resourcemanager.hostname.rm1</name>

<value>hadoop01</value>

</property>

<property>

<name>yarn.resourcemanager.hostname.rm2</name>

<value>hadoop02</value>

</property>

<!-- 指定 zk 集群地址 -->

<property>

<name>yarn.resourcemanager.zk-address</name>

<value>hadoop01:2181,hadoop02:2181,hadoop03:2181</value>

</property>

<!-- 要运行 MapReduce 程序必须配置的附属服务 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 开启 YARN 集群的日志聚合功能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- YARN 集群的聚合日志最长保留时长 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>86400</value>

</property>

<!-- 启用自动恢复 -->

<property>

<name>yarn.resourcemanager.recovery.enabled</name>

<value>true</value>

</property>

<!-- 制定 resourcemanager 的状态信息存储在 zookeeper 集群上-->

<property>

<name>yarn.resourcemanager.store.class</name>

<value>org.apache.hadoop.yarn.server.resourcemanager.recovery.ZKRMStateStore</value>

</property>

mapred-site.xml

cp mapred-site.xml.template mapred-site.xml

<!-- 指定 mr 框架为 yarn 方式 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- 设置 mapreduce rpc的历史服务器地址和端口号 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>hadoop03:10020</value>

</property>

<!-- mapreduce 历史服务器的 web 访问地址 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hadoop03:19888</value>

</property>

slaves 从节点nodemanager datanode

hadoop01

hadoop02

hadoop03

hadoop04

5)将hadoop的安装包远程发送到其他节点

scp -r hadoop-2.7.6 hadoop02:/home/hadoop/apps/

scp -r hadoop-2.7.6 hadoop03:/home/hadoop/apps/

scp -r hadoop-2.7.6 hadoop04:/home/hadoop/apps/

source /etc/profile

hadoop version

6)从这一步开始 严格按照顺序执行

1)先启动journalnode

hadoop01 hadoop-daemon.sh start journalnode

hadoop02 hadoop-daemon.sh start journalnode

hadoop03 hadoop-daemon.sh start journalnode

2)格式化namenode 在一个namenode上执行格式化命令

在hadoop01执行

hadoop namenode -format

3)将hadoop01上的namenode的相关数据文件远程并发送到另一个namenode

节点hadoop02

scp -r dfs hadoop02:/home/hadoop/data/hadoopdata/

4)先启动zk

hadoop01

hadoop02

hadoop03

zkServer.sh start

5)格式化zkfc 选择一个namenode的节点

hdfs zkfc -formatZK

成功标志:

Successfully created /hadoop-ha/bd1807 in ZK

6)启动集群

启动hdfs

start-dfs.sh 任意节点执行

DFSZKFailoverController---zkfc

启动yarn

start-yarn.sh 最好在resourcemanager的节点

在哪一个节点执行上面的命令 在哪一个节点启动resourcemanager

另一个节点手动启动

yarn-daemon.sh start resourcemanager

注意:

单独启动zkfc的命令:

hadoop-daemon.sh start zkfc

(四)HA集群验证

先验证hdfs的主备切换:

namenode 2个

http://hadoop01:50070

http://hadoop02:50070

yarn的测试

http://hadoop01:8088

http://hadoop02:8088

mr 切换yarn的主节点

(五)HA集群关机顺序

关机:

先关闭集群:

1)关闭hdfs

stop-dfs.sh

2)关闭yarn

stop-yarn.sh

3)关闭zk

zkServer.sh stop

再关机