Hadoop HA集群搭建

一:在安装搭建之前简单了解一下 hadoop ha

为什么会有hadoop HA机制呢?

HA:High Available,高可用 在Hadoop 2.0之前,在HDFS 集群中NameNode 存在单点故障

对于只有一个 NameNode 的集群,如果 NameNode 机器出现故障(比如宕机或是软件、硬件 升级),那么整个集群将无法使用,直到 NameNode 重新启动

如何解决呢?

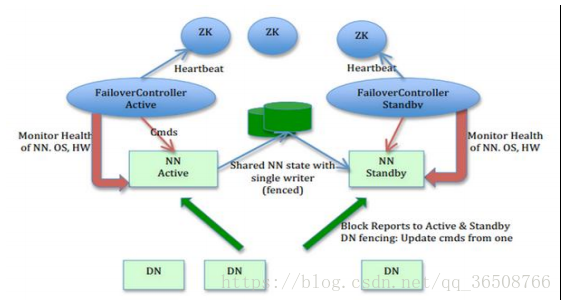

HDFS的HA功能通过配置Active/Standby两个NameNodes实现在集群中对 NameNode 的 热备来解决上述问题。如果出现故障,如机器崩溃或机器需要升级维护,这时可通过此种方 式将 NameNode 很快的切换到另外一台机器。

在一个典型的 HDFS(HA) 集群中,使用两台单独的机器配置为 NameNodes 。在任何时间点, 确保 NameNodes 中只有一个处于 Active 状态,其他的处在 Standby 状态。其中 ActiveNameNode 负责集群中的所有客户端操作,StandbyNameNode 仅仅充当备机,保证一 旦 ActiveNameNode 出现问题能够快速切换。

为了能够实时同步 Active 和 Standby 两个 NameNode 的元数据信息(实际上 editlog),需提 供一个共享存储系统,可以是 NFS、QJM(Quorum Journal Manager)或者 Zookeeper,Active Namenode 将数据写入共享存储系统,而 Standby 监听该系统,一旦发现有新数据写入,则 读取这些数据,并加载到自己内存中,以保证自己内存状态与 Active NameNode 保持基本一 致,如此这般,在紧急情况下 standby 便可快速切为 active namenode。为了实现快速切换, Standby 节点获取集群的最新文件块信息也是很有必要的。为了实现这一目标,DataNode 需 要配置 NameNodes 的位置,并同时给他们发送文件块信息以及心跳检测。

二:Hadoop HA集群安装搭建

1.首先第一步毋庸置疑的是需要做hadoop集群规划

描述:hadoop HA 集群的搭建依赖于 zookeeper,所以选取三台当做 zookeeper 集群 我总共准备了三台主机,分别是 hadoop01,hadoop02,hadoop03 ,其中 hadoop01 和 hadoop02 做 namenode 的主备切换,hadoop02 和 hadoop03 做 resourcemanager 的主备切换(这个依据自己集群节点的数量来规划,可自由设置)

| hadoop01 | hadoop02 | hadoop03 | |

| namenode | ✔ | ✔ | |

| datanode | ✔ | ✔ | ✔ |

| resourcemanager | ✔ | ✔ | |

| nodemanager | ✔ | ✔ | ✔ |

| zookeeper | ✔ | ✔ | ✔ |

| journalnode | ✔ | ✔ | ✔ |

| zkfc | ✔ | ✔ |

2.集群服务器准备(这个环节比较简单,在这里就不详细概述了)

1、 修改主机名 vi /etc/sysconfig/network (ps:我三台服务器都修改了,分别为hadoop01,hadoop02,hadoop03)

2、 修改 IP 地址

3、 添加主机名和 IP 映射

4、 添加普通用户 hadoop 用户并配置 sudoer 权限

5、 设置系统启动级别

6、 同步服务器时间

7、 关闭防火墙/关闭 Selinux

8、 配置 SSH 免密登录

9、 安装 JDK

3.安装zookeeper集群

在此略过,可参考我的另外一篇博客:Zookeeper的集群搭建与配置(二)https://blog.csdn.net/qq_36508766/article/details/81336588

4.安装并配置hadoop ha集群

(ps:如果之前安装过普通的分布式hadoop集群,需要删除相关数据文件,修改配置,建议全部卸载重新安装)

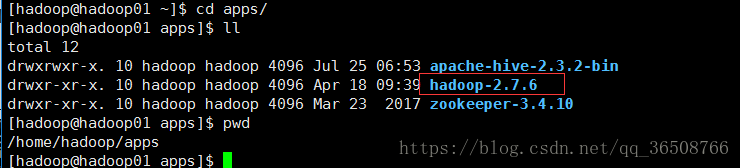

1.上传安装包hadoop-2.7.6.tar.gz

2.解压安装包到对应的安装目录 tar -zxvf hadoop-2.7.6.tar.gz -C apps/

3.修改配置文件 (修改相关配置key的作用都已在注释)

(PS:我的配置文件路径 /home/hadoop/apps/hadoop-2.7.6/etc/hadoop )

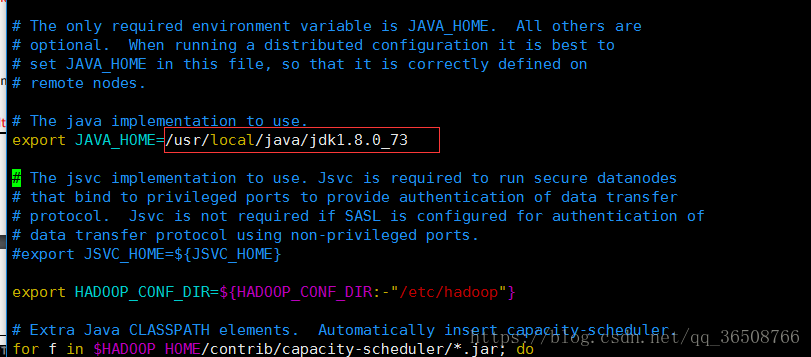

3.1 修改hadoop-env.sh 配置jdk ----vi hadoop-env.sh

3.2 修改core-site.xml

<configuration>

<!-- 指定 hdfs 的 nameservice 为 myha01 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://myha01/</value>

</property>

<!-- 指定 hadoop 工作目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/data/hadoopdata/</value>

</property>

<!-- 指定 zookeeper 集群访问地址 -->

<property>

<name>ha.zookeeper.quorum</name>

<value>hadoop01:2181,hadoop02:2181,hadoop03:2181</value>

</property>

</configuration>

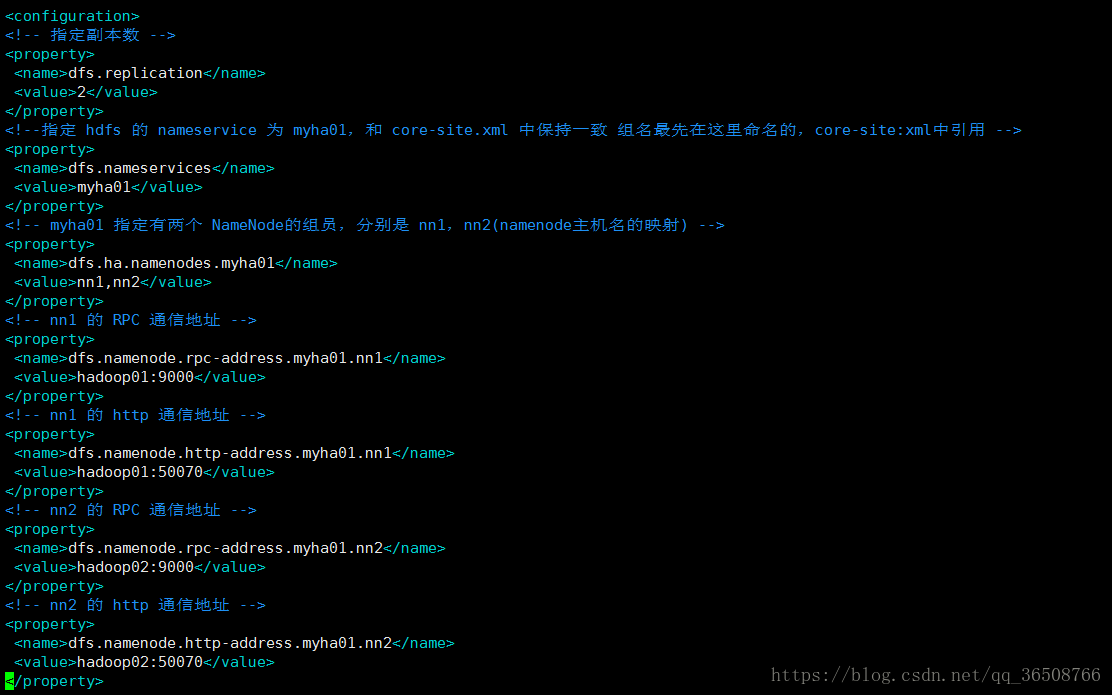

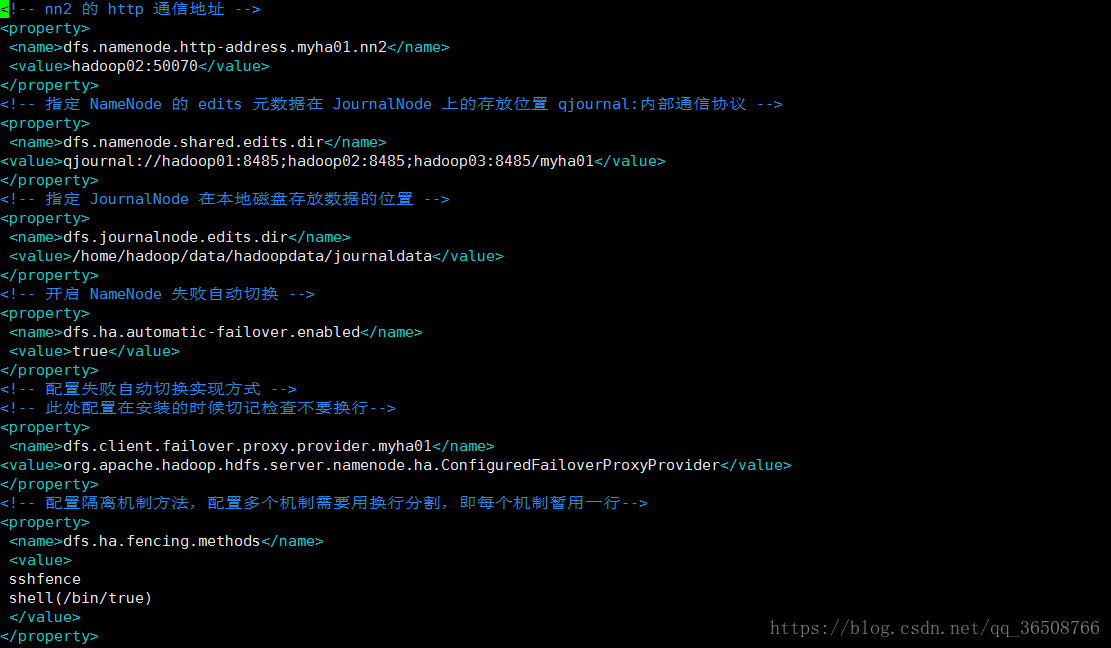

3.3 修改 hdfs-site.xml

<configuration>

<!-- 指定副本数 -->

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<!--指定 hdfs 的 nameservice 为 myha01,需要和 core-site.xml 中保持一致-->

<property>

<name>dfs.nameservices</name>

<value>myha01</value>

</property>

<!-- myha01 下面有两个 NameNode,分别是 nn1,nn2(namenode的映射) -->

<property>

<name>dfs.ha.namenodes.myha01</name>

<value>nn1,nn2</value>

</property>

<!-- nn1 的 RPC 通信地址 -->

<property>

<name>dfs.namenode.rpc-address.myha01.nn1</name>

<value>hadoop01:9000</value>

</property>

<!-- nn1 的 http 通信地址 -->

<property>

<name>dfs.namenode.http-address.myha01.nn1</name>

<value>hadoop01:50070</value>

</property>

<!-- nn2 的 RPC 通信地址 -->

<property>

<name>dfs.namenode.rpc-address.myha01.nn2</name>

<value>hadoop02:9000</value>

</property>

<!-- nn2 的 http 通信地址 -->

<property>

<name>dfs.namenode.http-address.myha01.nn2</name>

<value>hadoop02:50070</value>

</property>

<!-- 指定 NameNode 的 edits 元数据在 JournalNode 上的存放位置 qjournal:协议-->

<property>

<name>dfs.namenode.shared.edits.dir</name>

<value>qjournal://hadoop01:8485;hadoop02:8485;hadoop03:8485/myha01</value>

</property>

<!-- 指定 JournalNode 在本地磁盘存放数据的位置 -->

<property>

<name>dfs.journalnode.edits.dir</name>

<value>/home/hadoop/data/hadoopdata/journaldata</value>

</property>

<!-- 开启 NameNode 失败自动切换 -->

<property>

<name>dfs.ha.automatic-failover.enabled</name>

<value>true</value>

</property>

<!-- 配置失败自动切换实现方式 -->

<!-- 此处配置在安装的时候切记检查不要换行-->

<property>

<name>dfs.client.failover.proxy.provider.myha01</name>

<value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value>

</property>

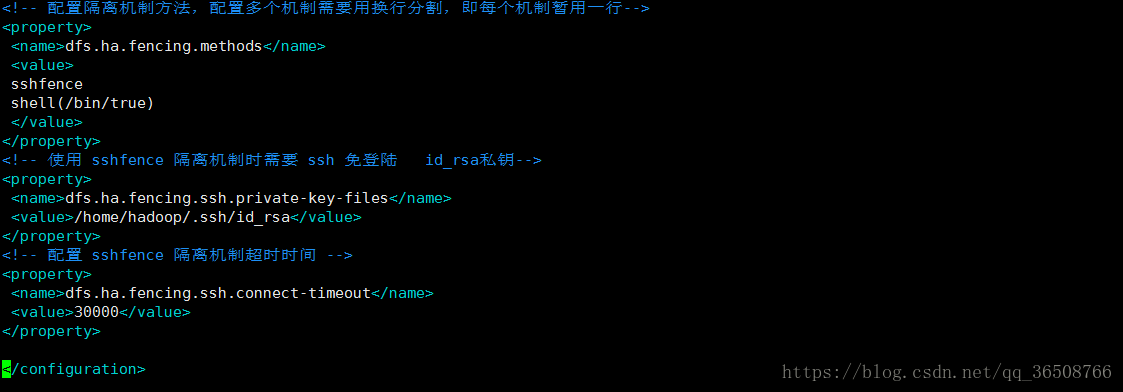

<!-- 配置隔离机制方法,多个机制用换行分割,即每个机制暂用一行-->

<property>

<name>dfs.ha.fencing.methods</name>

<value>

sshfence

shell(/bin/true)

</value>

</property>

<!-- 使用 sshfence 隔离机制时需要 ssh 免登陆 -->

<property>

<name>dfs.ha.fencing.ssh.private-key-files</name>

<value>/home/hadoop/.ssh/id_rsa</value>

</property>

<!-- 配置 sshfence 隔离机制超时时间 毫秒 -->

<property>

<name>dfs.ha.fencing.ssh.connect-timeout</name>

<value>30000</value>

</property>

</configuration>

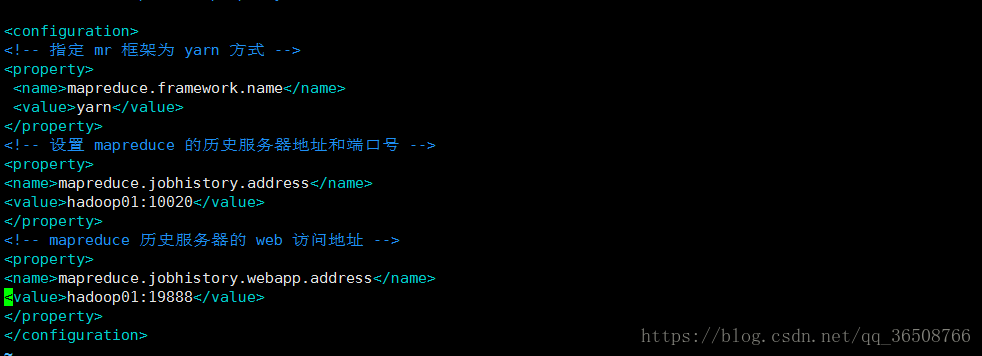

3.4 修改 mapred-site.xml (PS:没有mapred-site.xml文件 可以建一个 例: cp mapred-site.xml.template mapred-site.xml)

<configuration>

<!-- 指定 mr 框架为 yarn 方式 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- 设置 mapreduce 的历史服务器地址和端口号 随便一个节点即可 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>hadoop01:10020</value>

</property>

<!-- mapreduce 历史服务器的 web 访问地址 随便一个节点即可 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hadoop01:19888</value>

</property>

</configuration>

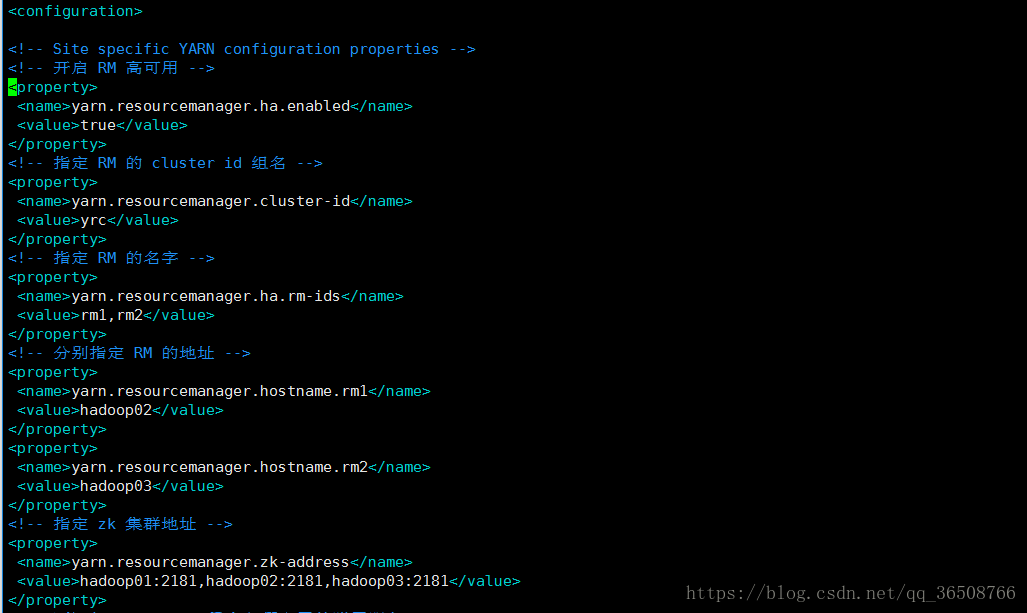

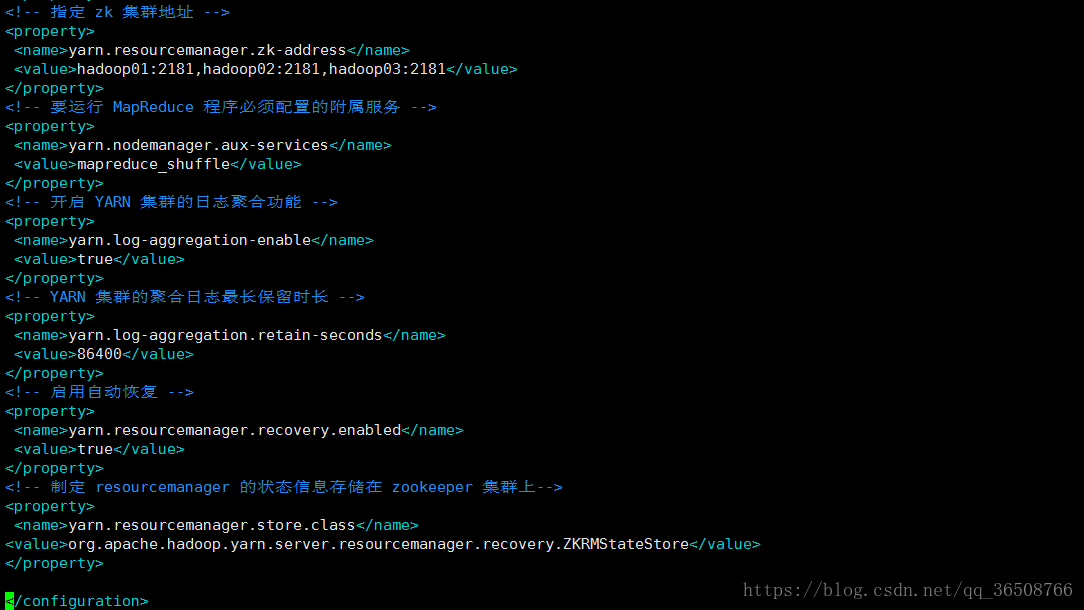

3.5修改yarn-site.xml

<configuration>

<!-- 开启 RM 高可用 -->

<property>

<name>yarn.resourcemanager.ha.enabled</name>

<value>true</value>

</property>

<!-- 指定 RM 的 cluster id -->

<property>

<name>yarn.resourcemanager.cluster-id</name>

<value>yrc</value>

</property>

<!-- 指定 RM 的名字 -->

<property>

<name>yarn.resourcemanager.ha.rm-ids</name>

<value>rm1,rm2</value>

</property>

<!-- 分别指定 RM 的地址 -->

<property>

<name>yarn.resourcemanager.hostname.rm1</name>

<value>hadoop02</value>

</property>

<property>

<name>yarn.resourcemanager.hostname.rm2</name>

<value>hadoop03</value>

</property>

<!-- 指定 zk 集群地址 -->

<property>

<name>yarn.resourcemanager.zk-address</name>

<value>hadoop01:2181,hadoop02:2181,hadoop03:2181</value>

</property>

<!-- 要运行 MapReduce 程序必须配置的附属服务 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 开启 YARN 集群的日志聚合功能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- YARN 集群的聚合日志最长保留时长 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>86400</value>

</property>

<!-- 启用自动恢复 -->

<property>

<name>yarn.resourcemanager.recovery.enabled</name>

<value>true</value>

</property>

<!-- 制定 resourcemanager 的状态信息存储在 zookeeper 集群上-->

<property>

<name>yarn.resourcemanager.store.class</name>

<value>org.apache.hadoop.yarn.server.resourcemanager.recovery.ZKRMStateStore</value>

</property>

</configuration>

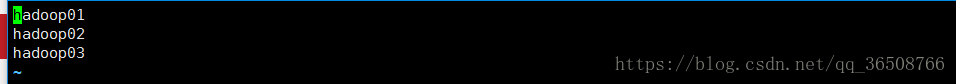

3.6 修改slaves添加集群节点地址 vi slaves (ps:切记不要留多余空格和空行)

4.配置环境变量vi /etc/profile

5.将配置好的hadoop发送至其他节点,我这里是hadoop01发送到hadoop02,hadoop03

scp -r apps/hadoop-2.7.6/ hadoop2:~/apps/

6.同步其他节点的/etc/profile文件(或者分别配置hadoop_home),然后重新加载source /etc/profile

5.集群初始化操作

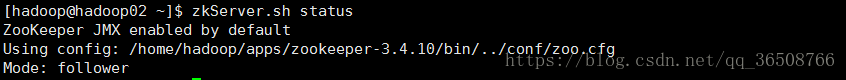

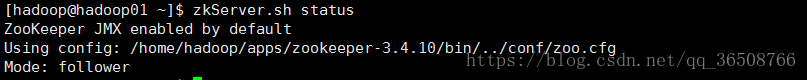

5.1先启动zookeeper集群

启动:zkServer.sh start(要求半数以上的节点启动,我这里三台服务器全部启动了)

检查启动是否正常:zkServer.sh status

1个leader ,2个follower(我这里没有规划observer)

5.2、 分别在每个 zookeeper(也就是规划的三个 journalnode 节点,不一定跟 zookeeper 节点一样)节点上启动 journalnode 进程

hadoop-daemon.sh start journalnode

然后用 jps 命令查看是否各个 datanode 节点上都启动了 journalnode 进程 如果报错,根据错误提示改进

5.3 在第一个 namenode 上执行格式化操作 hadoop namenode -format

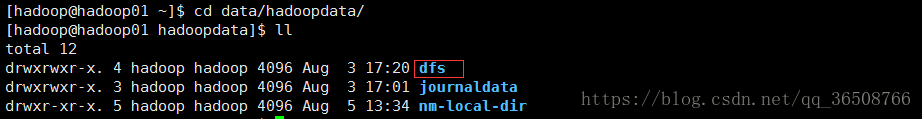

然后会在 core-site.xml 中配置的临时目录中生成一些集群的信息

<!-- 指定 hadoop 工作目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/data/hadoopdata/</value>

</property>

把dfs拷贝的第二个 namenode 的相同目录下 scp -r /home/hadoop/data/hadoopdata/dfs hadoop02:~/data/hadoopdata/

5.4 格式化 ZKFC

hdfs zkfc -formatZK 在第一台机器上即可

5.5启动HDFS start-dfs.sh 启动YARN start-yarn.sh (另外一个主节点的rm不会启动 需要手动启动 yarn-daemon.sh start resourcemanager)

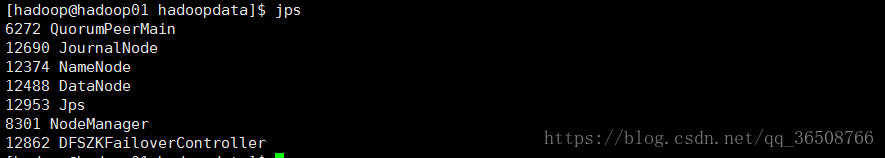

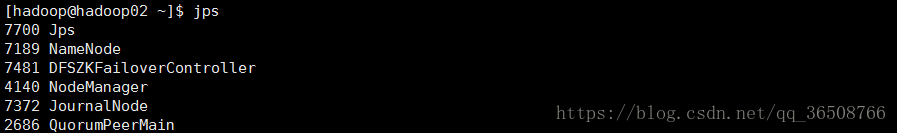

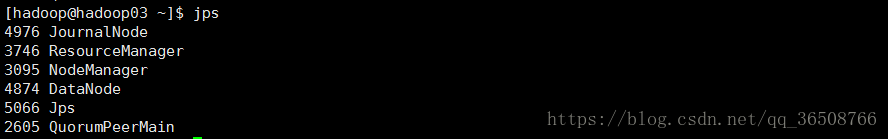

jps 命令查看各节点进程是否启动正常

zkfc:DFSZKFailoverController

zookeeper:QuorumPeerMain

(PS:如果发现有进程没有启动成功,手动启动,例:hadoop-daemon.sh start journalnode / yarn-daemon.sh start resourcemanager)

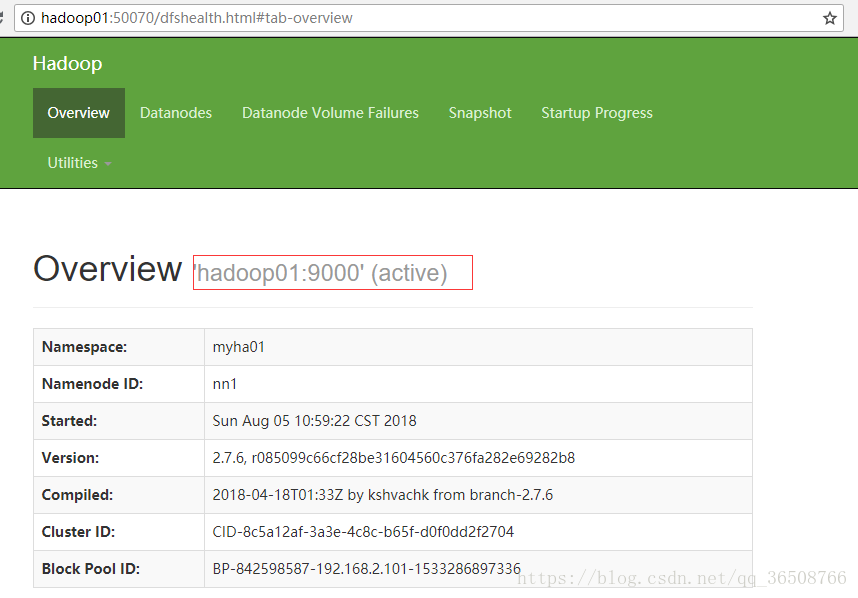

5.6 访问页面 http://hadoop01:50070/

6.验证

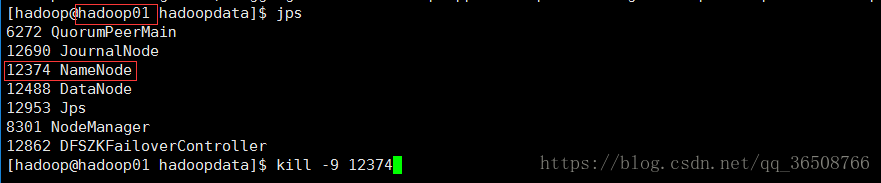

1.验证namenode的高可用:

先把active namenode(hadoop01) 的namenode进程kill掉,再访问http://hadoop02:50070/

验证原来standby namenode会不会自行切换为active namenode,如果standby状态切换为了active状态,即成功。

2. 验证resourcemanager的高可用:

验证:运行一个jar包 过程中 把active的kill掉

理论上可以,可自行验证下