Python学习之爬虫05-爬虫的浏览器伪装技术实战

概念:

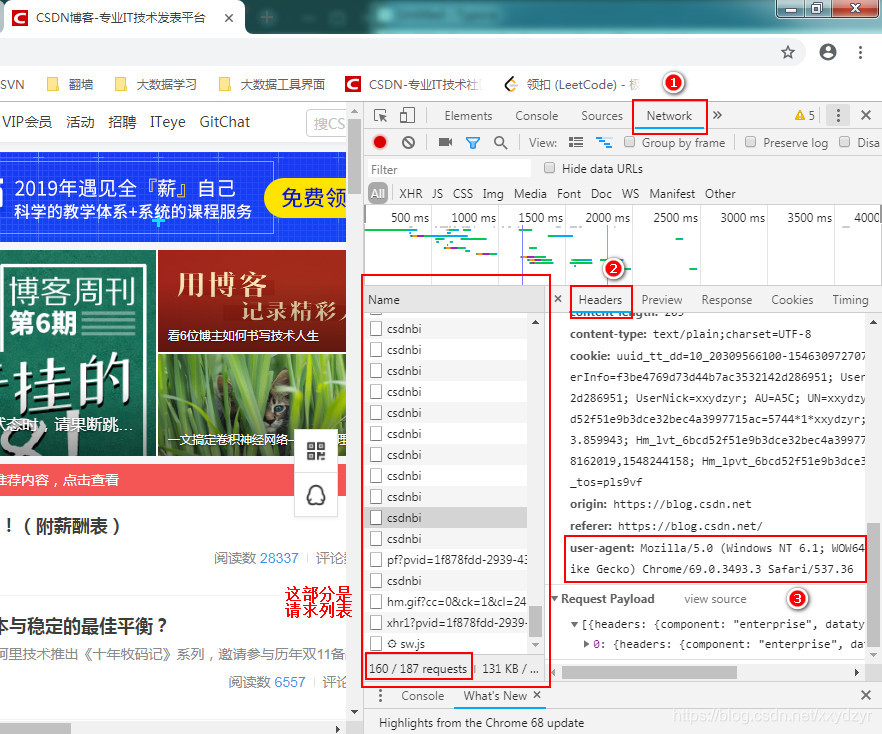

报头:每次请求的时候我们都会有一个请求头(登个百度首页都会有好多次请求),也叫报头。它的内容就是这部分:

我们先在浏览器页面按F12,一般都是这个键,然后会调出右边部分,接着我们刷新CSDN博客的首页,达到发送请求的目的,点击途中的1/2/3,3就是我们所需要的报头,这个user-agent后面的内容就是报头。

原理:

每次请求的报头会记录我们是通过什么去访问的,不同浏览器的报头不一样,爬虫的报头也和浏览器的不一样。所以我们这里在请求的时候修改报头,将报头改为浏览器的即可。

练习时使用的是谷歌浏览器,所以:报头为:

Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3493.3 Safari/537.36

由于urlopen() 方法对于一些HTTP的高级功能不支持,所以,我们如果想修改报头,可以使用urllib.request.opener()进行。

还可以使用urllib.request.Request() 下的add_header()实现。

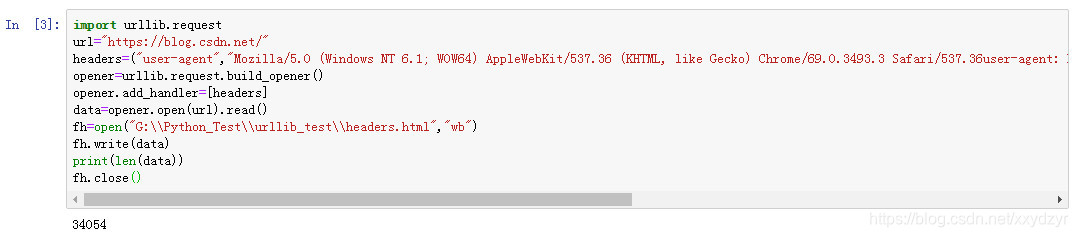

#浏览器伪装

import urllib.request

url="https://blog.csdn.net/"

#头文件格式header=("user-agent",具体用户代理值)

headers=("user-agent","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3493.3 Safari/537.36user-agent: Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3493.3 Safari/537.36")

opener=urllib.request.build_opener()

opener.add_handler=[headers]

data=opener.open(url).read()

fh=open("G:\\Python_Test\\urllib_test\\headers.html","wb") # 上面在读取文件的时候没有使用到utf-8来转码,所以是一个二进制文件,对于二进制文件的写入需要加一个 b,所以这里使用 wb 表示写。

fh.write(data)

print(len(data))

fh.close()