4.4.1学习率的设置

学习率太大了不好,学习率太小了也不好

TensorFlow提供了一种更加灵活的学习率设置方法--指数衰减法

前期较大的学习率来快速得到一个比较优的解

后期随着迭代次数的继续逐步减小学习率,使得模型在训练后期更加稳定.

4.4.2过拟合问题

所谓过拟合,指的是当一个模型过为复杂之后,它可以很好地"记忆"每一个训练数据中

随机噪音的部分而忘了要去"学习"训练数据中通用的趋势

举一个比较极端的例子,如果一个模型中的参数比训练数据的总数还多,

那么,只要训练数据不冲突,这个模型完全可以记住所有训连数据的结果从而使得损失函数为0

可以想象一个包含n个变量和n个等式的方程组......

图4-14显示了模型训练的三种不同情况

为了避免过拟合问题,一个非常常用的方法是正则化

正则化的思想:在损失函数中加入刻画模型复杂程度的指标.

假设用于刻画模型在训练数据上表现的损失函数为J(θ),那么在优化时不是直接优化J(θ)

而是优化J(θ) + λR(w), 其中R(w)刻画的是模型的复杂程度,λ表示模型复杂损失在总损失中的比例

这里的θ为一个神经网络中所有的参数,它包括边上的权重w和偏置项b

一般来说模型复杂程度只由权重w决定

常用的刻画模型复杂度的函数R(w)有两种:

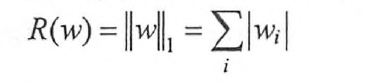

(1)L1正则化,计算公式是:

(2)L2正则化,计算公式是:

无论哪一种正则方式,基本思想都是希望通过限制权重的大小,使得模型不能任意拟合训练数据中的随机噪音

L1正则化会让参数变得更稀疏,而L2正则化不会

所谓参数变得稀疏是指会有更多的参数变为0,这样可以达到类似特征选取的功能

之所以L2正则化不会让参数变得稀疏的原因是当参数很小时,比如0.001,这个参数的平方基本上

就可以忽略了,于是模型不会进一步将这个参数调整为0

注意:L1正则化的计算公式不可导,L2的正则化公式可导

在实践中,也可以将L1正则化和L2正则化同时使用

4.4.3滑动平均模型

本节将介绍另外一个可以使模型在测试数据上更健壮的方法--滑动平局模型