论文:Light-Weight RefineNet for Real-Time Semantic Segmentation

Github:https://github.com/DrSleep/light-weight-refinenet

BMVC 2018

论文贡献:

论文提出了RefineNet 的轻量化版本Light-Weight RefineNet ,针对实时分割任务,将速度从20FPS提升到了55FPS(GPU,512*512输入,Mean IOU 81.1%,PASCAL VOC测试集)

网络结构:

(a)RefineNet 的总体网络结构,分为下采样的encoder部分和上采样的decoder部分。网络主要包含4个模块,RCU,CRP,FUSION,CLF。为了轻量化该网络,分别使用RCU-LW,CRP-LW。

FUSION-LW替换了原始网络的RCU,CRP,FUSION。通过后续的实验作者又发现RCU对于网络的精度提升效果微弱,因此将RCU模块也去掉了。

为什么去掉RCU模块,网络精度影响很小,因为

(1)虽然RCU模块中的3*3卷积使得网络具有更大的感受野,但是通过shortcut结构,底层特征和高层特征也可以共享。

(2)CRP模块也可以获得上下文的信息

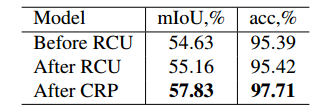

可以从上图看出,RCU模块对精度提升微弱,而CRP模块对精度提升明显。

(b)RCU模块

(c)CRP模块

(d)FUSION模块

(e)RCU-LW模块,在原始结构的基础上增加了1*1卷积,使得网络运算量减少

(f)CRP-LW模块,将原始的3*3卷积换为1*1卷积,在分割任务中,影响很小

(g)FUSION-LW模块,将3*3卷积换成1*1卷积

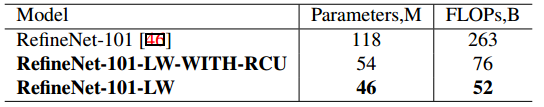

参数对比:

基于ResNet101的基础结构的RefineNet,第一个为传统的RefineNet,第二个为带RCU的RefineNet,第三个为不带RCU的RefineNet。可见RefineNet-101-LW相比RefineNet-101将参数量和运算量都大大降低。

实验结果:

总结:

对于分割任务,可以使用1*1卷积替换3*3卷积来加速,并保证精度。