目录

- 概述

- 原理

- 要点

- 实例

1、概述

K最近邻(k-Nearest Neighbor,KNN),指导思想是“近朱者赤,近墨者黑”,由你的邻居来推断出你的类别,KNN分类算法是最简单的机器学习算法。

2、原理

从训练集中找到和新数据最接近的k条记录,然后根据多数类来决定新数据类别,本质上,KNN是使用距离来计算相似度。

算法涉及3个主要因素:训练数据集;距离或相似度的计算衡量;k的大小。

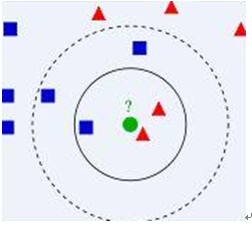

已知两类“先验”数据,分别是蓝方块和红三角,他们分布在一个二维空间中;

有一个未知类别的数据(绿点),需要判断它是属于“蓝方块”还是“红三角”类;

考察离绿点最近的3个(或k个)数据点的类别,占多数的类别即为绿点判定类别。

3、要点

扫描二维码关注公众号,回复:

4716221 查看本文章

- 计算步骤

算距离:给定测试对象,计算它与训练集中的每个对象的距离;

找邻居:圈定距离最近的k个训练对象,作为测试对象的近邻;

做分类:根据这k个近邻归属的主要类别,来对测试对象分类。

- 相似度的衡量

距离越近应该意味着这两个点属于一个分类的可能性越大。

距离不能代表一切,有些数据的相似度衡量并不适合用距离。

相似度衡量方法:包括欧式距离、夹角余弦等。

简单应用中,一般使用欧氏距离,但对于文本分类来说,使用余弦(cosine)来计算相似度就比欧式(Euclidean)距离更合适。

- 类别判定

简单投票法:少数服从多数,近邻中哪个类别的点最多就分为该类。

加权投票法:根据距离的远近,对近邻的投票进行加权,距离越近则权重越大(权重为距离平方的倒数)

4、实例

- 使用knn算法来实现对手写数字的自动识别