一、cnn参数计算

假设输入7*7*3,卷积核3*3*2,stride=(1,1),输出是3*3*2

参数量计算:fileter_size✖️input_channel✖️output_channel

解释:参数量与输入尺寸无关,只是卷积核的参数,每一个卷积核首先对input_feature所有通道做卷积,得到 n*n*input-channel,然后input_channel个n*n 的feature_map相同位置数目相加,再➕bias,得到n*n*1的feature_map输出,因为有output_channel个filter,所以输出n*n*output*channel(通俗容易想象的解释)

二、lstm参数计算

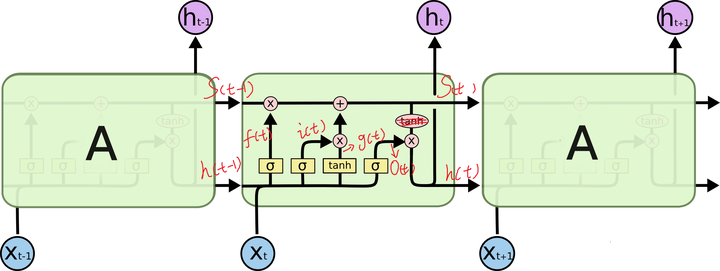

lstm原理图,一个绿色框是一个cell,上边一行S(t)表示长时记忆,下边一行h(t)表示短时记忆

每一个小黄框代表一个前馈网络层,对,就是经典的神经网络的结构,num_units就是这个层的隐藏神经元个数,就这么简单。其中1、2、4的激活函数是 sigmoid,第三个的激活函数是 tanh。

1、 cell 的状态是一个向量,是有多个值的

2、 上一次的状态 h(t-1)和下一次的输入 x(t) 结合(concat)起来的,向量直接拼起来,比如 x是28位的向量,h(t-1)是128位的,那么拼起来就是156位的向量。

3、 cell 的权重是共享的,这是什么意思呢?这是指这张图片上有三个绿色的大框,代表三个 cell 对吧,但是实际上,它只是代表了一个 cell 在不同时序时候的状态,所有的数据只会通过一个 cell,然后不断更新它的权重。

4、那么一层的 LSTM 的参数有多少个?根据第 3 点的说明,我们知道参数的数量是由 cell 的数量决定的,这里只有一个 cell,所以参数的数量就是这个 cell 里面用到的参数个数。假设 num_units 是128,输入是28位的,那么根据上面的第 2 点,可以得到,四个小黄框的参数一共有 (128+28)*128*4,也就是156 * 512,可以看看 TensorFlow 的最简单的 LSTM 的案例,中间层的参数就是这样,不过还要加上输出的时候的激活函数的参数,假设是10个类的话,就是128*10的 W 参数和10个bias 参数

5、lstm网络的unit在深度学习网络框架中是指一层的output size(hidden size),相当于MLP一层的神经元数目,lstm的一个cell相当于一层lstm。

总结:units_num=y,input_size=m*x,bias=y,输入和上一时刻h(t-1)是concat关系

rnn参数量(x+y)✖️y+y

lstm因为有四个单元,4*【(x+y)✖️y+y】

参考:https://www.zhihu.com/question/64470274/answer/256379387

写的比较详细的一个lstm介绍:http://www.cnblogs.com/wangduo/p/6773601.html?utm_source=itdadao&utm_medium=referral