1 ROC

ROC((Receiver Operating Characteristic Curve)),即受试者工作特征曲线。ROC曲线是用来验证一个分类器(二分)模型的性能的。其工作原理是,给出一个模型,输入已知正负类的一组数据,并通过对比模型对该组数据进行的预测,衡量这个模型的性能。

TP:实际是正样本预测成正样本的样本数

FN:实际是正样本预测成负样本的样本数

FP:实际是负样本预测成正样本的样本数

TN:实际是负样本预测成负样本的样本数

TPR=TP/(TP+FN),也称为“命中率”

FPR=FP/(FP+TN),也称为“假报率”

TNR=TN/(FP+TN),也称为“敏感度”

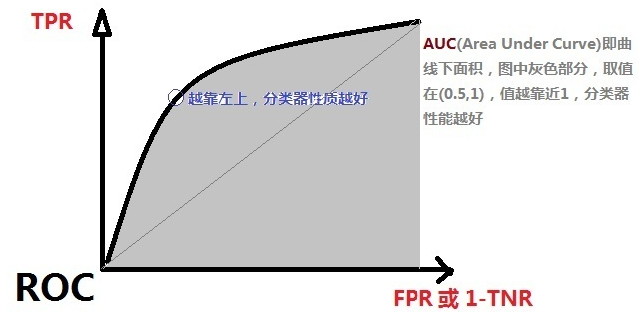

- ROC曲线如下图所示

(0,0):分类器全部预测成负样本,这种情况说明阈值选得过高

(0,1):全部完美预测正确

(1,0):全部完美预测错误

(1,1):分类器全部预测成正样本,这种情况说明阈值选得过低

TPR=FPR,斜对角线,预测为正样本的结果一半是对的,一半是错的,代表随机分类器的预测效果

2 AUC

- AUC(Area Under Curve):ROC曲线与FPR轴线形成的面积,是对ROC曲线的量化指标。AUC的值越大越好,其取值范围为(0.5,1)。

3 ACC

- ACC(Accuracy):准确率,ACC=(TP+TN)/(TP+TN+FP+FN),即分类器准确识别真阳性和假阴性的比率。

- ACC没办法较好地脱离测试数据对模型进行评价,这也就是我们为什么要用ROC的原因。(如一组数据负样本比例极高,ACC值高,表明对负类预测很准;但另一组数据正样本比例高,这样ACC的值会很低)

4 召回率(Recall)

- 召回率表示样本中的正例有多少被预测正确,有两种可能:一种是把原来的正类预测成正类(TP),另一种就是把原来的正类预测为负类(FN)。

- R=TPR=TP/(TP+FN)

5 精度(Precision)

- 精度表示预测为正的样本中有多少是正确的,有两种可能:一种就是把正类预测为正类(TP),另一种就是把负类预测为正类(FP)。

- P=TP/(TP+FP)

参考

https://blog.csdn.net/shenpibaipao/article/details/78033218

https://blog.csdn.net/sunflower_sara/article/details/81214897