BOND&TEAM

让Linux内核支持网卡绑定驱动。常见的网卡绑定驱动有三种模式——mode0、mode1、mode6。

mode0(平衡负载模式):平时两块网卡均工作,且自动备援,但需要在与服务器本地网卡相连的交换机设备上进行端口聚合来支持绑定技术。

mode1(平衡备援模式):平时只有一块网卡工作,在它故障后自动替换为另外的网卡。

mode6(平衡负载模式):平时两块网卡工作,且自动备援,无需交换机设备提供辅助支持。

BOND:

网卡bond是通过把多张网卡绑定为一个逻辑网卡,实现本地网卡的冗余,带宽扩容和负载均衡。在应用部署中是一种常用的技术。bond不支持负载均衡。

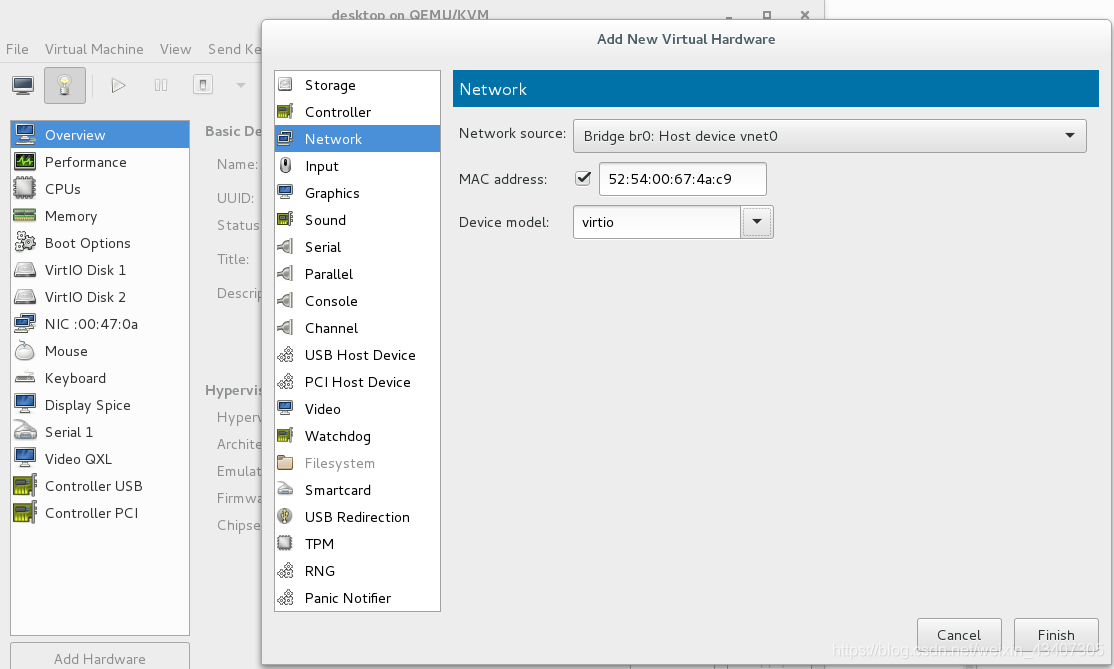

为了试验我们先给虚拟机配置两块网卡

bond

命令方式设置链物聚合bond模式

nmcli connection add con-name bond0 ifname bond0 type bond mode active-backup ip4 172.25.71.100/24 添加虚拟接口 bond0

active-backup 轮循

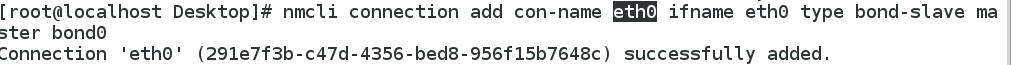

nmcli connection add con-name eth0 ifname eth0 type bond-slave master bond0

给虚拟接口bond0添加物理设备eth0

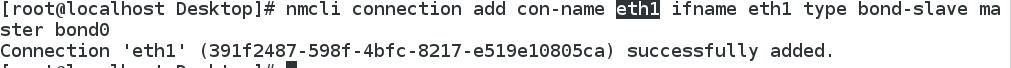

nmcli connection add con-name eth1 ifname eth1 type bond-slave master bond0

给虚拟接口bond0添加物理设备eth1

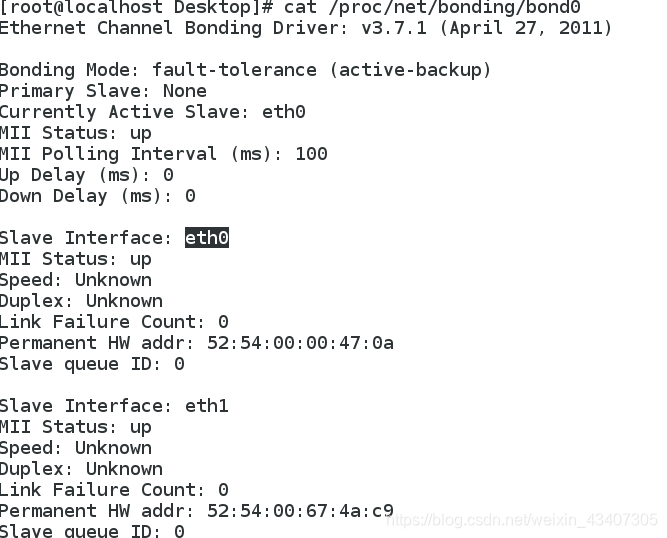

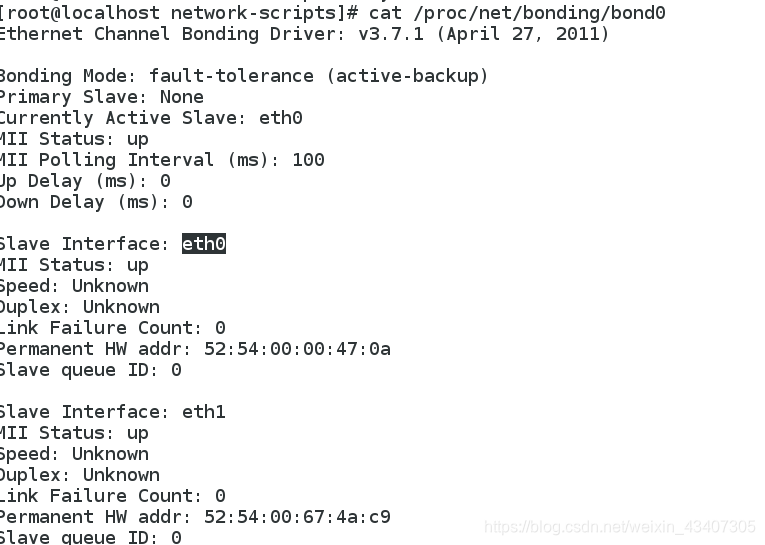

watch -n 1 cat /proc/net/bonding/bond0 监视虚拟接口信息,

此处我们查看虚拟接口bond0的信息,看物理设备是否添加上,可以看到物理设备已经添加上了

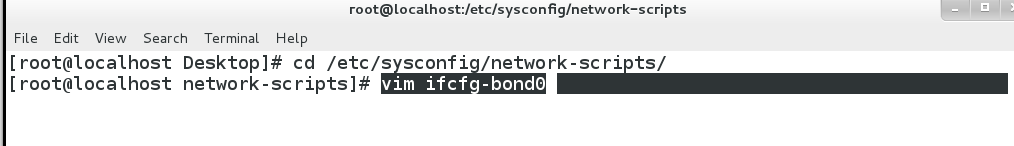

配置文件设置链路聚合bond模式

#先把前面配置的虚拟bond0接口删掉

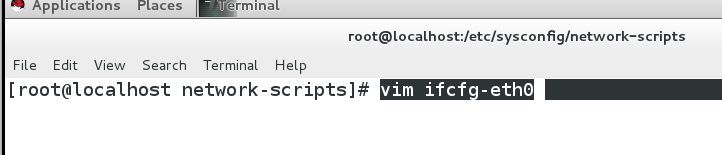

1.cd /etc/sysconfig/network-scripts

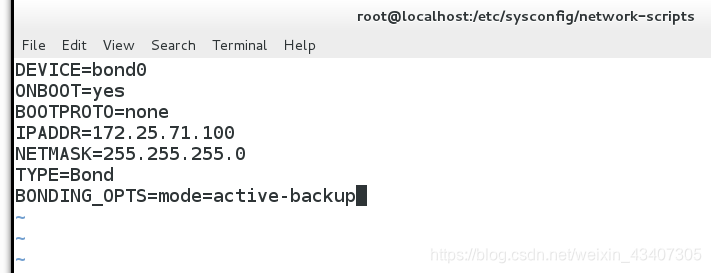

vim ifcfg-bond0 ##编辑bond0文件,内容如下

DEVICE=bond0

ONBOOT=yes

BOOTPROTO=none

IPADDR=172.25.71.100

NETMASK=255.255.255.0

TYPE=Bond

BONDING_OPTS=mode=active-backup设置类型为轮循

2.vim ifcfg-eth0 ##编辑eth0文件,内容如下

DEVICE=eth0

ONBOOT=yes

BOOTPROTO=none

MASTER=bond0 服务的对象是我们配置的虚拟接口bond0

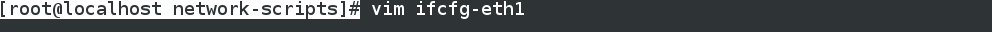

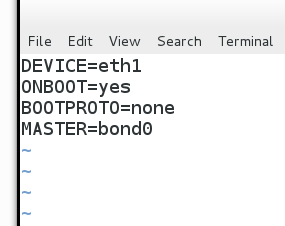

3.vim ifcfg-eth1 ##编辑eth1文件,内容与eth0一样,只不过device=eth0

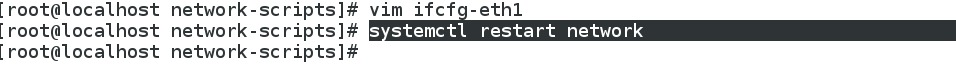

4.重启网络

5.watch -n 1 cat /proc/net/bonding/bond0 监视虚拟接口信息,

此处我们查看虚拟接口bond0的信息,看物理设备是否添加上,可以看到物理设备已经添加上了

bond不支持负载均衡,ipv6,加密

team

在 linux 中, centos7之前都是使用bond机制来实现多网络绑定同一个IP 地址,来对网络提供访问,并按不同的模式来负载均衡或者轮回接替管理处理数据。而到了contos7之后,提供了一种强大的工具,nmcli工具命令,使用此工具,将会根据命令参数的配置来重新生成特定的配置文件来供网络接口使用,方便而又灵活。在linux不再使用bond机制定义,而是使用网路组 team 机制,把 team 组当作一个设备。

team :也是链路聚合 最多支持8块网卡,Team 不需要手动加载相应内核模块

支持模式:

broadcast 广播容错

roundrobin 轮询

activebackup 主备

loadbalance 负载均衡

命令的方式设置链物聚合team模式

1.做之前删除之前的bond0

bond不支持加密,ipv6,和负载均衡,兼容性比较差,team支持这些功能,兼容性比较好

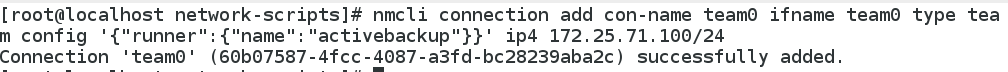

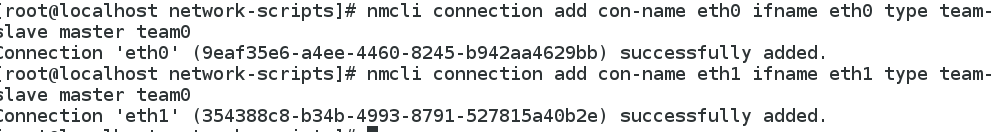

2.nmcli connection add con-name team0 ifname team0 type team config ‘{“runner”:{“name”:“activebackup”}}’ ip4 172.25.71.100/24 ##添加虚拟接口team0 activebackup 类型为轮询

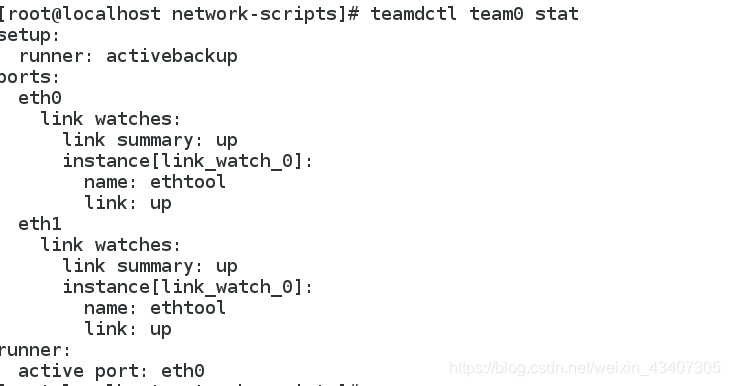

watch -n 1 teamctl team0 stat ##监控接口信息

3.nmcli connection add con-name eth0 ifname eth0 type team-slave master team0 ##给虚拟接口team0添加物理设备eth0

nmcli connection add con-name eth1 ifname eth1 type team-slave master team0 ##给虚拟接口team0添加物理设备eth1

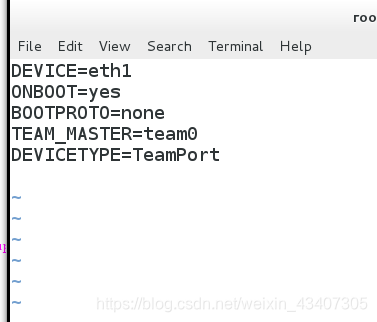

4.teamctl team0 stat 查看接口信息,看物理设备是否添加成功

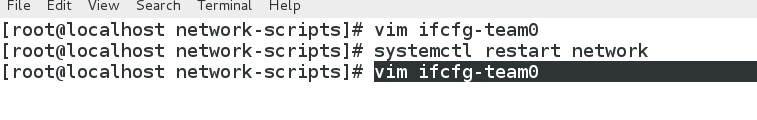

配置文件的方式设置链物聚合team模式

cd /etc/sysconfig/network-scripts

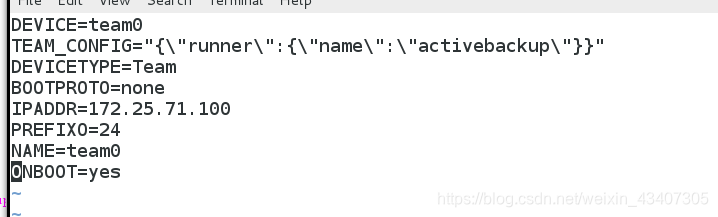

1.vim ifcfg-team0 ##编辑虚拟接口team0

DEVICE=team0

TEAM_CONFIG="{\"runner\":{\"name\":\"activebackup\"}}" 轮询类型

DEVICETYPE=Team

BOOTPROTO=none

IPADDR=172.25.71.100

PREFIXO=24

NAME=team0

ONBOOT=yes

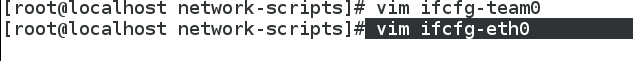

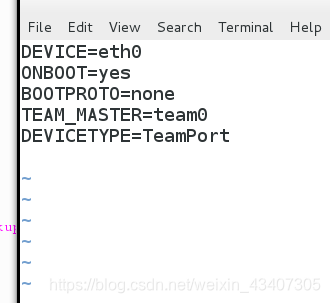

2.vim ifcfg-eth0 ##编辑eth0

BOOTPROTO=none

DEVICE=eth0

ONBOOT=yes

TEAM_MASTER=team0 服务team0虚拟接口

DEVICETYPE=TeamPort

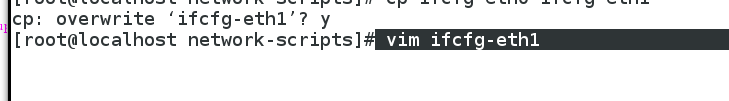

3.vim ifcfg-eth1 ##编辑eth1

BOOTPROTO=none

DEVICE=eth1

ONBOOT=yes

TEAM_MASTER=team0 服务team0虚拟接口

DEVICETYPE=TeamPort

4.systemctl restart ntwork ##重启网路

5.teamctl team0 stat 查看接口信息,看物理设备是否添加成功

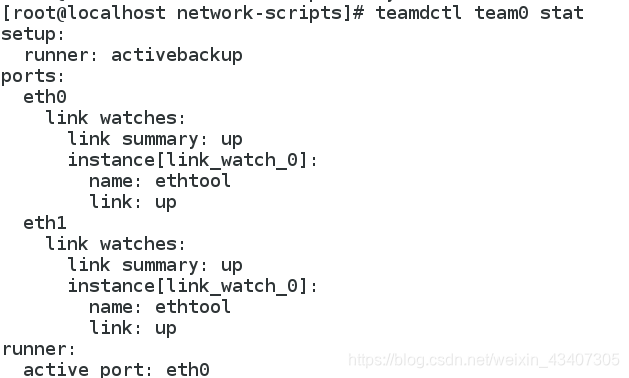

桥接

桥接就是通过一台设备(或几台设备)把几个网络串起来形成的连接,就是通过桥接来实现无路由双机上网的连接方案

桥接我们选择在真机上做这个实验

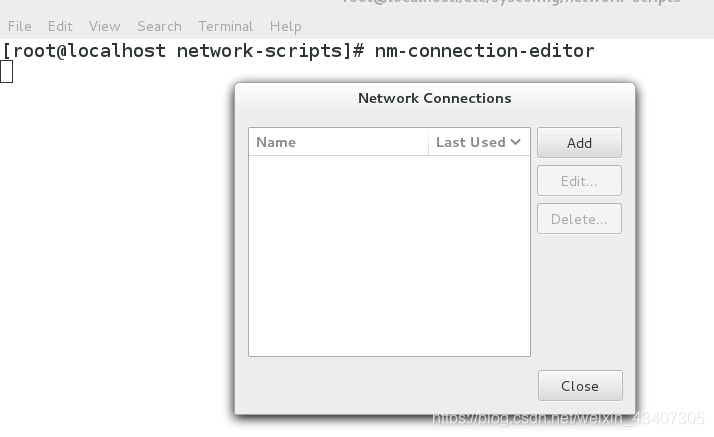

1.删除真机上所有网络配置

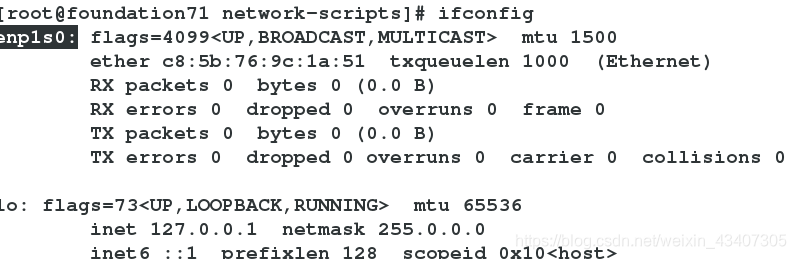

2.查看真机的网卡名称

3.开始建立桥接

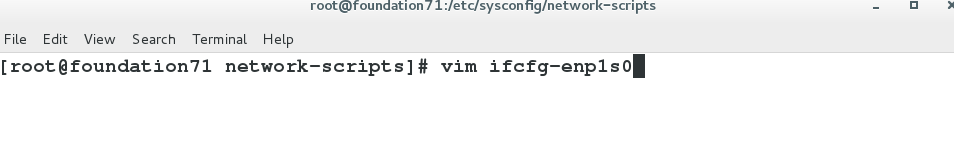

cd /etc/sysconfi/network-scripts/

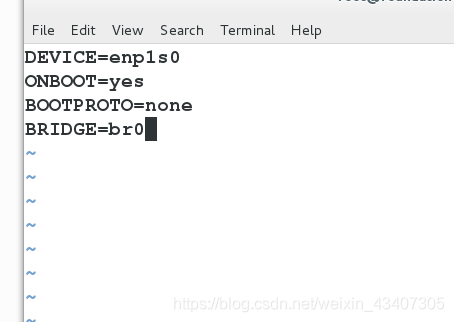

vim ifcfg-enp1s0 ##编辑网卡的配置文件

DEVICE=enp1s0

ONBOOT=yes

BOOTPROTO=none

BRIDGE=br0 桥接端口为br0

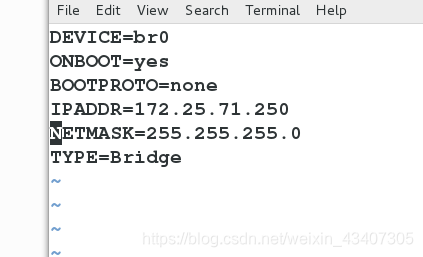

4.vim ifcfg-br0 ##编辑桥接接口br0的配置文件

DEVICE=br0

ONBOOT=yes

BOOTPROTO=none

IPADDR=172.25.71.250

NETMASK=255.255.255.0

TYPE=Bridge 类型为桥接

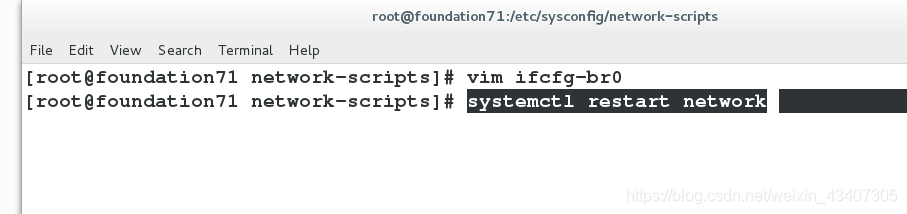

5.systemctl restart network ##重启网络

6.brctl show ##查看桥接信息

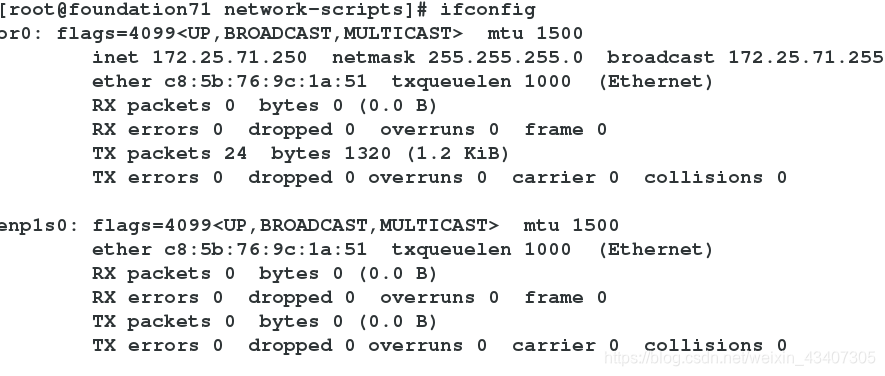

7.查看桥接网络是否配置成功

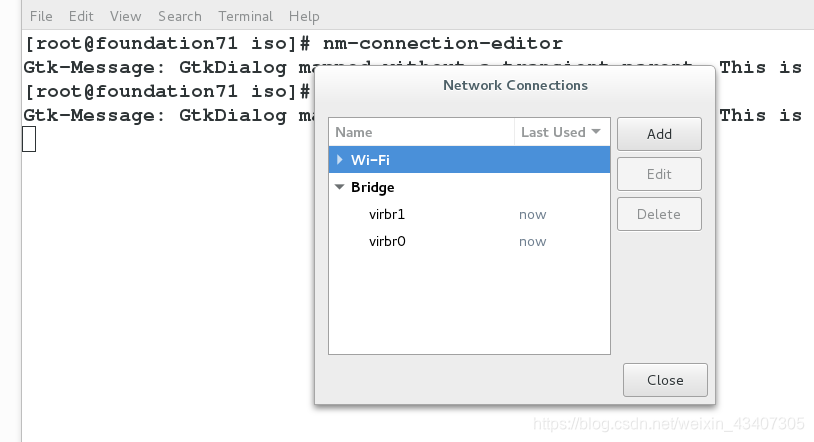

用命令的方式设置桥接

因真机的桥接我们已经设置好了,所以命令的方式我们在虚拟机上进行试验

添加:

1.先删除所以的网络配置

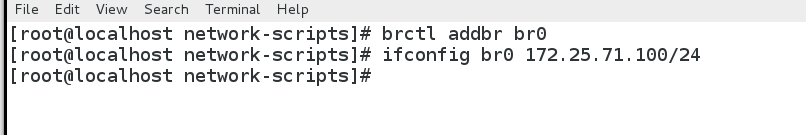

1.brctl addr br0 ##添加br0桥接接口

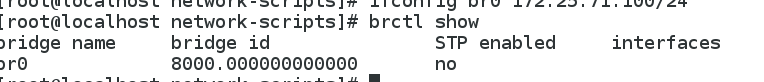

2.ifconfig br0 172.25.71.100/24 ##配置br0桥接接口的ip

3.brctl show ##查看桥接信息,发现桥接接口已经存在,但没有物理设备加持

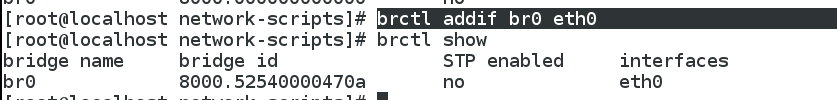

4.brctl addif br0 eth0 ##将桥接端口插到eth0网卡上

5.brctl show ##查看桥接信息,可以看到已经插上

6.ping 172.25.71.250可以ping同

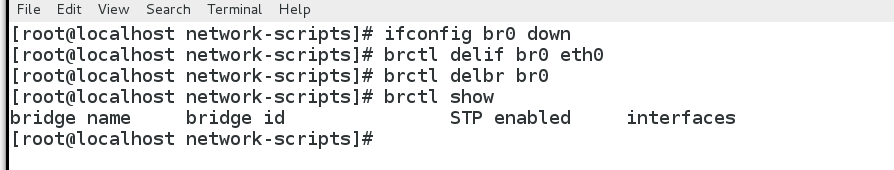

7.删除:

ifconfig br0 down ##关掉br0

brctl delif br0 eth0 ##将桥接端口从eth0网卡上拔出

brctl delbr br0 ##删除桥接端口

brctl show 看到桥接信息,可以发现br0桥接服务已经删除