一、bond的Active-backup工作模式的配置

网卡的bond工作模式是 通过软件工具将多块真实物理网卡虚拟成一个网卡,配置完毕后,所有的物理网卡都成为这个虚拟物理网络接口的子部件,而且这些组合起来的物理网卡会拥有同一个IP和MAC地址。 这样将多块网卡绑定在一起的方式 一是可以增加接口的带宽,二是能够实现轮询、负载均衡和冗余功能。

(一)、用命令的方法配置网络的bond的active-backup工作模式:

### 1.在虚拟机上添加两块全新的未经过配置的物理网卡:

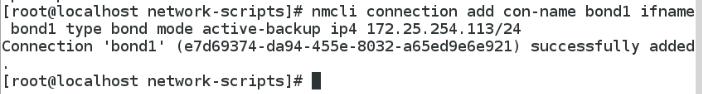

### 2.建立虚拟的bond网络接口:band1

使用命令: nmcli connection add con-name bond1 ifname bond1 ytpe bond mode active-backup ip4 172.25.254.113/24 来建立虚拟的bond网络接口:

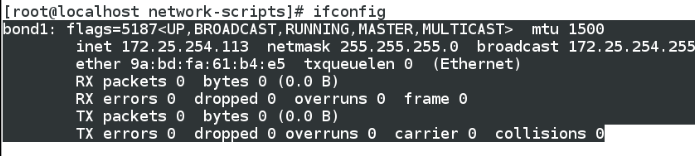

用ifconfig 命令查看虚拟的bond接口 bond1是否建立成功:

如上图所示,bond1已经建立成功。

### 3.将真实网卡加入虚拟的bond1接口:

使用命令: nmcli connection add con-name eth0 ifname eth0 type bond-slave master bond1 将物理网卡eth0加入bond1这个虚拟网络接口:

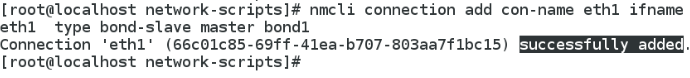

再用上面的命令将eth1加入bond1的虚拟网络接口:

接着用命令:cat /proc/net/bonding/bond1,来查看bond1接口的相关配置:

由上图可知 虚拟接口bond1 工作的模式是actice-backup,并且当前活跃的子接口为 eth0。

当我们用命令 ifconfig eth0 down 这个命令使接口eth0 断掉后,发现eth1接口会立马替补eth0的工作:

这样就起到了接口冗余的功能。

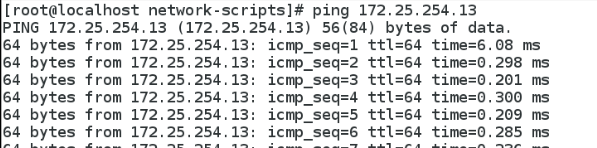

最后我们测试一下网络的连通性,用该虚拟接口ping 真机的物理网卡,如下图显然是通的:

到这里bond的active-backup模式的工作方式就配置结束了。

(二)文本的配置方式:

首先我们用图形界面的方式将上面实验的bond1接口删除掉(eth0和eth1接口也会同时被删除,不需要我们一一动手去删除):

#文本的配置方式主要是要编辑三个文件,即一个bond接口的配置和两个子网卡接口的配置,下面开始正式的配置:

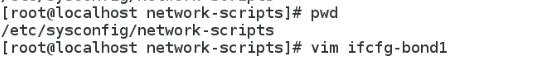

###1. 第一步在 /etc/sysconfig/network-scripts 目录下面创建 bond1虚拟网络接口的配置文件:

文件内容如下:

配置好后保存退出,并重启网络,然后用cat /proc/net/bonding/bond1 来查看是否配置成功:

### 2.第二步创建 子接口的 配置文件:

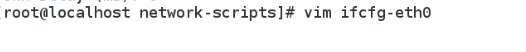

和上一步骤在同一个目录下,创建子接口的配置文件:

文本内容如下:

然后重启网络,并用命令 cat /proc/net/bonding/bond1 查看bond1 的相关配置:

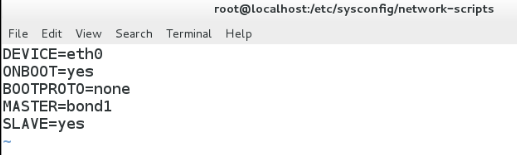

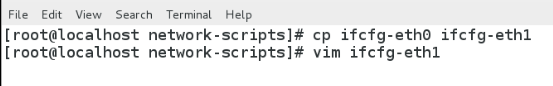

同样的方式再将eth1这个网卡配制成bond1 的子接口:

eth1接口的配置内容:

重启网络,检验配置的结果:

测试:

在eth0正常工作时bond1接口的工作状态:

当 down掉eth0接口后 bond1接口的工作状态:

结果说明bond1的 active-backup的工作模式配置成功。

二、Team的Activebackup工作模式的配置

虽然Teanm和bonf在很大程度上是类似的,但与bond最多只支持两块网卡相比,team方式最多可支持达8块网卡,并且不需要手动加载相关的内核模块,还拥有广播功能,具有更强的扩展性,是加强版的bond模式。

(一)命令方式配置Team的 activebackup工作模式:

### 1.配置虚拟网络总接口Team1:

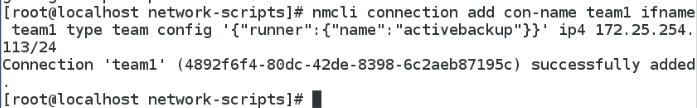

用命令: nmcli connection add con-name team1 ifname team1 type team config '{"runner":{"name":"activebackup"}}' ip4 172.25.254.113/24

用teamdctl team1 stat 命令可以查看team1接口配置的相关信息:

### 2. 为总接口team1添加子接口:

用命令: nmcli connection add con-name eth0 ifname eth0 type teanm-slave master team1 来将物理网卡 eth0加入team1总接口:

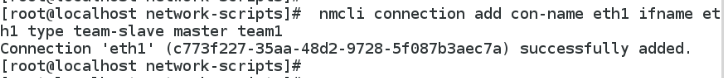

同样的方式将 eth1加入总接口team1 :

现在用命令 teamdctl team1 stat 来查看team1接口的相关配置:

由上图可以看出 eth0和eth1 已经被加入了team1接口中,并且当前活跃的子接口为 eth0。

(二)文本的方式配置team的activebackup工作模式:

#同bond的文本配置类似,Team的activebackup工作模式同样需要创建三个配置文件。

实验前请记得初始化实验环境:

### 1.总接口team1 的配置文件的创建:

查看是否配置成功:

### 2.创建子接口 eth0和eth1的配置文件

首先创建eth0的配置文件:

查看是否配置成功:

再配置子接口eth1的配置文件:

查看配置结果:

到这里我们对team的activebackup工作模式的配置就完成了。

三、高级网络配置——真机桥接模式的配置

虚拟机要想通过自己的网卡与真实网卡以及外网进行数据交换,一种方式是在真机内核上进行NAT转换,然后与本机的物理网卡以及外网进行进行数据交换,但这种方式由于从虚拟机的网卡传出的数据要在内核上进行数据的封装所以交换数据速度变慢;还有一种方式就是通过桥接的方式进行数据的交换,这种方式相当于内核对真实物理网卡开启了共享接口,这样虚拟机就可以通过内核开启的接口进行数据的交换。

相比之下桥接的方式显然更优。桥接的意义就是内核对虚拟设备共享了真实网卡的权限(实际是在网卡上开了一个开放接口),使虚拟设备可以通过真实网卡进行数据通信。

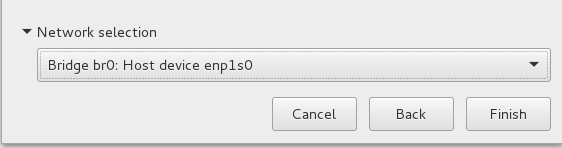

在由桥接配置的主机上安装虚拟机的时候,网络选项上会由桥接的一个选项,如下图:

(一)、文本方式配置网桥

# 为了实验效果作者将自己网桥配置进行备份,然后删除掉本机的网桥配置。

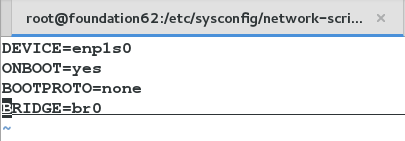

首先,对本机的物理网卡进行配置:

配置文件内容如下图:

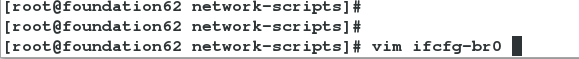

然后配置网桥文件:

文本内容如下:

配置完这两个文件,我们再重启电脑。再次开机后,主机的网桥就配置成功了。

(二)、命令的方式配置网桥:

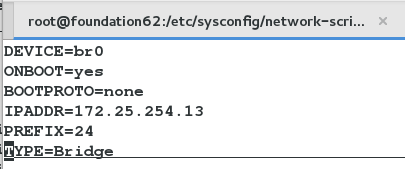

### 1.输入命令 brctl addbr br0 ,表示增加网桥设备:

### 2. 输入命令 brctl addif br0 eth0 ,表示将网桥设备桥接到网卡eth0上。

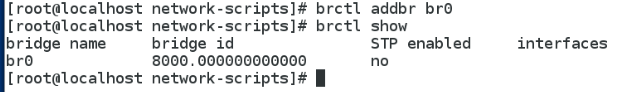

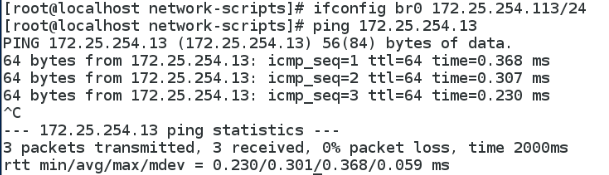

### 3.再给br0这个网桥设备配置ip:

用命令: ifconfig br0 172.25.254.113/24

到这里用命令的方式配置网桥的过程就结束了。

注意!命令的方式配置的网桥是一次性的,只要重启系统就会失效。

### 4. 命令的方式删除配置的网桥:

首先删掉桥接的物理网卡: brctl delif br0 eth0

接着关闭网桥设备的开启状态: ifconfig br0 down

最后删除掉网桥设备: brctl delbr br0

到这里本次的文章内容就结束了。因为作者是位运维的门外汉,但又十分想跨入运维的大门,所以写的文章肯定会由很多的漏洞和错误,希望阅读此文章的读者可以尽情提出来,谢谢!