版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/anpingbo/article/details/79144433

Karhunen-Loveve变换

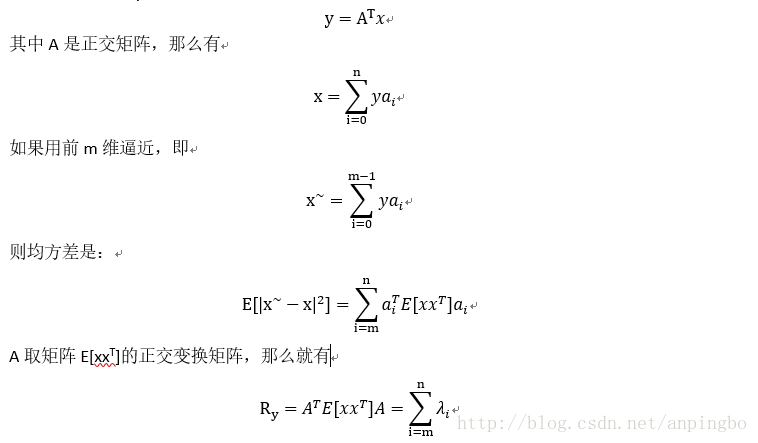

KL变换用于维数降低,维数降低可以大大降低计算量。KL变换是通过线性变换,将空间映射到另外空间,然后可以在另外空间进行维数裁剪,去掉影响较小的维,从而降低维数。

假设由x映射到y,变换为A,即有

其中R_y就是对角矩阵。然后可通过选择对应最小特征值的向量来作为新的维,从而降低维数。

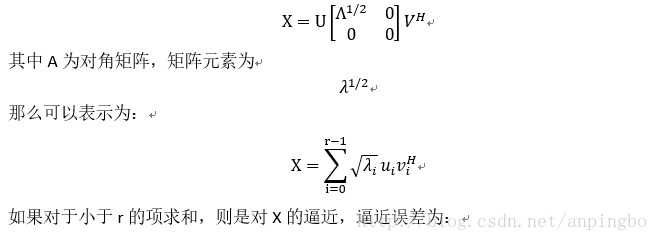

奇异值分解

奇异值分解被广泛用于矩阵计算,其可以提取矩阵中非零元素,降低矩阵计算量。在模式识别中被用于维数降低,奇异值分解即对于任意矩阵X,其秩为lXn,则存在酋矩阵U和V,

独立成分分析(ICA)

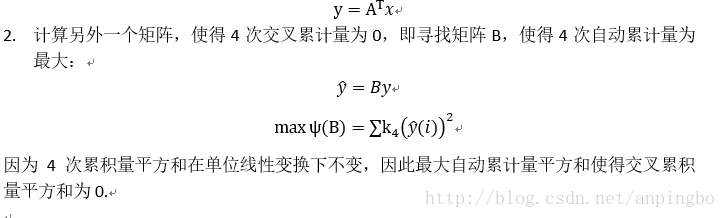

前边的KL变换是为了得到不相关特征,然后在此基础上降低维数,其得到的结果是最优的。而ICA是为了得到独立变量,这个比不相关量要求更加严格。计算ICA可以对PCA进行推广,PCA是要求二次交叉累积量为0,而ICA要求所有高次交叉累积量为0.一般将运算限制在4次就够了。

整个过程为:

通过 KL 变换计算: