数据结构与算法的关系是相互依赖且不可分割的。

算法的定义:是解决特定问题求解步骤的描述,在计算机中表现为指令的有限序列,并且每条指令表示一个或多个动作。在算法的定义中提到了指令,指令是能被人或机器等计算装置执行,它可以是计算机指令,也可以是我们平时的语言文字。为了解决某个问题,需要将指令表示成一定的操作序列,操作系列包括一组操作,每一个操作完成特定的功能,这就是算法。简单来说就是描述解决问题的方法。

算法的特性:

- 输入 :一般情况下算法具有零个或多个输入。

- 输出 :算法至少有一个或多个输出,如果没有输出,我们还要这个算法干嘛???

- 有穷性 :在算法执行有限的步骤之后,自动结束而不是无限循环,并且每个步骤都在可接受的范围内完成,当然我们也要考虑现实应用中的合理,不能一个算法等上一天两天的。

- 确定性 :算法的每一步骤都具有确定的含义,不会出现二义性。算法在一定条件下,只有一条执行路径,相同的输入只能有唯一的结果。

- 可行性 : 算法每一步都必须是可行的,就是每一步都能通过执行有限次数成,意味着算法可以转换为程序上机运行,并得到正确答案。

算法的设计要求:

- 正确性 :算法至少应具有输入,输出和加工处理无歧义性,能正确反映问题的需求,能够得到正确的答案。算法正确分为四个层次,①算法程序没有语法错误②算法程序对于合法的输入数据能够产生满足要求的输出结果③算法程序对于非法的输入数据能够得到满足规格说明的结果④算法程序对于精心选择的,甚至刁难的测试数据都有满足要求的结果输出。一般情况下我们将层次三作为一个算法是否正确的标准。

- 可读性 : 算法设计的另一目的是为了便于阅读,理解和交流。可读性有助于人们理解算法,晦涩难懂的算法一般隐含错误并难以发现,并且难于调试和修改。

- 健壮性 : 当输入数据不合法时,算法也能做出相关处理,而不是产生异常或莫名其妙的错误。

- 时间效率高和存储量低 :时间效率指的是算法的执行时间,存储量指的是算法运行过程中所需要的内部或外部存储空间。设计算法过程中,我们尽量满足时间效率高和存储量低的需求。

函数渐进增长:在输入规模 n 在没有限制的情况下,只要超过一个数值 N ,这个函数就总大于另一函数,我们称之为渐进增长。具体来讲给定两个函数f(n)和g(n),如果存在一个正数N,使得所有的 n>N ,f(n)总比g(n)大,那么我们就认为f(n)的增长渐进快于g(n)。

时间频度:一个算法执行所耗费的时间,从理论上是不能算出来的,必须上机运行测试才能知道。但我们不可能也没有必要对每个算法都上机测试,只需知道哪个算法花费的时间多,哪个算法花费的时间少就可以了。并且一个算法花费的时间与算法中语句的执行次数成正比例,哪个算法中语句执行次数多,它花费时间就多。一个算法中的语句执行次数称为语句频度或时间频度。记为T(n)。

时间复杂度:前面提到的时间频度T(n)中,n称为问题的规模,当n不断变化时,时间频度T(n)也会不断变化。但有时我们想知道它变化时呈现什么规律,为此我们引入时间复杂度的概念。一般情况下,算法中基本操作重复执行的次数是问题规模n的某个函数,用T(n)表示,若有某个辅助函数f(n),使得当n趋近于无穷大时,T(n)/f(n)的极限值为不等于零的常数,则称f(n)是T(n)的同数量级函数,记作T(n)=O(f(n)),它称为算法的渐进时间复杂度,简称时间复杂度。

我们假设计算机运行一行基础代码需要执行一次运算。

int aFunc(void) {

printf("Hello, World!\n"); // 需要执行 1 次

return 0; // 需要执行 1 次

}

那么上面这个方法需要执行 2 次运算

int aFunc(int n) {

for(int i = 0; i<n; i++) { // 需要执行 (n + 1) 次

printf("Hello, World!\n"); // 需要执行 n 次

}

return 0; // 需要执行 1 次

}

这个方法需要 (n + 1 + n + 1) = 2n + 2 次运算。

我们把 算法需要执行的运算次数 用 输入大小n 的函数 表示,即 T(n) 。进而分析T(n)随着n的变化

此时为了 估算算法需要的运行时间 和 简化算法分析,我们引入时间复杂度的概念。

定义: 存在常数 c,使得当 N >= c 时 T(N) <= f(N),表示为 T(n) = O(f(n)) 。

如图:

当 N >= 2 的时候,f(n) = n^2 总是大于 T(n) = n + 2 的,于是我们说 f(n) 的增长速度是大于或者等于 T(n) 的,也说 f(n) 是 T(n) 的上界,可以表示为 T(n) = O(f(n))。

因为f(n) 的增长速度是大于或者等于 T(n) 的,即T(n) = O(f(n)),所以我们可以用 f(n) 的增长速度来度量 T(n) 的增长速度,所以我们说这个算法的时间复杂度是 O(f(n))。

算法的时间复杂度,用来度量算法的运行时间,记作: T(n) = O(f(n))。它表示随着 输入大小n 的增大,算法执行需要的时间的增长速度可以用 f(n) 来描述。

显然如果 T(n) = n^2,那么 T(n) = O(n^2),T(n) = O(n^3),T(n) = O(n^4) 都是成立的,但是因为第一个 f(n) 的增长速度与 T(n) 是最接近的,所以第一个是最好的选择,所以我们说这个算法的复杂度是 O(n^2) 。

大O表示法

像前面用O( )来体现算法时间复杂度的记法,我们称之为大O表示法。

算法复杂度可以从最理想情况、平均情况和最坏情况三个角度来评估,由于平均情况大多和最坏情况持平,而且评估最坏情况也可以避免后顾之忧,因此一般情况下,我们设计算法时都要直接估算最坏情况的复杂度。

大O表示法O(f(n)中的f(n)的值可以为1、n、logn、n²等,因此我们可以将O(1)、O(n)、O(logn)、O(n²)分别可以称为常数阶、线性阶、对数阶和平方阶,那么如何推导出f(n)的值呢?我们接着来看推导大O阶的方法。

推导大O阶

推导大O阶,我们可以按照如下的规则来进行推导,得到的结果就是大O表示法:

1.用常数1来取代运行时间中所有加法常数。

2.修改后的运行次数函数中,只保留最高阶项

3.如果最高阶项存在且不是1,则去除与这个项相乘的常数。

常数阶

先举了例子,如下所示。

int sum = 0,n = 100; //执行一次

sum = (1+n)*n/2; //执行一次

System.out.println (sum); //执行一次 上面算法的运行的次数的函数为f(n)=3,根据推导大O阶的规则1,我们需要将常数3改为1,则这个算法的时间复杂度为O(1)。如果sum = (1+n)*n/2这条语句再执行10遍,因为这与问题大小n的值并没有关系,所以这个算法的时间复杂度仍旧是O(1),我们可以称之为常数阶。

线性阶

线性阶主要要分析循环结构的运行情况,如下所示。

for(int i=0;i<n;i++){

//时间复杂度为O(1)的算法

...

}上面算法循环体中的代码执行了n次,因此时间复杂度为O(n)。

对数阶

接着看如下代码:

int number=1;

while(number<n){

number=number*2;

//时间复杂度为O(1)的算法

...

}可以看出上面的代码,随着number每次乘以2后,都会越来越接近n,当number不小于n时就会退出循环。假设循环的次数为X,则由2^x=n得出x=log₂n,因此得出这个算法的时间复杂度为O(logn)。

平方阶

下面的代码是循环嵌套:

for(int i=0;i<n;i++){

for(int j=0;j<n;i++){

//复杂度为O(1)的算法

...

}

}内层循环的时间复杂度在讲到线性阶时就已经得知是O(n),现在经过外层循环n次,那么这段算法的时间复杂度则为O(n²)。

接下来我们来算一下下面算法的时间复杂度:

for(int i=0;i<n;i++){

for(int j=i;j<n;i++){

//复杂度为O(1)的算法

...

}

}需要注意的是内循环中int j=i,而不是int j=0。当i=0时,内循环执行了n次;i=1时内循环执行了n-1次,当i=n-1时执行了1次,我们可以推算出总的执行次数为:

n+(n-1)+(n-2)+(n-3)+……+1

=(n+1)+[(n-1)+2]+[(n-2)+3]+[(n-3)+4]+……

=(n+1)+(n+1)+(n+1)+(n+1)+……

=(n+1)n/2

=n(n+1)/2

=n²/2+n/2

根据此前讲过的推导大O阶的规则的第二条:只保留最高阶,因此保留n²/2。根据第三条去掉和这个项的常数,则去掉1/2,最终这段代码的时间复杂度为O(n²)。

其他常见复杂度

除了常数阶、线性阶、平方阶、对数阶,还有如下时间复杂度:

f(n)=nlogn时,时间复杂度为O(nlogn),可以称为nlogn阶。

f(n)=n³时,时间复杂度为O(n³),可以称为立方阶。

f(n)=2ⁿ时,时间复杂度为O(2ⁿ),可以称为指数阶。

f(n)=n!时,时间复杂度为O(n!),可以称为阶乘阶。

f(n)=(√n时,时间复杂度为O(√n),可以称为平方根阶。

4.复杂度的比较

下面将算法中常见的f(n)值根据几种典型的数量级来列成一张表,根据这种表,我们来看看各种算法复杂度的差异。

| n | logn | √n | nlogn | n² | 2ⁿ | n! |

|---|---|---|---|---|---|---|

| 5 | 2 | 2 | 10 | 25 | 32 | 120 |

| 10 | 3 | 3 | 30 | 100 | 1024 | 3628800 |

| 50 | 5 | 7 | 250 | 2500 | 约10^15 | 约3.0*10^64 |

| 100 | 6 | 10 | 600 | 10000 | 约10^30 | 约9.3*10^157 |

| 1000 | 9 | 31 | 9000 | 1000 000 | 约10^300 | 约4.0*10^2567 |

从上表可以看出,O(n)、O(logn)、O(√n )、O(nlogn )随着n的增加,复杂度提升不大,因此这些复杂度属于效率高的算法,反观O(2ⁿ)和O(n!)当n增加到50时,复杂度就突破十位数了,这种效率极差的复杂度最好不要出现在程序中,因此在动手编程时要评估所写算法的最坏情况的复杂度。

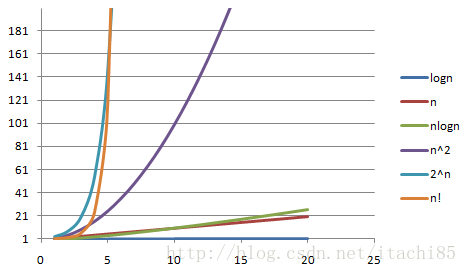

下面给出一个更加直观的图:

其中x轴代表n值,y轴代表T(n)值(时间复杂度)。T(n)值随着n的值的变化而变化,其中可以看出O(n!)和O(2ⁿ)随着n值的增大,它们的T(n)值上升幅度非常大,而O(logn)、O(n)、O(nlogn)随着n值的增大,T(n)值上升幅度则很小。

常用的时间复杂度按照耗费的时间从小到大依次是:

O(1)<O(logn)<O(n)<O(nlogn)<O(n²)<O(n³)<O(2ⁿ)<O(n!)参考:

《大话数据结构》

十分钟搞定时间复杂度:https://www.jianshu.com/p/f4cca5ce055a

算法(一) : https://blog.csdn.net/itachi85/article/details/54882603