前面已经配置好了集群环境zookeeper,hadoop。 以及分布式数据库hbase。 这个阶段要开始构建数据仓库的练习。涉及到的软件: mysql, hive 。

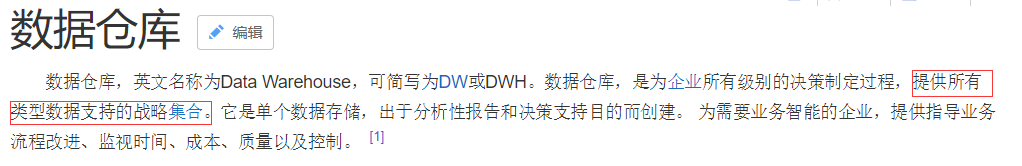

背景:

(我以前以为数据仓库就是数据库的数据库。。)

可见,hive本质是一个hadoop的工具。

mysql自然不必过多再去查询了。 需要注意的是它在centos7 的安装却有些讲究。 本来centos用yum 可以很方便的将mysql服务安装好,环境变量都不用配,但是我的网络环境不行,迫不得已只能去下载安装包!! 在ubutu上安装过mysql的tar.gz包,在windows上也可以下载zip包,但是centos上却需要下一个 bundle的包,并且还要注意版本的问题。 通过bundle安装还是第一次,所以遇到了很多的问题。

步骤:

1. centos 7 上安装mysql:

下载并解压下载下来的bundle包,并采用rpm进行安装。

修改密码策略并修改密码:

mysql本身的一些操作任务命令:

![]()

![]()

![]()

![]()

![]()

![]()

很多命令都是Mysql本身要求的,虽然也用了很多遍了,但是每次用的时候总还是需要查一查。 估计是没有在在课堂上将它当作古诗文而背下来的缘故,抑或是自己大脑觉得没有记得必要。。

2.hive服务端的安装:

2.1 解压并配置环境变量:

![]()

2.2 在hive服务器端,将mysql 的客户端连接: mysql-connector拷贝至:hive的lib下。 注意,这个mysql-connector只需拷贝到hive的服务器端即可,因为只有服务器端需要跟mysql 通信。 hive客户端只需与服务端通信,所以没有这些步骤。

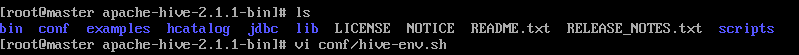

2.3 配置hive服务端的配置: conf/hive-env.sh

2.4 配置hive服务端配置: conf/hive-site.xml

3. hive客户端安装:

3.0 客户端需要和hadoo通信。 hadoop与hive的jline包版本需统一。 可以从Hive的lib包将jline的jar包拷贝给hadoop的lib位置。 注意这里的情况: hive客户端, hadoop服务器端。

3.1解压并配置环境变量。

3.2 修改conf/hive-env.sh, 新增hdoop路径。

3.3 配置conf/hive-site.xml:

5. hive数据仓库的验证:

服务端:

![]()

客户端:

![]()