正则化方法

为防止模型过拟合,提高模型的泛化能力,通常会在损失函数的后面添加一个正则化项。L1正则化和L2正则化可以看做是损失函数的惩罚项。所谓【惩罚】是指对损失函数中的某些参数做一些限制

L1正则化(ℓ1 -norm)

使用L1正则化的模型建叫做Lasso Regularization(Lasso回归),直接在原来的损失函数基础上加上权重参数的绝对值,

η为正则化参数:

假设损失函数为

J0=i=1∑m(y(i)−θ0−θ1X1(i)−θ2X2(i)−⋯−θnXn(i))(1)则Lasso Regularization为:

J=J0+ηi=1∑m∣θ∣(2)

J 是带有绝对值符号的函数,因此

J是不完全可微的。当我们在原始损失函数

J0后添加

L1正则化项时,相当于对

J0做了一个约束。令

L1=η∑i=1m∣θ∣,则

J=J0+L1,此时我们的任务变成在

L约束下求出

J取最小值的解。

η 被称为正则化系数.

下面通过图像来说明如何在约束条件

L1下求

J的最小值。

最终的损失函数就是求等高圆圈+黑色黑色矩形的和的最小值。由图可知等高圆圈+黑色黑色矩形首次相交时,

J取得最小值。

为什么

L1正则化项能够防止过拟合的情况?

对损失函数的参数优化求解过程进行分析

∂θ∂C=∂θ∂C0+λsgn(θ)(3)

上式中

sgn(θ)表示

θ的符号。那么权重

θ的更新规则为:

θ→θ−ηi=1∑m∂θ∂Ci−ηλsgn(θ)(4)

比原始的更新规则多出了

ηλsgn(θ)这一项。当

θ为正时,更新后的

θ变小。当

θ为负时,更新后的

θ变大——因此它的效果就是让

η往0靠,使网络中的权重尽可能为0,也就相当于减小了网络复杂度,防止过拟合。

L2正则化(ℓ2 -norm)

使用L2正则化的模型叫做Ridge Regularization(岭回归),直接在原来的损失函数基础上加上权重参数的平方和:

令损失函数为

J0,则Ridge Regularization为:

J=J0+21ηi=1∑nθ2(5)

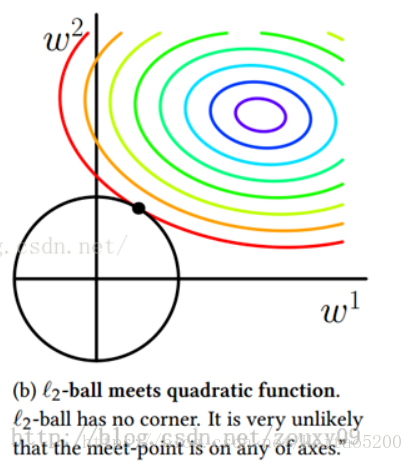

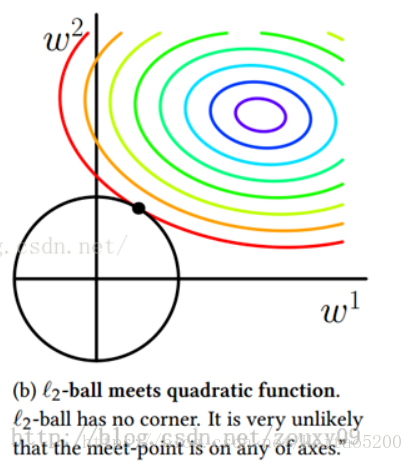

使最终的损失函数最小,要考虑

J0和

L2=21ηi=1∑nθ2(6)两个因素,最终的损失函数就是求等高 圆圈+黑色圆圈的和的最小值。由图可知两个圆相交时,

J取得最小值。

为什么

L2正则化项能够防止过拟合的情况?

对损失函数的参数优化求解过程进行分析

∂θ∂C=∂θ∂C0+λθ(7)

∂b∂C=∂b∂C(8)

可以发现L2正则化项对b的更新没有影响,但是对于

θ的更新有影响:

θ→θ−ηi=1∑m∂θ∂Ci−ηλθ

=(1−ηλ)θ−ηi=1∑m∂θ∂Ci(9)

在不使用L2正则化时,求导结果中

θ前系数为1,现在

θ前面系数为

1−ηλ ,因为η、λ都是正的,所以

1−ηλ小于1,它的效果是减小

θ,这也就是权重衰减(weight decay)的由来。