线性回归

- 单变量线性回归的目标是:通过模型来描述某一特征(解释变量X)与连续输出(目标变量y)之间的关系,当只有一个解释变量时线性模型定义如下。y=W0+W1X。W0成为函数在y轴上的截距,W1为系数。目标是通过学习得到线性方程的两个权值,并用他们描述解释变量和目标变量之间的关系,当解释变量为非训练集中数据时,可用此线性关系来预测对应的输出。

- 多元线性回归:线性回归模型扩展为多个解释变量,y=W0X0+W1X1+W2X2+…+WmXm = ΣWiXi = (点积)W^TX

- 相关性系数矩阵是一个包含皮尔逊积矩相关系数,他用来衡量两两特征间的线性依赖关系

- 基于最小二乘法构建线性回归模型

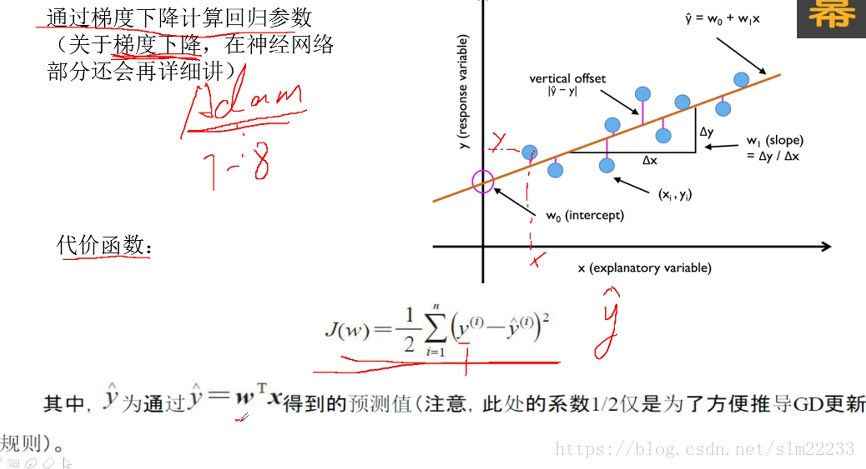

- 代价函数

- 梯度下降法是一种方法,优化的是代价函数

线性回归模型性能的评估

- 残差图:以残差为纵坐标,以任何其他指定的量为横坐标的散点图。度量线性回归模型的可视化工具

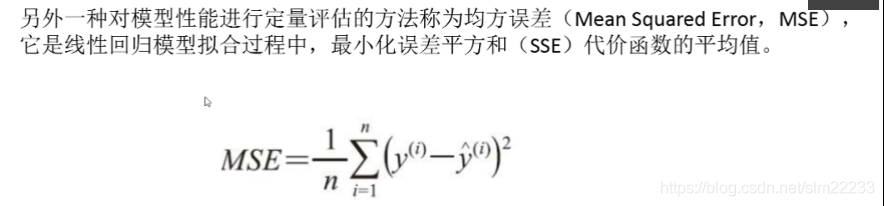

- MSE 均方误差

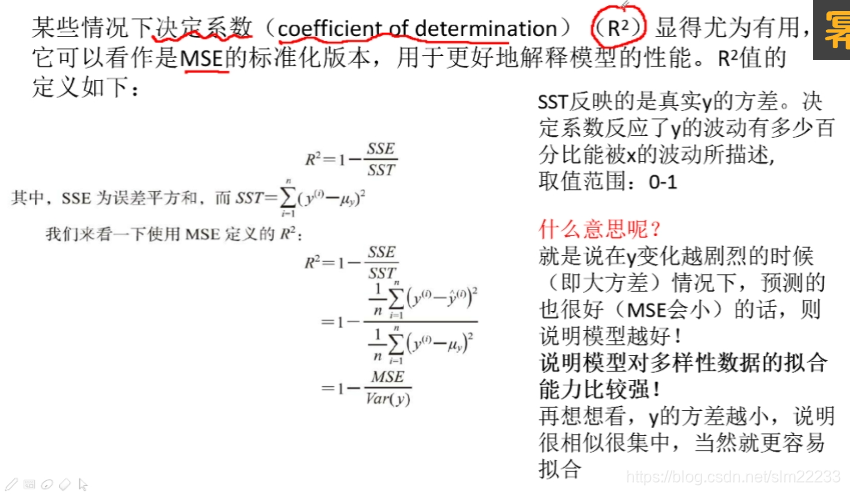

- 决定系数 R^2:可以看做是MSE的标准化版本

Var(y)表示方差

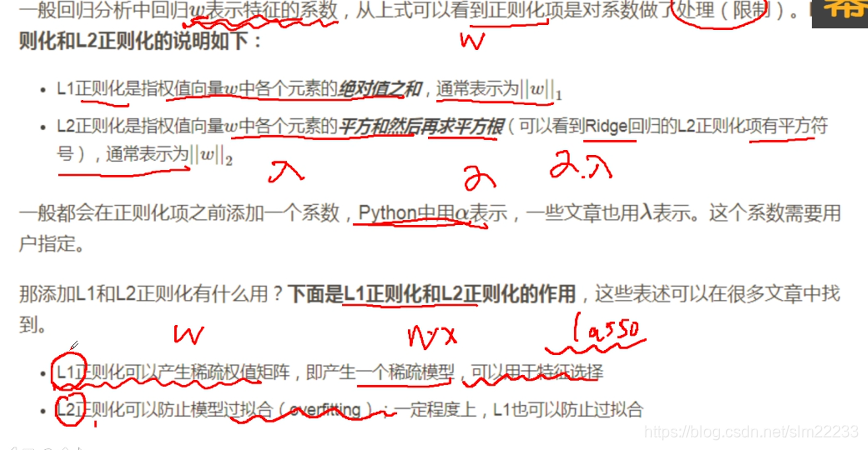

正则化

线性回归中的正则化(目的解决过拟合的现象)

过拟合的原因:1.训练数据过少,2.特征过多,3.模型过于复杂

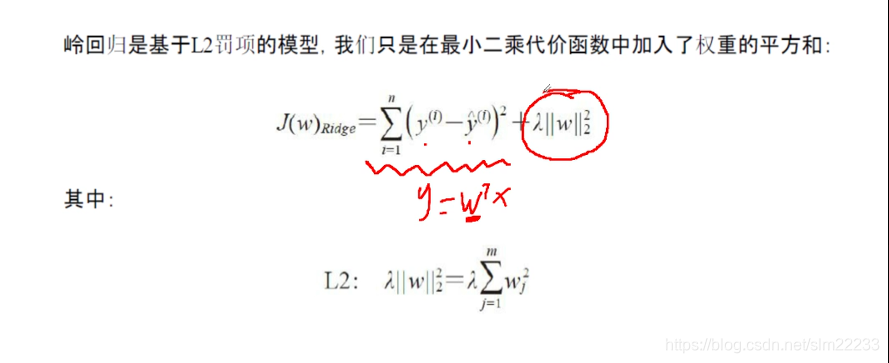

- 岭回归

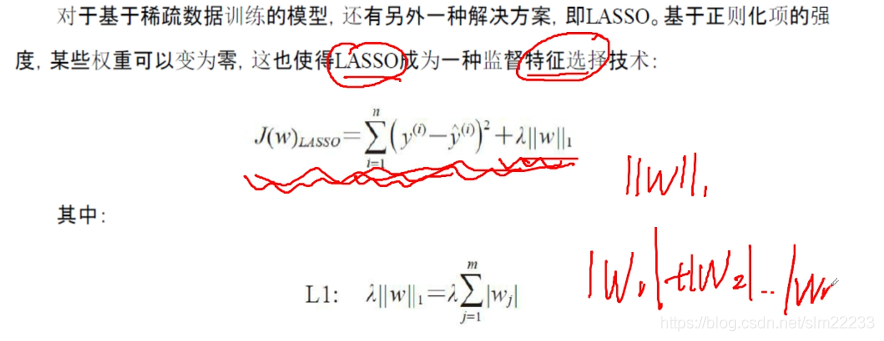

- LASSO回归

- 总结