标题:Frustum PointNets for 3D Object Detection from RGB-D Data

作者:Charles R. Qi, Wei Liu, Chenxia Wu, Hao Su, Leonidas J. Guibas

今天介绍的文章是”Frustum PointNets for 3D Object Detection from RGB-D Data”–用于从RGB-D数据进行3D物体检测的视锥点云网络(翻译成中文感觉怪怪的。。。),文章发表在CVPR2018。

本文将介绍一种3D目标检测的方法–Frustum PointNets,该方法既可以应用于室内场景,也可以进行室外场景的目标检测。该方法融合了2D目标检测和深度学习的方法进行3D目标定位,通过对点云数据的直接处理,在很强的遮挡情况下或者稀疏的点云下,仍然可以非常有效的估计3D边界框。在KITTI和SUN RGB-D 3D detection的数据集上都获得了不错的成绩,并且达到了实时的要求。

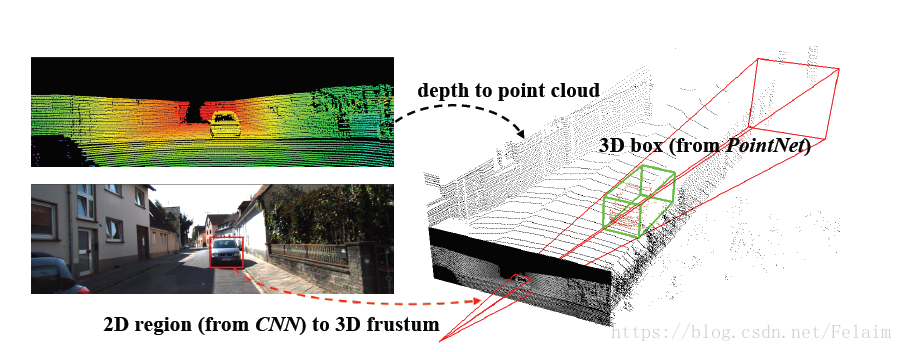

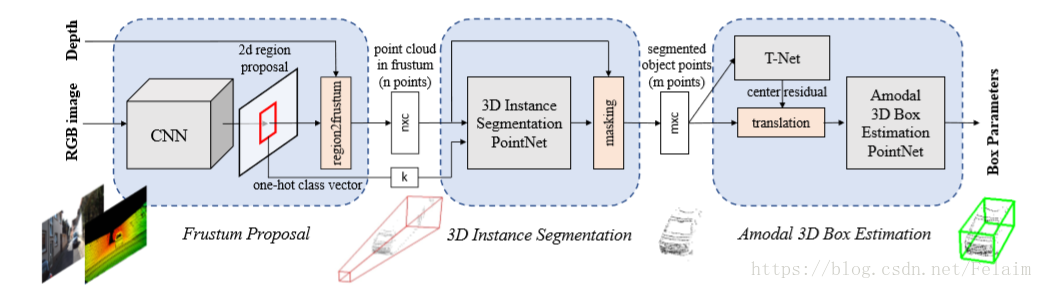

如上图所示,对给定的RGB-D数据,作者首先利用卷积神经网络(CNN)对RGB图像生成region proposals。通过深度数据得到点云,对每个region proposal转换到3D视锥中的点云。最后,由Frustum PointNets在视锥中预测出一个(带有方向和非模态的)检测目标的回归框。

其次,在被每个3D视锥限制的3D空间中,作者连续两次使用变种的PointNet进行3D对象的实例分割和非模态的3D边界框回归。分割网络预测感兴趣对象的3D掩膜(即实例分割),回归网络估计出非模态的3D边界框(很有意思的是如果对象只有部分可见,回归框也能够覆盖整个物体)。

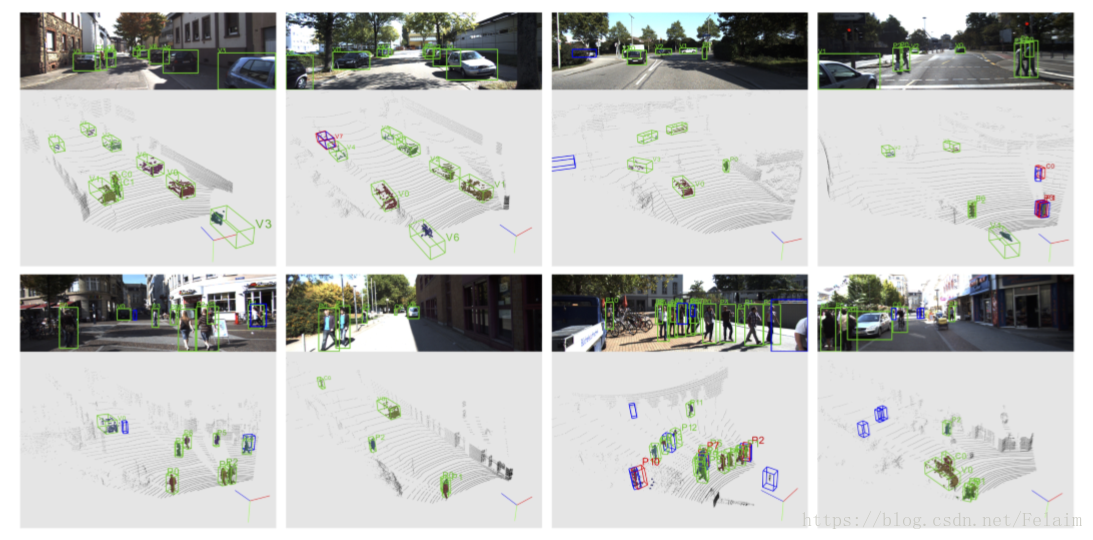

如上图所示,网络结构的可视化输出,其中真阳性检测边界框为绿色,假阳性边界框为红色,真实值为蓝色以显示假阳性和假阴性的例子,每个边界框旁边的数字和字母表示实例id和语义的类别,汽车为’v’,行人为’p’,骑车人为’c’。可以看到3D实例分割和边界框的回归在有挑战的情况下,结果都非常的不错。

第一次这么官话的介绍这个论文,感觉还是怪怪的。这个其实是预备啦,哈哈,后面详细的应该不会像这样。。。未完待续O(∩_∩)O