3.1 线性模型

线性模型

-

f(x)=w1x1+w2x2+...+wdxd+b(3.1)

向量形式

-

f(x)=wTx+b(3.3)

为什么是线性模型呢?

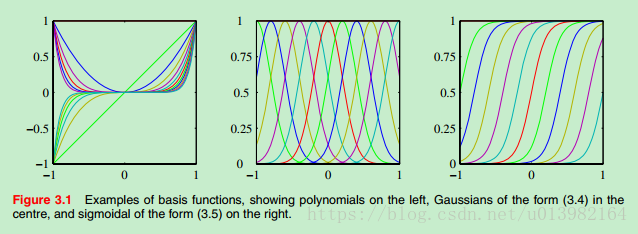

- (补充:PRML 3.1)这里x可以是高阶, 重点是w是线性就行了,如果x也是线性那么会给模型带来局限性,此时可以引入基函数

ϕ(x)

f(x)=wTϕ(x)+b(3.2)

优点

3.2 线性回归

线性回归

-

给定数据集

D={(x1,y1),(x2,y2),...,(x,,ym)},其中

xi可以是多维的,

yi属于实数集.

-

LR试图学一个线性模型去拟合真实值

f(x)=wxi+b 使得

f(xi)≃yi

-

离散属性处理:若有“序”,则连续化;否则,转化为 k 维向量

如何确定参数

-

度量函数:这里选用均方误差

-

E(f;D)=m1i=1∑m(f(xi)−yi)2(3.4)

-

令均方误差最小化,有

-

(w∗,b∗)=argmin(w,b)i=1∑m(f(xi)−yi)2=argmin(w,b)i=1∑m(yi−wxi−b)2(3.5)

-

对

E(w,b)=∑i=1m(yi−wxi−b)2 进行最小二乘参数估计

- 因为3.5式是凸函数,分别对 w 和 b 求导

- 令导数为0,得闭式解

多元线性回归

- 如果用以上参数估计法,涉及矩阵求逆

- 若

XTX 满秩或正定,则

x^∗=(XTX)−1XTy

- 若不满秩,则有多个解,此时需看归纳偏好或引入正则化

线性模型的变化

- 对数线性归回

-

lny=wTx+b(3.6)

- 更一般的,考虑单调可微函数

g(⋅),

g(⋅) 称为联系函数,实质是线性回归后映射到另一个函数空间

-

y=g−1(wTx+b)(3.7)

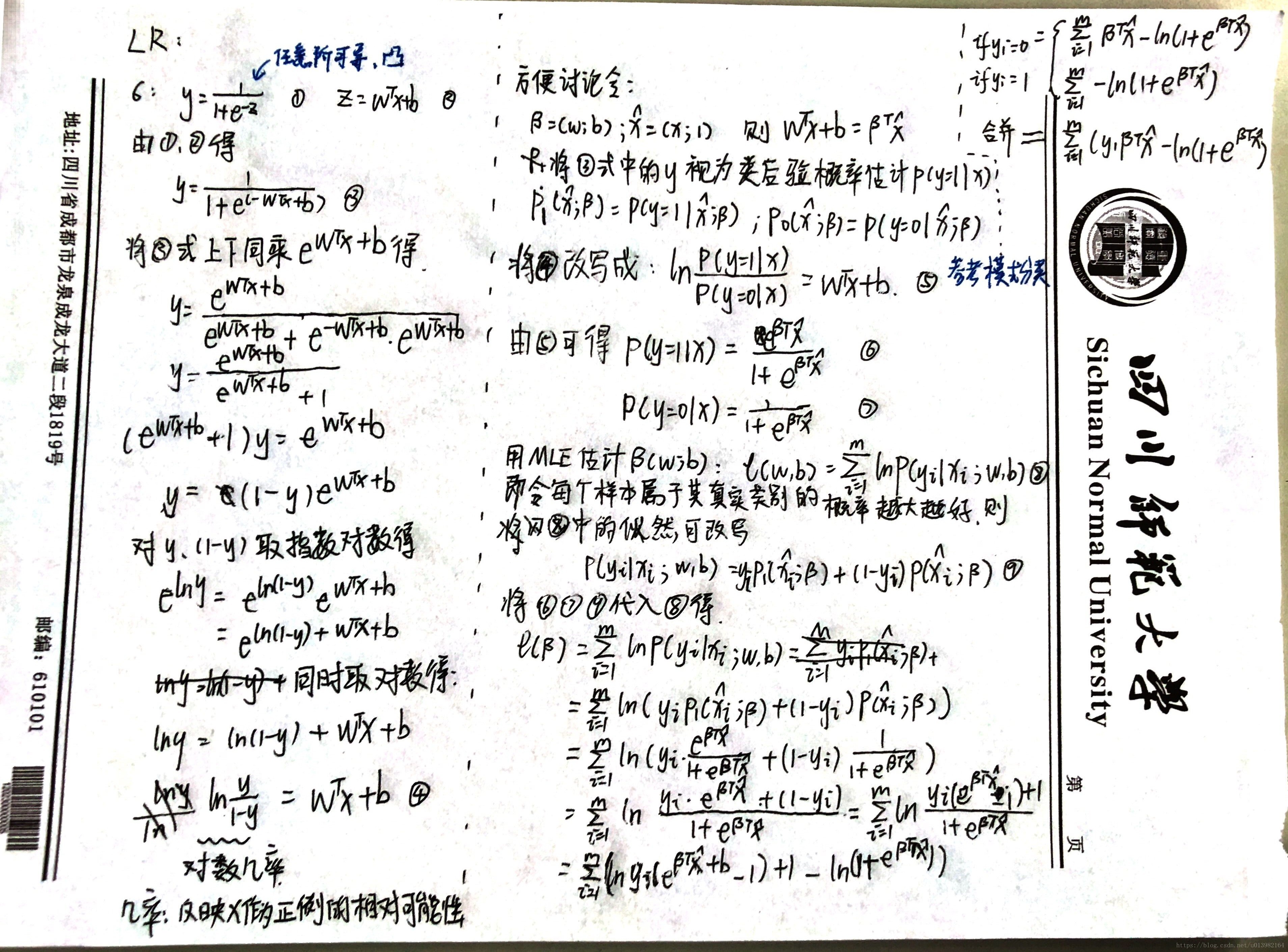

3.3 对数几率回归

极大最后一式等于极小它的负数,因为该式是关于

β高阶可导连续凸函数,所以可以用凸优化理论优化。

总结

线性模型关键是参数是线性的,其中存在两种变化

- 输入可以变换基

- 比如多项式 (

x,x2,x3...xn)

- 这是为了拟合真实数据的变化尺度

- 尺度相当则模型表达会更好

- 输出可以通过联系函数映射到新的空间

- 特别的,当联系函数为 sigmoid function 时,此时的线性回归称为逻辑回归

- 逻辑回归属于判别式模型,采用极大释然进行参数估计,由此引出交叉熵

(后话)参数一多容易过拟合,但参数多能保证模型的表达能力,此时需要引入正则项,可以等于贝叶斯派中引入的先验。

参考

周志华. 机器学习. 3.1/3.2/3.3.

Bishop. Pattern Recognition And Machine Learning. 3.1.

李宏东. 模式分类(译). 2.2贝叶斯决策论.