目录

学习完吴恩达老师机器学习课程的降维,简单的做个笔记。文中部分描述属于个人消化后的理解,仅供参考。

如果这篇文章对你有一点小小的帮助,请给个关注喔~我会非常开心的~

0. 前言

数据的特征数量,又称作向量的维度。降维(dimensionality reduction)是通过一些方法,减少数据的特征数量,以降低维度,通常采用主成分分析PCA(Principal Component Analysis)。降维的作用有:

- 数据压缩,减小占用的存储空间

- 加快算法的计算速度

- 低维平面可以可视化数据

初始作如下定义:

--- 第

个数据的第

个向量

--- 向量

--- 高维向量映射到低维平面后,在高维空间中的位置

--- 高维向量映射到低维平面后,在低维空间中的位置

1. 主成分分析(PCA)

主成分分析PCA是寻找一个低维平面,使得各个数据点到平面的投影距离最小,换句话说,就是寻找 个向量,作为子空间,将数据映射到这个子空间上,则数据的维度转换为

。

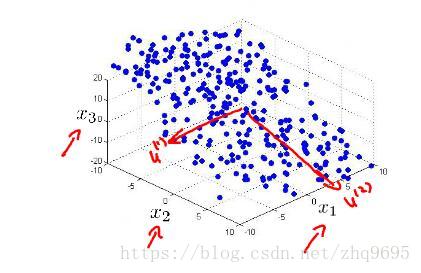

如下图所示(图源:吴恩达机器学习),三维空间的数据几乎可看作分布在一个斜面上,则可在这个斜面上建立一个二维的平面,将数据映射上去,转换为二维空间。

2. 主成分分析PCA的流程

主成分分析PCA的流程主要由两部分组成:

- 数据预处理(均值归一化)

- 计算低维空间向量(计算协方差

奇异值分解

计算低维矩阵

转换为低维数据)

数据预处理主要是进行均值归一化,对每个特征值进行如下变化:

均值归一化可使得特征的均值为 ,其中

为特征缩放(取值范围的最大值减去最小值,使之取值范围接近

)。

计算低维空间向量,首先计算数据的协方差矩阵,采用如下公式,注意 是一个矩阵:

进行奇异值分解,在matlab中,可有如下公式:

其中 是一个

的矩阵,

,取前

列,得到

,为一个

的矩阵,接着:

将每一个向量 转换为

,

为

的向量,达到了降维的目的。

注:最后一步转换的 是没有偏置

的。

3. 低维空间维度的选择

我们已知主成分分析是要寻找一个低维平面,使得各个数据点到这个平面的距离最小,这个距离可采用平均投影误差的平方(average squared projection error)量化,定义如下:

其中, 是在高维空间中映射到低维平面上的近似点(维度仍然是高维,与

不同,

的维度是低维),

。

我们需寻找满足下式的最小的 :

其中,右侧的数值可根据实际情况调整, 为保证了

的方差。

此外,还有一种计算方法,在奇异值分解 中,

,满足下式:

只需求解最小的 ,满足下式即可:

4. 主成分分析使用方式

- 用主成分分析PCA防止过拟合是不适合的,过拟合应该采用正则化

- 在项目中,应首先试着不采用PCA,若达不到预想的想过,则可采用PCA试试看

如果这篇文章对你有一点小小的帮助,请给个关注喔~我会非常开心的~