斯坦福深度学习和自然语言处理CS224N P2 词向量表示word2vec

1.基于最简单的结构构建神经网络

用神经网络完成学习词语表征的简单任务

(1)word meaning(15min)

(2)word2vec introduction(2013,词汇表征)(15min)

(3)research highlight(5min)

(4) word 2 vec objective function gradients (20min)

(5)optimization refresher (10min)

(6)Assignment 1 note (5min)

(7) usefulness of word2vec (5min)

计算机系统处理语言

计算机处理语义的方法:

分类资源(WordNet)

from nltk.corpus import wordnet as wn

panda=wn.synset(‘panda.n.01’)

hyper=lambad s:s.hypernyms()

list(panda.closure(hyper))

语料库是存放语言材料的仓库(数据库),由语言实际使用中出现过的真实语言材料制作而成。语料库分为单语、双语和多语语料库。

WordNet是面向语义的英语词典,与传统辞典类似,但结构更丰富。nltk中包括英语WordNet,共有155287个单词和117659个同义词。

离散表示的问题:

大量的同义词资源,实践中,很难从这些资源中尽可能地获取价值。

(1)分类关系会遗漏大量的细微差别

https://www.cnblogs.com/no-tears-girl/p/6416765.html

(2)wordnet 有很多不完整地地方(impossible to keep up to date)

(3)往同义词中加什么词是非常主观地选择

(4)需要大量人力

(5)很大对词汇地相似性给出准确定义

几乎所有地NLP研究,除了现代深度学习,使用原子符号表示单词。(one-hot representation)没有给出任意词汇之间地相互关系。

符号编码不仅存在于传统地基于规则的理性主义也存在于基于概率统计的传统机器学习模型中。无法得出词汇和模型之间的关联。

探索一种直接的方法,一个单词编码表示的含义是可以直接阅读的,从表示中看出相似性。

分布相似性:通过某种方式用上下文的词表示词的含义。通过单词的同伴知道它的意思。给每个单词构造一个向量。

分布式表示:用密集型向量表示词汇的含义。

分布相似性:关于词汇语义的理论。

Part2 word2vec

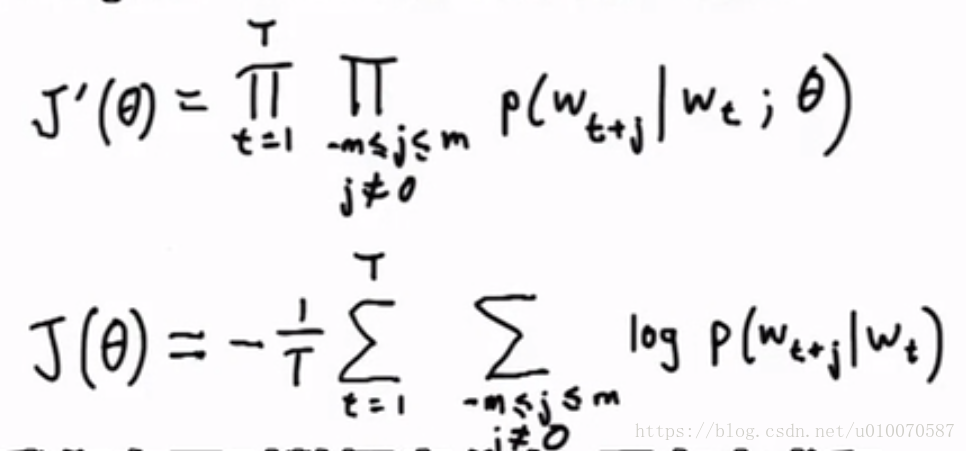

神经网络词嵌入:定义一个模型根据中心词汇预测上下文词汇。

损失函数来判断预测的准性。调整词汇表示,使损失函数最小。

预测目标:每个单词的向量能预测其周围的词汇,反之亦然。

词汇的分布式表示(A neural probabilistic language model),能预测上下文的其他词汇。

找到一种学习单词表示的方法,word2vec:构建一个简单的训练模型,可以处理数十亿的单词文本,并生成非常棒的单词表示。利用语言的意义理论,来预测每个单词和它上下文的词汇。word2vec是一个软件(两个用于生成词汇向量的算法,两套效率中等的训练方法)

skip-gram:对于一个单词,仅且仅有一个概率分布,

参数thta:是词汇的向量表示;

超参数:半径m;

交叉熵

斯坦福深度学习和自然语言处理CS224N P2 词向量表示word2vec

猜你喜欢

转载自blog.csdn.net/u010070587/article/details/82763434

今日推荐

周排行