版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/lishanlu136/article/details/70207623

用Caffe训练卷积神经网络(CNN)是一个学习滤波器(权值)的过程,网络学习结果可通过模型在测试集上的泛化性能作为评判标准,但具体网络学到了什么,具体怎么学习的还不得而知,通过可视化网络每层的特征图及每层的滤波器,可以清楚地了解到整个网络的学习过程,这对于初学者来说可以从直观上理解网络每层的作用,是怎么学习特征的;也对于怎么调整滤波器的大小及个数起到了参考作用。

写一个ShowLayer.py,它能够显示网络每层结构,当输入一张图片时,显示这张图片对应每层的特征图及滤波器,最后并对这张图片预测类别。

所需参数包括:训练时的网络(Net)、训练得到的模型(Model)、均值文件、测试图片一张

#coding=utf-8

#加载必要的库

import numpy as np

import matplotlib.pyplot as plt

#matplotlib inline

import sys,os,caffe

#设置当前目录,判断模型是否训练好

caffe_root = 'D:/caffe_windows/'

sys.path.insert(0, caffe_root + 'python')

os.chdir(caffe_root)

# if not os.path.isfile(caffe_root + 'examples/cifar10/cifar10_quick_iter_4000.caffemodel'):

# print("caffemodel is not exist...")

#利用提前训练好的模型,设置测试网络

caffe.set_mode_cpu() #设置为cpu模式,当然也可以设置为gpu

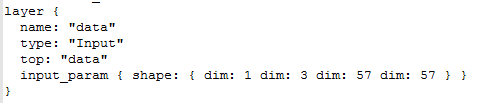

net = caffe.Net(caffe_root + 'examples/CASIA_5fold/Net/AlexNet_deploy.prototxt',

caffe_root + 'examples/CASIA_5fold/1/1234_train/AlexNet/1234_64alexnet_iter_16000.caffemodel',

caffe.TEST)

print net.blobs['data'].data.shape

#加载测试图片,并显示

im = caffe.io.load_image('D:/caffe_windows/examples/CASIA_5fold/1/classification_pic/1_6_084.jpg')

print im.shape

plt.imshow(im)

plt.axis('off')

plt.show()

#编写一个函数,将二进制的均值转换为python的均值

def convert_mean(binMean,npyMean):

blob = caffe.proto.caffe_pb2.BlobProto()

bin_mean = open(binMean, 'rb' ).read()

blob.ParseFromString(bin_mean)

arr = np.array( caffe.io.blobproto_to_array(blob) )

npy_mean = arr[0]

np.save(npyMean, npy_mean )

binMean=caffe_root+'examples/CASIA_5fold/1/1234_64CbsrMean.binaryproto'

npyMean=caffe_root+'examples/CASIA_5fold/1/mean.npy'

convert_mean(binMean,npyMean)

#将图片载入blob中,并减去均值

transformer = caffe.io.Transformer({'data': net.blobs['data'].data.shape})

transformer.set_transpose('data', (2,0,1))

transformer.set_mean('data', np.load(npyMean).mean(1).mean(1)) # 减去均值

transformer.set_raw_scale('data', 255)

transformer.set_channel_swap('data', (2,1,0))

net.blobs['data'].data[...] = transformer.preprocess('data',im)

inputData=net.blobs['data'].data

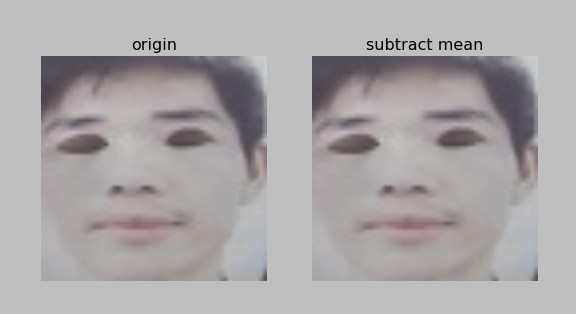

#显示减去均值前后的数据

plt.figure()

plt.subplot(1,2,1),plt.title("origin")

plt.imshow(im)

plt.axis('off')

plt.subplot(1,2,2),plt.title("subtract mean")

plt.imshow(transformer.deprocess('data', inputData[0]))

plt.axis('off')

#运行测试模型,并显示各层数据信息

net.forward()

print 'blobs:'

print [(k, v.data.shape) for k, v in net.blobs.items()]

#显示各层的参数信息

print 'weight:'

print [(k, v[0].data.shape) for k, v in net.params.items()]

# 编写一个函数,用于显示各层数据

def show_data(data, padsize=1, padval=0):

data -= data.min()

data /= data.max()

# force the number of filters to be square

n = int(np.ceil(np.sqrt(data.shape[0])))

padding = ((0, n ** 2 - data.shape[0]), (0, padsize), (0, padsize)) + ((0, 0),) * (data.ndim - 3)

data = np.pad(data, padding, mode='constant', constant_values=(padval, padval))

# tile the filters into an image

data = data.reshape((n, n) + data.shape[1:]).transpose((0, 2, 1, 3) + tuple(range(4, data.ndim + 1)))

data = data.reshape((n * data.shape[1], n * data.shape[3]) + data.shape[4:])

plt.figure()

plt.imshow(data,cmap='gray')

plt.axis('off')

plt.show()

plt.rcParams['figure.figsize'] = (8, 8)

plt.rcParams['image.interpolation'] = 'nearest'

plt.rcParams['image.cmap'] = 'gray'

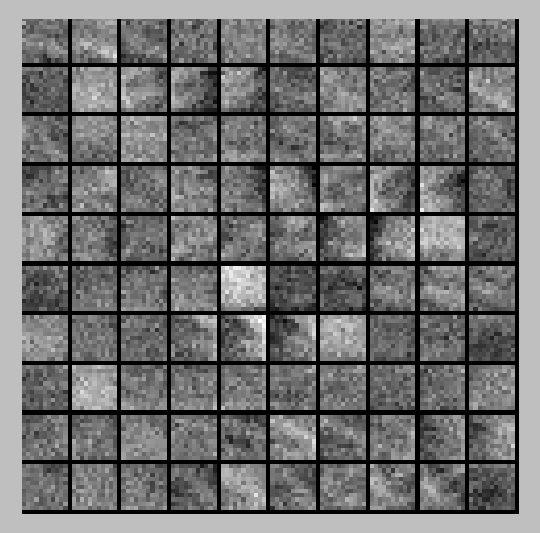

#显示第一个卷积层的输出数据和权值(filter)

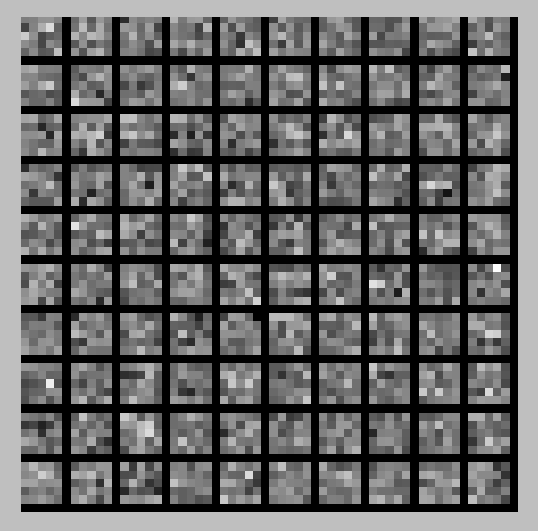

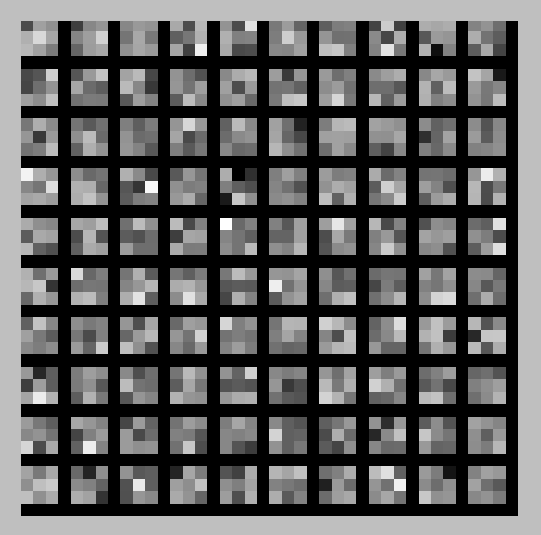

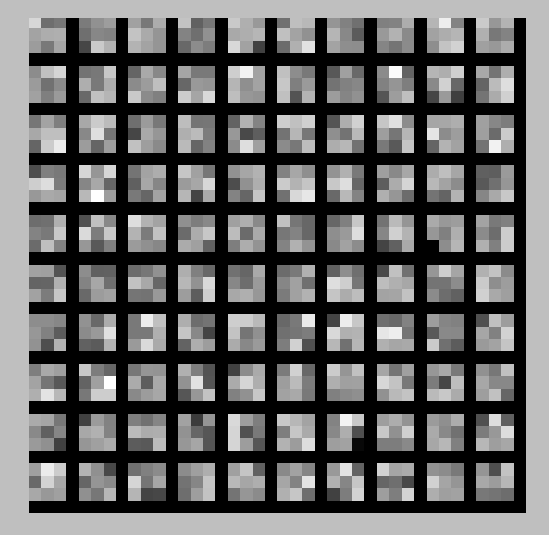

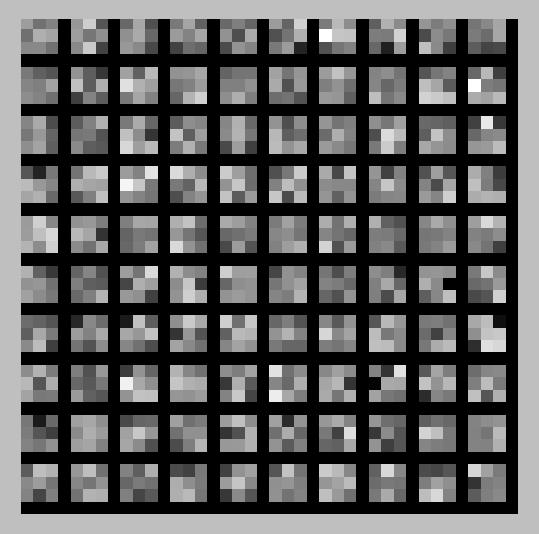

show_data(net.blobs['conv1'].data[0],padval=0.5) #输出96张图片,因为经过conv1后输出96张feature map

print net.blobs['conv1'].data.shape

show_data(net.params['conv1'][0].data.reshape(96*3,11,11)[:100]) #(96,3,11,11),总共96*3个滤波器,显示前100个滤波器,有100张图片

print net.params['conv1'][0].data.shape

#显示第一次pooling后的输出数据

show_data(net.blobs['pool1'].data[0],padval=0.5) #feature map经过一次pooling后依然是96张图片

print net.blobs['pool1'].data.shape

#显示第二次卷积后的输出数据以及相应的权值(filter)

show_data(net.blobs['conv2'].data[0][:100],padval=0.5) #总共有256张图片,显示前100张图片,因为经过conv2后输出256张feature map

print net.blobs['conv2'].data.shape

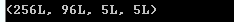

show_data(net.params['conv2'][0].data.reshape(256*96,5,5)[:100]) #(256,96,5,5),显示前100个滤波器,有100张图片

print net.params['conv2'][0].data.shape

#显示第三次卷积后的输出数据以及相应的权值(filter),取前100个进行显示

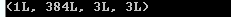

show_data(net.blobs['conv3'].data[0][:100],padval=0.5) #总共384张图片,显示前100张图片,因为经过conv3后输出384张feature map

print net.blobs['conv3'].data.shape

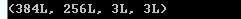

show_data(net.params['conv3'][0].data.reshape(384*256,3,3)[:100]) #(384,256,3,3),显示前100个滤波器,有100张图片

print net.params['conv3'][0].data.shape

#显示第四次卷积后的输出数据以及相应的权值(filter),取前100个进行显示

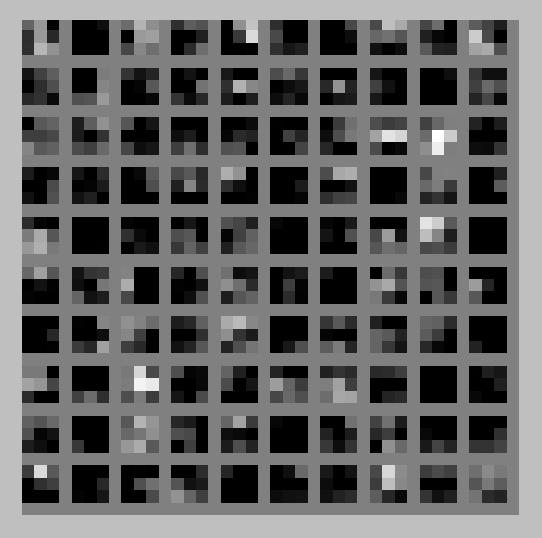

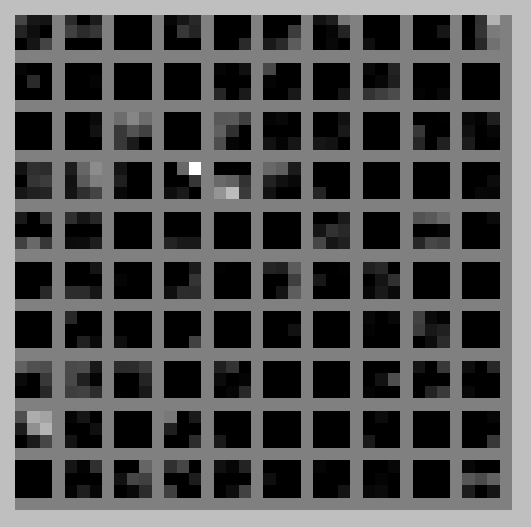

show_data(net.blobs['conv4'].data[0][:100],padval=0.5) #总共384张图片,显示前100张图片,因为经过conv4后输出384张feature map

print net.blobs['conv4'].data.shape

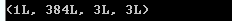

show_data(net.params['conv4'][0].data.reshape(384*384,3,3)[:100]) #(384,384,3,3),显示前100个滤波器,有100张图片

print net.params['conv4'][0].data.shape

#显示第五次卷积后的输出数据以及相应的权值(filter),取前100个进行显示

show_data(net.blobs['conv5'].data[0][:100],padval=0.5) #总共256张图片,显示前100张图片,因为经过conv5后输出256张feature map

print net.blobs['conv5'].data.shape

show_data(net.params['conv5'][0].data.reshape(256*384,3,3)[:100]) #(256,384,3,3),显示前100个滤波器,有100张图片

print net.params['conv5'][0].data.shape

#显示第五次池化后的输出数据

show_data(net.blobs['pool5'].data[0],padval=0.2) #经过conv5后输出256张feature map经过一次pooling后依然是256张图片

print net.blobs['pool5'].data.shape

# 最后一层输入属于某个类的概率

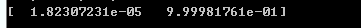

feat = net.blobs['prob'].data[0]

print feat

plt.plot(feat.flat)

plt.show()所以输入的测试图像大小也应为57*57。

程序执行结果如下: