朴素贝叶斯方法是基于贝叶斯定理与特征条件独立假设的分类方法。

贝叶斯定理:条件概率推理,利用条件概率来对一些事情进行推断。

特征条件独立假设:用于分类的特征在类确定的情况下都是条件独立的。

1. 贝叶斯分类基本原理:

对于给定集合{X,Y},首先求取类别Y的分布概率

再求取条件概率分布:

由此,求得了先验概率

2. 基本方法:

假设给定训练数据集:

其中x,y独立同分布。其中类别标签中有K个类别,

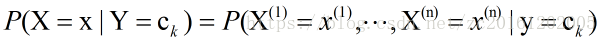

,条件概率计算方式为:

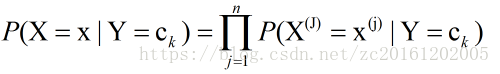

再根据前面的特征条件独立的强假设,上式可以变成:

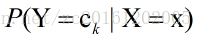

使用朴素贝叶斯分类时,对于输入数据x,通过学习到的模型,计算出后验概率分布:

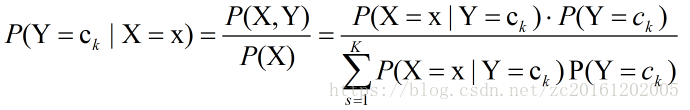

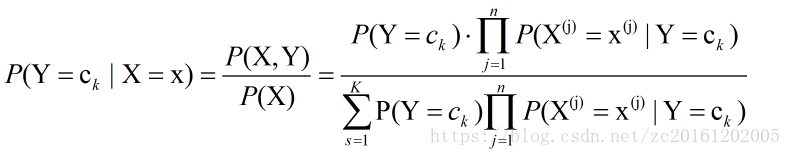

其公式表达式为:

再将公式(1.4)引入,可以获得新的后验概率表达式为:

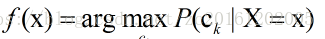

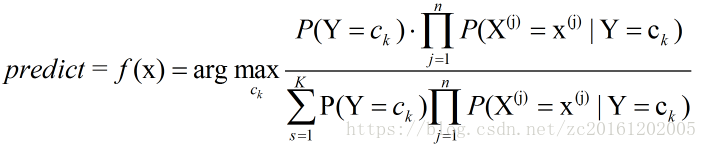

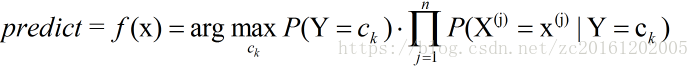

则贝叶斯模型分类器模型表达式可以表示为:

由于(1.7)中每次的

3. 后验概率最大化:

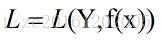

朴素贝叶斯算法将实例分到后验概率最大的类。这等价于期望风险最小化。假设损失函数为:

L(Y,f(X))={1,Y≠f(X)0,Y=f(X)

上式中的

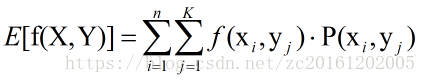

此期望是对联合分布

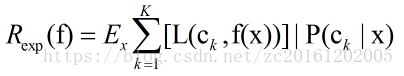

而Y由

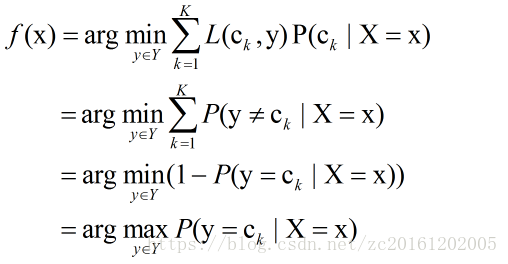

为了使期望风险最小化,只需对

通过以上推导,根据期望风险最小化得到了后验概率最大化:

这就是朴素贝叶斯算法所使用的原理。