1、概述

上一节介绍了BP,这一节就简单介绍一下BPTT。

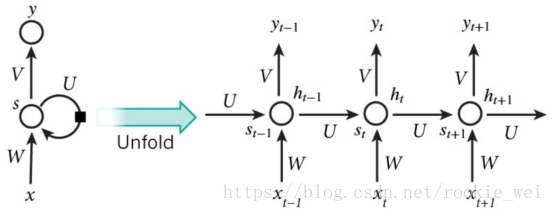

2、网络结构

RNN正向传播可以用上图表示,这里忽略偏置。

上图中,

x(1:T)表示输入序列,

y(1:T)表示输出序列,

Y(1:T)表示标签序列,

ht表示隐含层输出,

st表示隐含层输入,

zt表示经过激活函数之前的输出层输出。

3、前向传播

忽略偏置的前向传播过程如下:

st=Uht-1+Wxt

ht=f(st)

zt=Vht

yt=f(zt)

其中,f是激活函数。U、W、V三个权重在时间维度上是共享的。

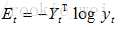

每个时刻都有输出,所以每个时刻都有损失,记t时刻的损失为Et,那么对于样本x(1:T)来说,

总损失

3、反向传播BPTT

跟BP类似,想求哪个权值对整体误差的影响就用误差对其求偏导。

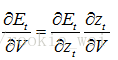

3.1、E对V的梯度

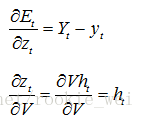

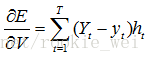

根据链式法则有,

其中,

所以,

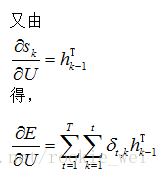

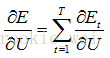

3.2、E对U的梯度

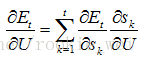

这个是BPTT与BP之所以不同的地方,因为不止t时刻隐含层与U有关,之前所有的隐含层都跟U有关。所以有,

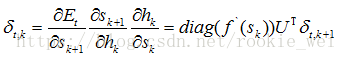

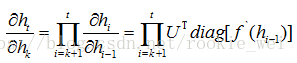

其中,

假设

则

3、梯度爆炸和梯度消失

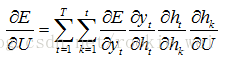

用链式法则求损失E对U的梯度为,

其中,

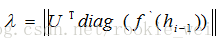

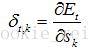

定义

则