目录

理论知识

1.1多层感知器

1.2梯度下降法

1.3 学习速率-超参数(手工可配置)

不合适的学习速率

局部极值点

1.4 反向传播算法

1.5 优化函数

- SGD 随机梯度

- adam优化器

常见参数

RMSprop

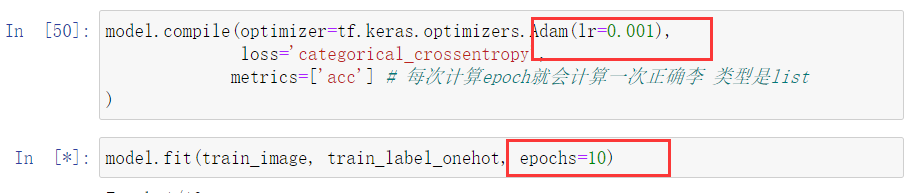

代码实现

1.6 网络优化与超参数的选择

1.6.1 如何选择超参数

那么如何提高网络的拟合能力

注意:

单层的神经元个数,不能太小,太小的话,会造成信息瓶颈,使得模型欠拟合

13W个可训练参数

结果提高了

从正确率来看

- 欠拟合:测试和训练数据分都低

- 过拟合:在测试数据上得分比较低,在训练数据分比较

采用dropout防止过拟合

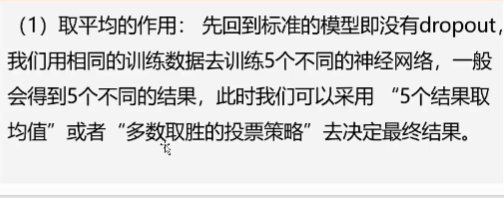

随机森林和集成方法

AlexNet论文中提到

为什么说Dropout可以解决过拟合?

参数选择

因此我们参数训练原则

然后,抑制过拟合---容量上没问题

抑制过拟合 最好的办法是增加训练数据

调整参数-经验

构建网络总原则

总原则:保证神经网络容量足够拟合数据

一、增大网络容量,直到过拟合

二、采取措施抑制过拟合

三、继续增大网路容量,直到过拟合

1.7 实战

如何在网络中添加droupout层

减少网络规模也是一种方法