1 信息量

信息量即信息多少的度量。跟我们认识中秒是时间多少的度量,米是长度多少的量度是一样的意思。

百度百科上定义秒:铯133原子基态的两个超精细能阶之间跃迁时所辐射的电磁波的周期的9,192,631,770倍 的时间 。

那信息的多少怎么衡量呢?一个人告诉你一件事,比如太阳从东方升起;你说这是常识啊,大家都知道。一个人告诉你,明天某个时间在某个地方待着,将有一个亿支票掉下来,这个事情概率比较低,信息量非常大,知道了这个事情价值非常大。感性上我们可以理解信息量为给我带来价值的多少(给你带来多少价值,对等的就是要付出多少代价,似乎有点绕)。实质工程中,信息量的引入是与信息的传输和存储相关的。举个例子:

世界杯比赛,假如最后剩下巴西,法国,比利时,英格兰,巴西得冠军的概率1/2,法国得冠军的概率1/4,比利时得冠军的概率1/8,英格兰冠军概率1/8(非球迷,错了勿怪)。我们要设计协议,传输某个队伍得了冠军的信息。如何设计呢?有人说简单,用两个比特:

00:巴西队得冠军

01:法国队得冠军

10:比利时得冠军

11:英格兰得冠军

但是这样设计合理吗?无论哪个队得冠军,我们都得传输2个比特。我们前面知道了各个队得冠军的概率,如果这样设计

1:巴西队得冠军

0:法国队得冠军

01:比利时得冠军

11:英格兰得冠军

因为巴西队和法国队得冠军的概率比较大,大概率我们只需传输一个比特就行了。基于这样的设计,概率越小我们需要传输的比特位越多。如果以比特位的多少来衡量信息量的多少,也就是概率越低信息量越大。

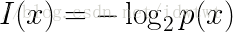

基于此,给出信息量的一个量化公式:

即如果信源的概率越大,该信源携带的信息量越小(传输存储代价越小);信源概率越小,该信源携带的信息越大(传输存储代价越大)。

2 信息熵

我们直接给出公式定义:

从公式中我们可以知道信息熵其实是系统(信源系统)信息量的期望。但是这个期望代表了一个系统的不确定性,信息熵越大,不确定性越大。如何理解呢?我们基于信息传输代价来理解,其实就是如果信源产生一个信息,我们要传输这个信息需要花费代价的最小平均比特位数。