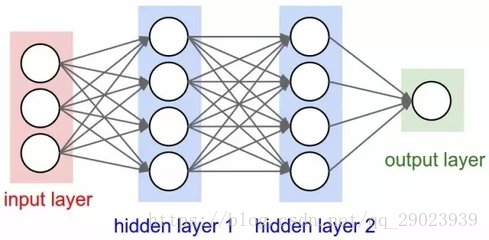

下图为四层神经网络,它包括输入层,输出层,两个隐层

假设输入层到第一个隐层的权值为

代价函数我们使用常用的方差函数:

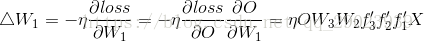

我们知道利用梯度下降法更新权值的公式为:

现在我们想更新

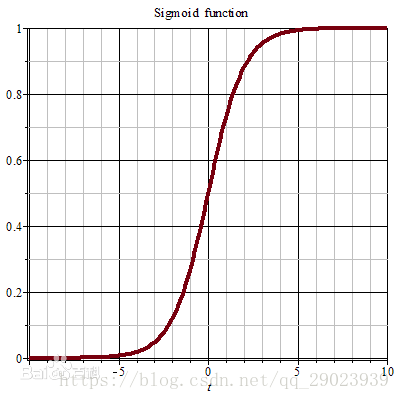

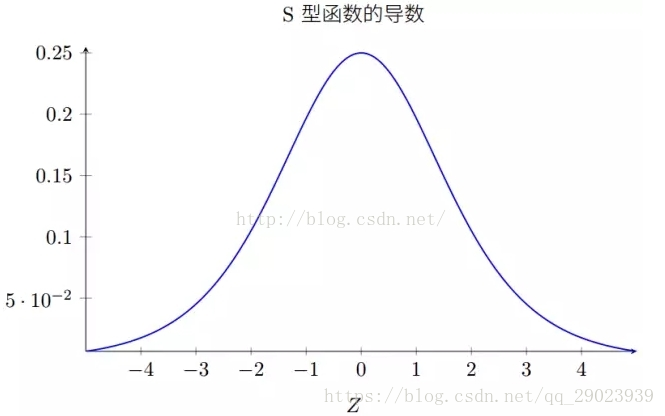

假设我们的激活函数为sigmoid函数,他的表达式和导函数为:

扫描二维码关注公众号,回复:

2211958 查看本文章

函数图像,和导函数图像为:

可知他的导函数最大值为0.25<1,我们的例子是四层神经网络,如果是很多层呢,那么多小于1的数连乘,很可能导致梯度消失。