本来笔者已经决心不玩 RNN 了,但是在上个星期思考时忽然意识到 RNN 实际上对应了 ODE(常微分方程)的数值解法,这为我一直以来想做的事情——用深度学习来解决一些纯数学问题——提供了思路。事实上这是一个颇为有趣和有用的结果,遂介绍一翻。顺便地,本文也涉及到了自己动手编写 RNN 的内容,所以本文也可以作为编写自定义的 RNN 层的一个简单教程。

注:本文并非前段时间的热点“神经 ODE [1]”的介绍(但有一定的联系)。

RNN基本

什么是RNN?

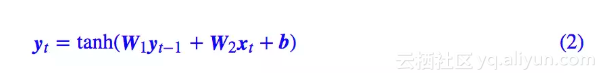

众所周知,RNN 是“循环神经网络(Recurrent Neural Network)”,跟 CNN 不同,RNN 可以说是一类模型的总称,而并非单个模型。简单来讲,只要是输入向量序列 (x1,x2,…,xT),输出另外一个向量序列 (y1,y2,…,yT),并且满足如下递归关系的模型,都可以称为 RNN。

也正因为如此,原始的朴素 RNN,还有改进的如 GRU、LSTM、SRU 等模型,我们都称为 RNN,因为它们都可以作为上式的一个特例。还有一些看上去与 RNN 没关的内容,比如前不久介绍的 CRF 的分母的计算,实际上也是一个简单的 RNN。

说白了,RNN 其实就是递归计算。

自己编写RNN

这里我们先介绍如何用 Keras 简单快捷地编写自定义的 RNN。

事实上,不管在 Keras 还是纯 tensorflow 中,要自定义自己的 RNN 都不算复杂。在 Keras 中,只要写出每一步的递归函数;而在 tensorflow 中,则稍微复杂一点,需要将每一步的递归函数封装为一个 RNNCell 类。

下面介绍用 Keras 实现最基本的一个 RNN:

代码非常简单: