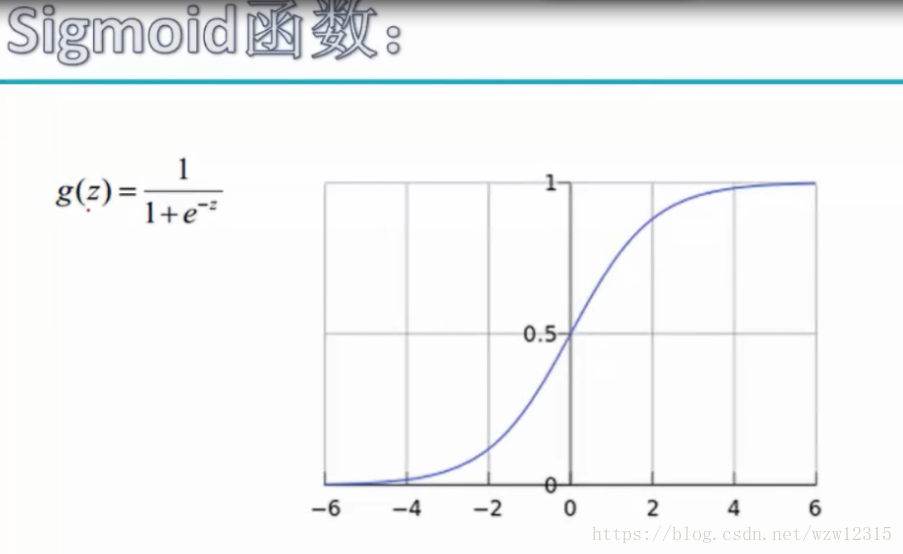

sigmoid二分类函数:将得分结果转换为概率进行分类。输入x属于任意实数值,输出范围是0到1.

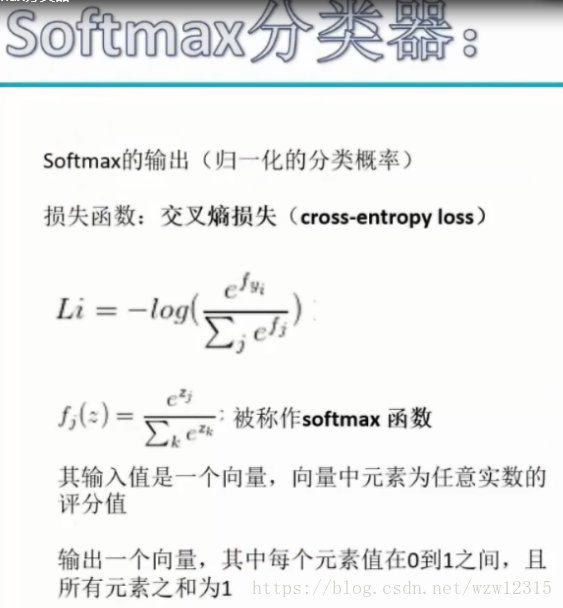

softmax归一化多分类函数,输入是向量,输出也是向量,每个元素值在0和1之间,且各个元素之和为1。

幂函数:如果输入的数大,则映射输出更大;如果输入的数小(负数),则映射输出更小。

损失函数:

损失函数代表预测值与理想值之间的差值,这个差值越小 ,代表预测值越接近理想值,间接说明我们的网络模型的权重参数比较合理。那么,在实践中如何使得损失函数越来越小呢?方案有很多种,但是不同的方案所需要的时间或者说难易程度都是不一样的。根据经济效益,自然是选择时间短,难度小的优化方案。经过比较,梯度下降法是一个不错的方案。

如下图所示,我们最终是希望到达最低山脚处。那你在山顶自然是往下走啦,但是这时候的斜面的斜率(梯度)是向左的,我们是要向右的,所以是逆着梯度的方向走,才能到达最低山脚处。