文章列表

1.TensorFlow入门深度学习–01.基础知识. .

2.TensorFlow入门深度学习–02.基础知识. .

3.TensorFlow入门深度学习–03.softmax-regression实现MNIST数据分类. .

4.TensorFlow入门深度学习–04.自编码器(对添加高斯白噪声后的MNIST图像去噪).

5.TensorFlow入门深度学习–05.多层感知器实现MNIST数据分类.

6.TensorFlow入门深度学习–06.可视化工具TensorBoard.

7.TensorFlow入门深度学习–07.卷积神经网络概述.

8.TensorFlow入门深度学习–08.AlexNet(对MNIST数据分类).

9.TensorFlow入门深度学习–09.tf.contrib.slim用法详解.

10.TensorFlow入门深度学习–10.VGGNets16(slim实现).

11.TensorFlow入门深度学习–11.GoogLeNet(Inception V3 slim实现).

…

TensorFlow入门深度学习–07.卷积神经网络概述

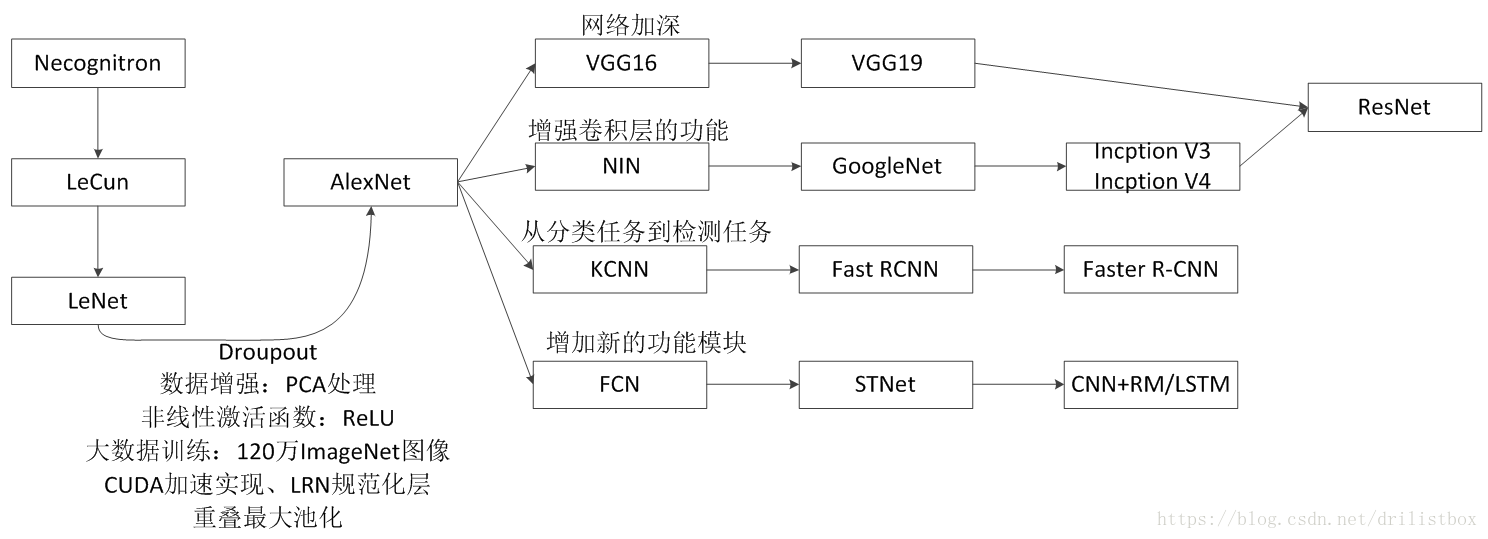

卷积神经网络设计的初衷是解决图像识别问题,但现在不仅仅应用于图像及视频,也可用于时间序列问题,不如音频文本等。卷积结构最早出现于神经认知机(neocognitron)模型中,但第一个卷积神经网络LeCun诞生于1989年,随后,其作者LeCun于1998年提出LeNet,但在当时的条件下SVM的理论可解释性以及效果都比神经网络要好。随着神经网络的改进,ReLU、Dropout、重叠最大池化、LRN层、数据增强等新技术的提出,同时还有CUDA及大量数据的出现,卷积神经网络在2012年迎来了新的突破-AlexNet。AlexNet出现之后,卷积神经网络的演化过程主要有4个方向:1网络加深;2增强卷积功能;3从分类任务到检测任务4增加新的功能模块。

1. 网络加深有利于高阶特征的提取。VGGNet可以看成AlexNet在网络深度加深上的扩展。VGGNet指出,通过多个更小卷积核的连续卷积,可以获得与大卷积核卷积同样的视野,并且具有更少的参数以及更多的非线性变换次数。VGGNet通过反复堆叠3*3的卷积核以及2*2的最大池化实现了11-19层深的神经网络。

2. 扩展卷积层的功能。NIN中将单维度的卷积核扩展成了多个维度的卷积核,使得模型可以通过自身学习选择最合适的卷积核,从而用多个密集成分的组合来近似最优的局部稀疏结构。InceptionV1模型采用了9个串联的Inception模型,并仿照NIN用全局平均池化代替全连接层,此外,还在中间层添加输出信号,对分类结果进行了融合,也给网络添加了反向传播的梯度信号。Inception V2在Inception V1的基础上提出用多层具有小的卷积核的卷积层代替单层具有大的卷积核的卷积层,并利用了Batch Normalization来提升学习速度。InceptionV3在Inception V2的基础上,将二维卷积核按行和列拆分成两个意味卷积核。

3/4. 3和4我还没有学习到,以后学会了再写。

其中4种常见的经典卷积神经网络分别是AlexNet、VGGNet、Google Inception Net和ResNet,它们分别获得了ILSVRC比赛分类项目的2012年冠军(top5错误率16.4%,使用额外数据可达到15.3%,8层神经网络)、2014年亚军(top5错误率7.3%,19层神经网络)、2014年冠军(top5错误率6.7%,22层神经网络)和2015年冠军(top5错误率3.57%,152层神经网络),这4个经典的网络都在各自的年代率先使用了很多先进的卷积神经网络,对卷积网络乃至深度学习有非常大的推动,ILSVRC的top-5错误率在最近几年取得重大突破,主要的突破点都是在深度学习和卷积神经网络,成绩的大幅提升几乎都伴随着卷积神经网络的层数加深。而传统机器学习算法目前在ILSVRC上已经难以嘴上深度学习的步伐了,以致逐渐被称为浅层学习(shallow Learning)。