机器学习中的线性代数之矩阵求导_Vinicier的博客-CSDN博客_矩阵求导

主要参考了上述博文,不过越看越懵,有没有大佬帮我答疑解惑一些,非常感激~

在矩阵求导中有两种布局,分别为分母布局(denominator layout)和分子布局(numerator layout)

分子布局,就是分子是列向量形式,分母是行向量形式,分子的行决定结果的行,分母的列决定结果的列。

分母布局,就是分子是行向量形式,分母是列向量形式,分母的行决定结果的行,分子的列决定结果的列。

问题:什么时候用分子布局?什么时候用分母布局?

矛盾:标量对向量的求导在理论和计算中存在矛盾

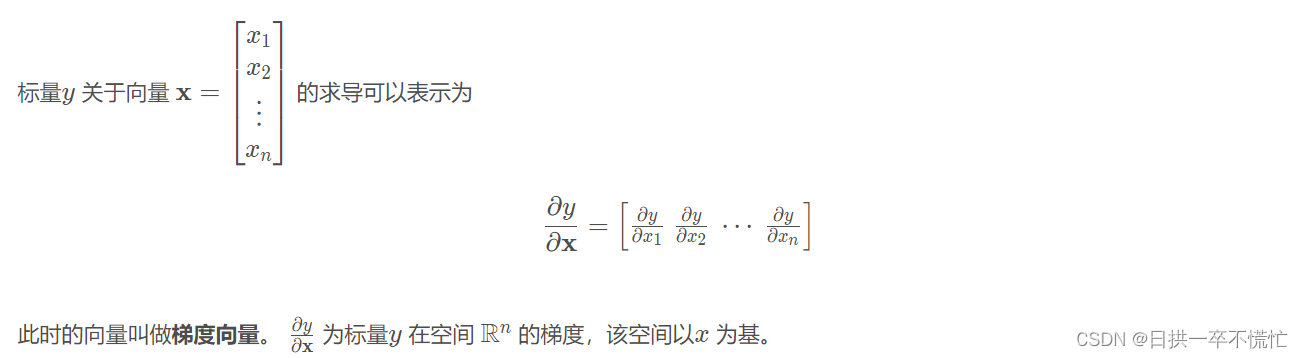

理论1:标量关于向量中的每个元素求导后,结果按列排布

扫描二维码关注公众号,回复:

17274134 查看本文章

计算1:实际计算分析中,标量关于向量中的元素求导后,结果按行排布。

理论2:理论规定计算中是以分子布局确定结果

计算2:将标量推广到向量关于向量的导数,具体计算分析是按照分母布局的形式

应用:pytorch中的自动求导

Pytorch中的自动求导函数backward()所需参数含义 - 不愿透漏姓名的王建森 - 博客园 (cnblogs.com)

推荐上述参考文献

个人理解:

out.backward()

代表的含义是结果关于各层的的后向求导结果

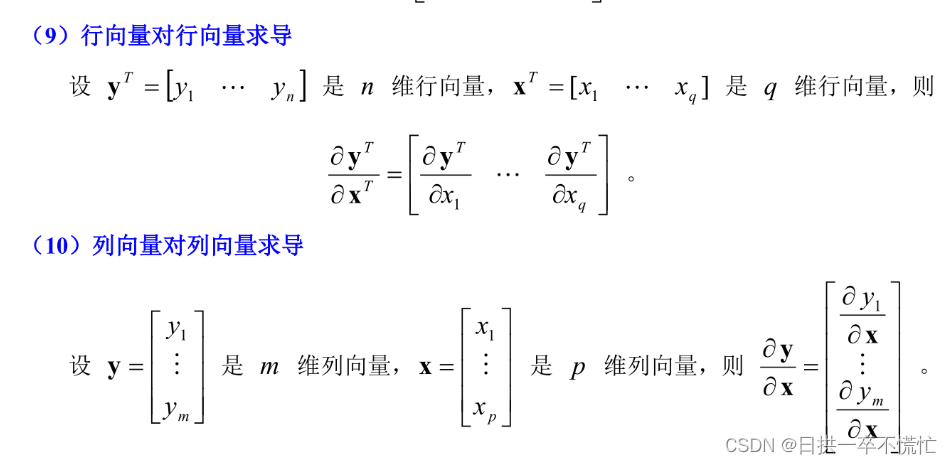

向量对向量的求导

参考文献:

向量,标量对向量求导数_心雨心辰的博客-CSDN博客_标量对向量求导

(1条消息) 矩阵和向量的求导法则_Icoding_F2014的博客-CSDN博客_矩阵对向量求导