Node Embedding over Temporal Graphs

Abstract

作者提出了一种在时间图中嵌入节点的方法。学习时间图的节点和边随时间的演变,并将这种动态整合到时间节点嵌入框架中,用于不同的图预测任务。作者也提出了一个联合损失函数,它通过学习组合节点的历史时间嵌入来创建节点的时间嵌入,这样它就可以优化每个给定的任务(例如,链接预测)。

该算法使用静态节点嵌入初始化,然后在不同时间点对节点的表示进行对齐,并最终适应联合优化中的给定任务。

1.Introduction

在这项工作中,作者扩展了基于先验嵌入的方法,以包括网络的时间行为。直观地说,如果node2vec模仿词嵌入作为节点嵌入的表示,我们提出了一种算法,模仿句子嵌入作为节点的扩展表示。

作者优化了两个目标函数:

(1)在d维特征空间中保持节点的静态网络邻域;

(2)保持网络动态。

然后提出了一个优化函数来共同学习(1)和(2)

首先,作者通过利用静态图的嵌入来实现(1),然后通过联合学习如何合并节点的历史时间嵌入,通过创建一个节点的最终嵌入来实现(2),从而优化给定的任务

实验中,作者给出了两种类型的预测的结果: (1)时间链路预测 (2)多标签节点分类

2.Related Work

3.Feature Learning Framework

设G=(V, E)是一个图,其中每个时间边(u, v)t ∈E在t时刻从一个节点u指向一个节点v。作者定义了一个时间图,Gt =(Vt, Et),它被定义为在时间t之前出现的所有边的图。我们用一组图快照,Gt1,...,GtT,在不同的时间步长,在T个时间步长定义Gt随时间的演化,t1<…<tT。

在这项工作中,作者提出了一种算法,该算法学习端到端架构中时间图的节点和边在不同的预测任务。目标是在T时刻为每个节点v∈V找到一个特征向量fT (v),使任何给定预测任务的损失最小化。

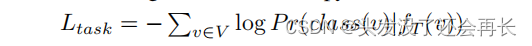

对于节点分类任务,作者使用交叉熵损失:

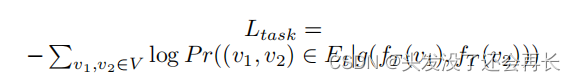

对于链路预测任务,作者使用二元分类损失:

在这个算法中,g是拼接函数

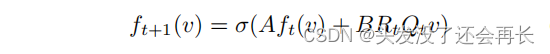

作者希望利用图形快照集,G1,……,GT来学习一个函数FT,s.t.: fT (v) = FT(v,G1,…,GT),对Ltass最优化。为了学习节点动力学,在t + 1中将节点v嵌入到递归表示中:

A、B、Rt和Qt是在训练过程中学习到的矩阵,v是一个代表一个节点的单热向量,σ是一个激活函数,Qt解释为特定时间t内的静态节点表示矩阵。

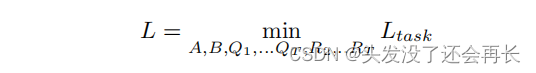

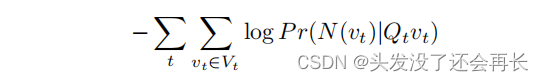

将最终的时间嵌入学习问题表示为一个最小化以下损失函数的优化问题:

然后使用定义嵌入的模型参数fT的Adam优化这个方程,即ABQ1……QT,r2,…。RT .

作者考虑了Qt的几种初始化机制。具体来说,我们通过在t时刻从相应的图Gt中采样相邻节点来学习所有节点的表示,同时最小化以下损失函数:

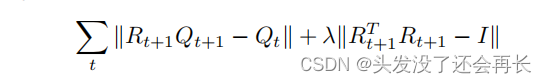

还要求通过强制执行Rt作为一个旋转矩阵来保持静态嵌入的连续时间步长之间的对齐。因此,Rt最小化:

这个端到端过程使我们能够学习如何将节点的历史时间嵌入组合到最终的嵌入中,这样它就可以优化给定的任务。

3.1 Initialization using Static Node Embeddings

在本节中,作者阐述了Qt的初始化过程。

由于node2vec的可伸缩性及其网络保存特性,作者使用它来初始化Qt。

3.2 Temporal Node Embedding Alignment

在本节中,我们将详细阐述了旋转矩阵Rt的优化问题。

无论是node2vec还是图在不同时间点的相同图嵌入,都无法保证嵌入的图节点的坐标轴对齐。

我们的目标是“平滑”来自不同嵌入训练课程的两个不同时间步长ti和tj之间的变化。

假设大多数节点在ti和tj之间没有太大的变化(例如,j=i+ε),我们在ti时刻的节点嵌入和tj时刻的节点嵌入之间进行正交变换。

应用于我们的问题,设Qt∈Rd×|V|为时间步长t时的节点嵌入矩阵。我们迭代地对齐连续时间步长对应的矩阵,即对齐Qt2到Qt1,然后对齐Qt3到Qt2,以此类推。

对齐需要找到Qt和Qt+1之间的正交矩阵R。时间Qt的最终嵌入数现在是Qt = RQt。通过优化以下回归问题来实现近似:

其中Rt+1∈Rd×d是两个连续时间步长之间的最佳正交变换对齐。

3.3 Node Embedding over Time

在本节中,作者详细阐述了A、B和σ的选择以及最终的联合优化。

在句子分类任务中,每个句子嵌入一个大小为d的向量,然后将向量输入分类器。

在优化的最后一步,我们的目标是为每个节点创建一个单一的d维表示,利用它的T历史嵌入,X (v)。为了将序列数据简化为d维向量,作者使用了具有长短期记忆(LSTM)的递归神经网络(RNNs)。

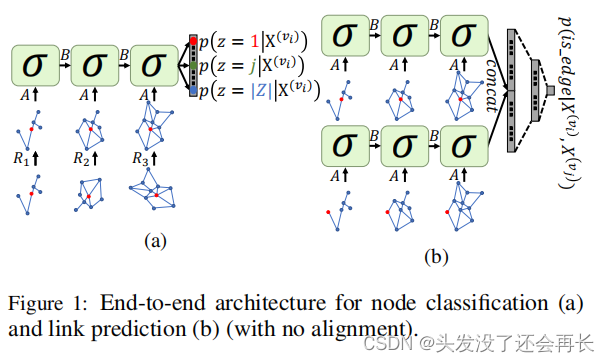

作者将tNodeEmbed定义为使用静态节点嵌入和对齐进行初始化的架构,并针对给定的任务进行了优化。图1a说明了多标签节点分类任务的过程。时间t嵌入的每个节点,对齐后,作为输入输入一个大小为d的LSTM内存单元。LSTM的最后一个记忆单元hT∈Rd表示节点vt的最终时间嵌入,对特定任务进行优化。对于链路预测任务(图1b),每条边的e =(v1,v2)由(v1 t,vt 2)表示——一个大小为2d的向量,它是它所连接的两个节点的连接。然后将此边表示输入大小为d的全连接(FC)层,然后是一个softmax层。

4.Experimental Setup

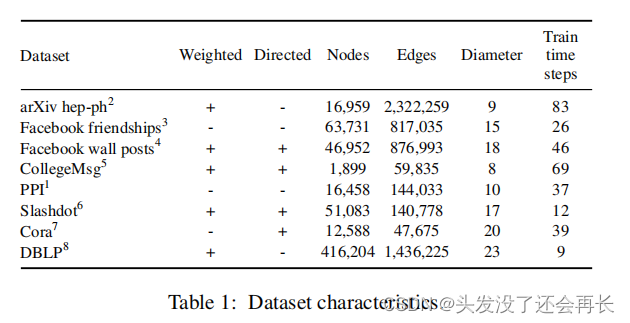

4.1 Datasets

5.Experimental Results

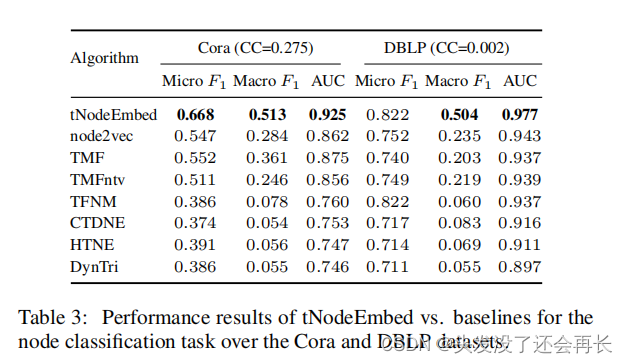

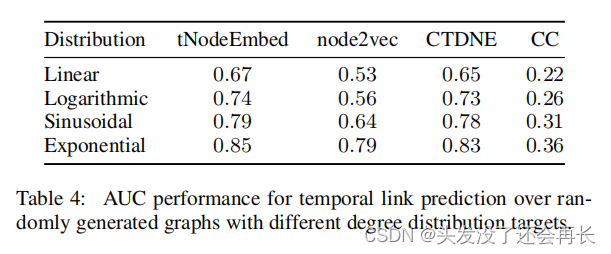

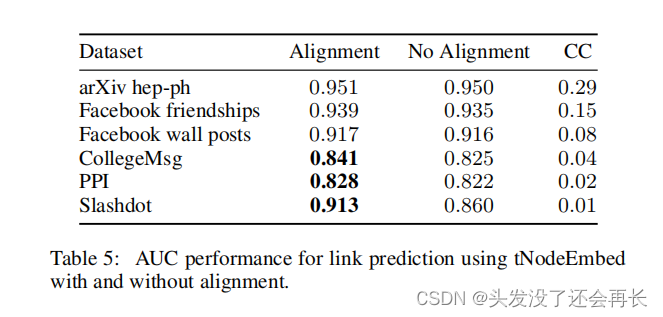

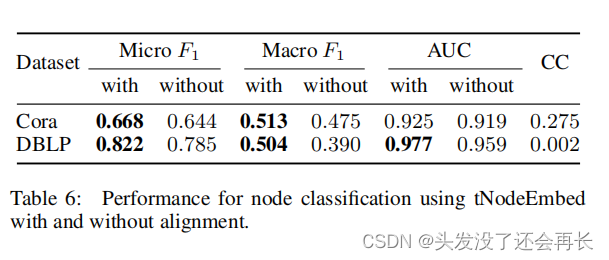

评估的主要部分包括对tNodeEmbed与上一节中描述的链接预测和节点分类任务的所有基线的详细比较,然后,进一步研究了四种具有不同程度分布的随机图的链接预测任务的性能。最后,分析了对齐步骤对两个任务性能的影响。在本节中,粗体显示的结果显示了统计学上的显著差异。

6.Conclusion

在本文中,作者探索了时间图的嵌入。与之前的时间图预测方面的工作不同,它专注于优化一个特定的任务,我们提出了一个框架,允许联合优化节点表示和特定于任务的目标。

该方法将图嵌入推广到捕获图动态,有点类似于在自然语言处理中将单词嵌入扩展到顺序句子嵌入。该框架可以利用任何静态图嵌入技术,并学习一个时间节点嵌入来改变它。