1 Seq2Seq

1.1 介绍

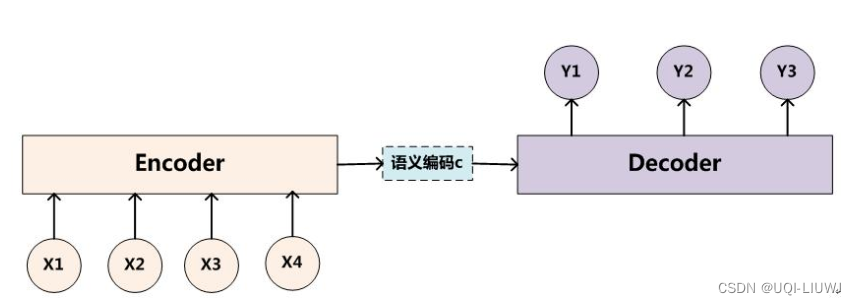

- 对于序列对<X,Y>,我们的目标是给定输入序列X,期待通过Encoder-Decoder框架来生成目标序列Y

- Encoder对输入的序列X进行编码,将输入序列通过非线性变换转化为中间语义表示C:

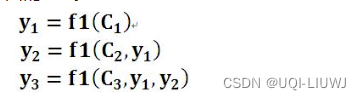

- Decoder根据序列X的中间语义表示C和之前已经生成的历史信息y1, y2….yi-1来生成i时刻要生成的下一个值:yi

1.2 缺点

- Encoder-Decoder框架有一个明显的缺点。

- Encoder会把输入序列X编码为一个固定长度的隐向量(语义编码c)

- 1. 隐向量的大小有限,无法表示信息丰富的序列;

- 2. 由于RNN类网络特点,网络会更加看中序列后面的信息,无法总揽全局。

- Encoder会把输入序列X编码为一个固定长度的隐向量(语义编码c)

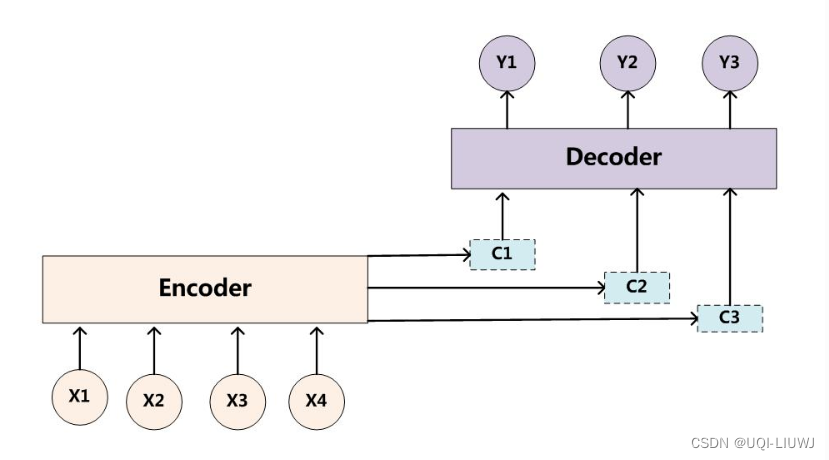

2 attentioned Seq2Seq

其中:每个元素的语义编码ci:

hj是encoder每个元素的隐状态,αij是加权系数

4

st-1是decoder t-1位置的输出