点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

作者:李宇轩 | 已授权转载(源:知乎)编辑:CVer

https://zhuanlan.zhihu.com/p/614449075

Large Selective Kernel Network for Remote Sensing Object Detection

论文:https://arxiv.org/abs/2303.09030

代码(已开源):

https://github.com/zcablii/Large-Selective-Kernel-Network

Abstract

最近关于遥感物体检测的研究主要集中在改进旋转包围框的表示方法上,但忽略了遥感场景中出现的独特的先验知识。这种先验知识是非常重要的,因为微小的遥感物体可能会在没有参考足够长距离背景的情况下被错误地检测出来,而不同类型的物体所要求的长距离背景可能会有所不同。在本文中,我们将这些先验因素考虑在内,并提出了Large Selective Kernel Network(LSKNet)。LSKNet可以动态地调整其大空间感受野,以更好地建模遥感场景中各种物体的测距的场景。据我们所知,这是首次在遥感物体检测领域探索大选择性卷积核机制的工作。在没有任何附加条件的情况下,我们LSKNet比主流检测器轻量的多,而且在多个数据集上刷新了SOTA!HRSC2016(98.46% mAP)、DOTA-v1.0(81.64% mAP)和FAIR1M-v1.0(47.87% mAP)。

Introduction

近期很少有工作考虑到遥感图像中存在的强大的先验知识。航空图像通常是以高分辨率的鸟瞰视角拍摄的。特别是,航空图像中的大多数物体可能是小尺寸的,仅凭其外观很难识别。相反,这些物体的成功识别往往依赖于它们的背景,因为周围的环境可以提供关于它们的形状、方向和其他特征的宝贵线索。根据对主流遥感数据集的分析,我们确定了两个重要的前提条件:

(1)准确检测遥感图像中的物体往往需要广泛的背景信息。

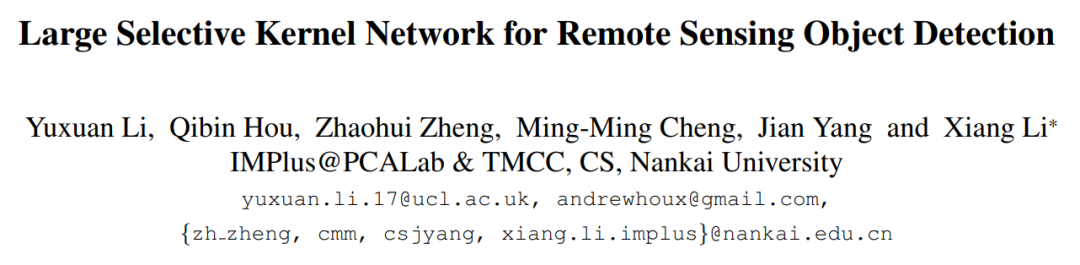

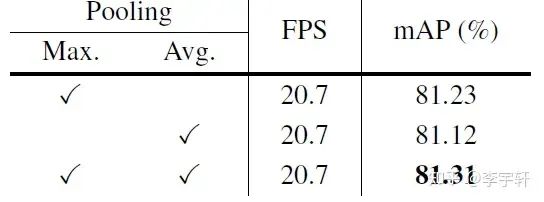

如图1(a)所示,遥感图像中的物体检测器所使用的有限范围的背景往往会导致错误的分类。例如,在上层图像中,由于其典型特征,检测器可能将T子路口归类为十字路口,但实际上,它不是一个十字交路口。同样,在下图中,由于大树的存在,检测器可能将十字路口归类为非路口,但这也是不正确的。这些错误的发生是因为检测器只考虑了物体附近的有限的上下文信息。在图1(b)中的船舶和车辆的例子中也可以看到类似的情况。

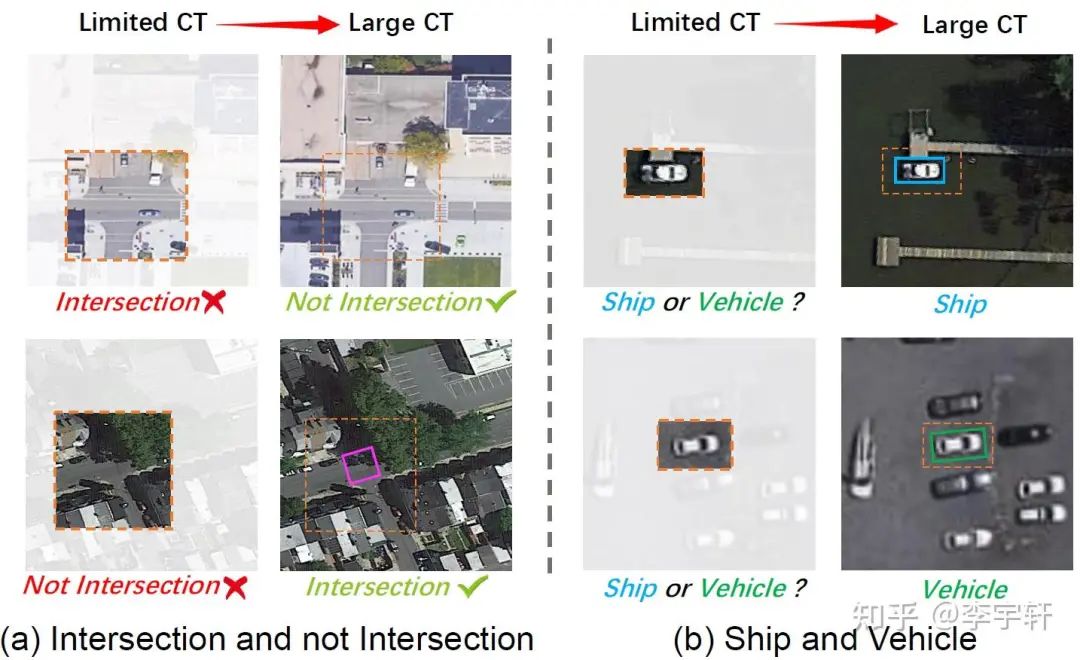

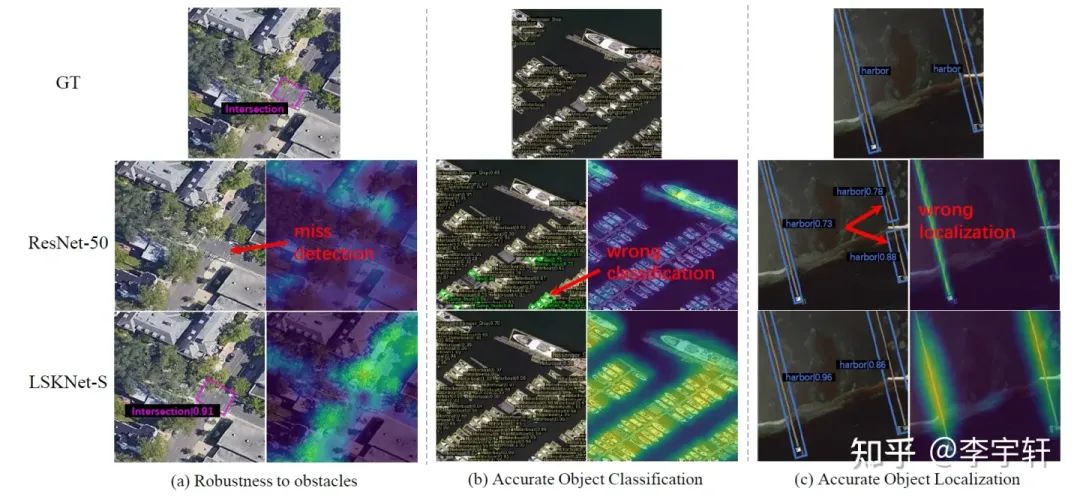

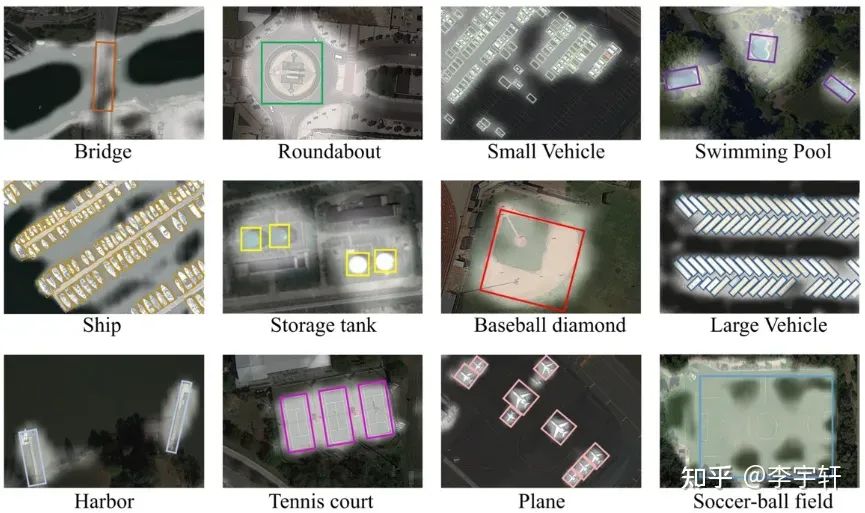

(2) 不同类型的物体所需的上下文信息的范围非常不同。如图2所示,在遥感图像中进行准确的物体检测所需的背景信息量会因被检测物体的类型而有很大不同。例如,足球场可能需要相对较少的额外环境信息,因为它有独特的可区分的球场边界线。相比之下,环岛可能需要更大范围的上下文信息,以区分花园和环形建筑。交叉口,特别是那些部分被树木覆盖的交叉口,由于相交道路之间的长距离依赖性,往往需要一个非常大的感受野。这是因为树木和其他障碍物的存在会使人们难以仅仅根据外观来识别道路和交叉口本身。其他物体类别,如桥梁、车辆和船舶,也可能需要不同规模的感受野,以便被准确检测和分类。

因为这些图像往往需要广泛和动态的背景信息,我们提出了一种新的方法,称为Large Selective Kernel Network(LSKNet)。我们的方法包括动态调整特征提取骨干的感受野,以便更有效地处理被检测物体的不同的广泛背景。这是通过一个空间选择机制来实现的,该机制对一连串的大depth-wise卷积核所处理的特征进行有效加权,然后在空间上将它们合并。这些核的权重是根据输入动态确定的,允许该模型自适应地使用不同的大核,并根据需要调整空间中每个目标的感受野。据我们所知,我们提出的LSKNet是第一个研究和讨论在遥感物体探测中使用大的和有选择性的卷积核的模型。尽管我们的模型很简单,但在三个流行的数据集上实现了最先进的性能。HRSC2016(98.46% mAP)、DOTA-v1.0(81.64% mAP)和FAIR1M-v1.0(47.87% mAP),超过了之前公布的结果。此外,我们实验证明了我们模型的行为与上述两个先验假设的一致性。

Method

LSKNet Architecture

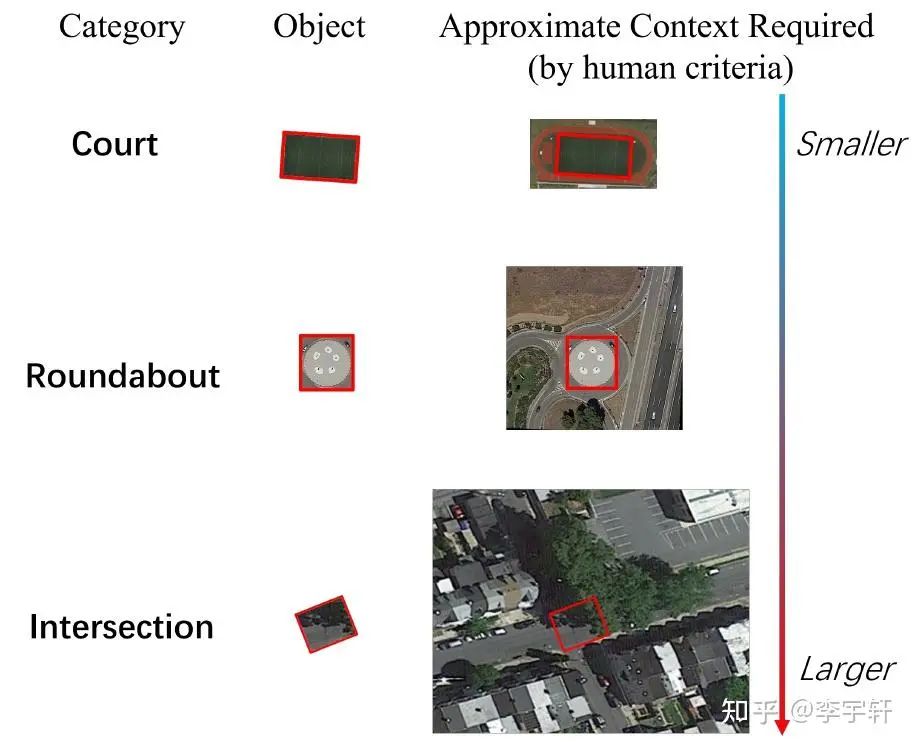

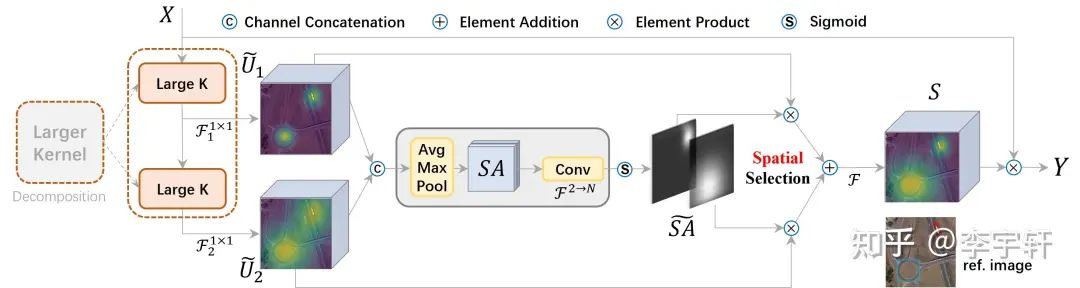

图3展示了一个LSKNet Bolck的图示,是主干网中的一个重复块,其灵感来自ConvNeXt, PVT-v2, VAN, Conv2Former 和 MetaFormer。每个LSKNet块由两个剩余子块组成:大核选择(LK Selection)子块和前馈网络(FFN)子块。LK选择子块根据需要动态地调整网络的感受野。前馈网络子块用于通道混合和特征细化,由一个全连接层、一个深度卷积、一个GELU激活和第二个全连接层组成的序列。核心模块LSK Module(图4)被嵌入到LK选择子块中。它由一连串的大内核卷积和一个空间内核选择机制组成。

Large Kernel Convolutions & Spatial Kernel Selection

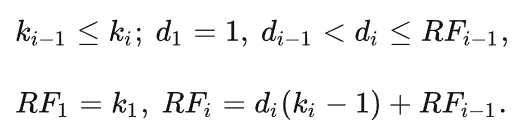

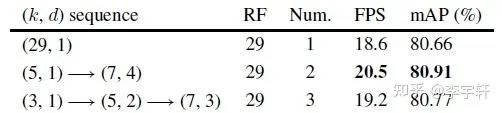

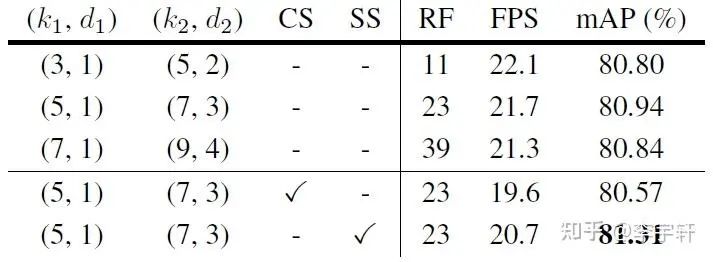

根据Introduction中所说的先验(2),建议对一系列的多个尺度的背景进行建模,以进行适应性选择。因此,我们建议通过明确地将其分解为一连串具有大的卷积核和不断扩张的depth-wise卷积来构建一个更大感受野的网络。其序列中第i个深度卷积的核大小k、扩张率d和感受野RF的扩展定义如下:

核的大小和扩张率的增加确保了感受野有足够快的扩展。我们对扩张率设定了一个上限,以保证扩张卷积不会在特征图之间引入空隙。

所提出的设计有两个优点。第一,它明确地产生了具有各种大感受野的多个特征,这使得后来的内核选择更加容易。第二,顺序分解比简单地应用一个较大的核更有效更高效。为了提高网络关注检测目标的最相关的空间背景区域的能力,我们使用了一种空间选择机制,从不同尺度的大卷积核中空间选择特征图。图4显示了LSK模块的详细概念图,在这里我们直观地展示了大选择核是如何通过自适应地收集不同物体的相应大感受野而发挥作用的。

LSK Module 的pytorch代码如下:

class LSKmodule(nn.Module):

def __init__(self, dim):

super().__init__()

self.conv0 = nn.Conv2d(dim, dim, 5, padding=2, groups=dim)

self.convl = nn.Conv2d(dim, dim, 7, stride=1, padding=9, groups=dim, dilation=3)

self.conv0_s = nn.Conv2d(dim, dim//2, 1)

self.conv1_s = nn.Conv2d(dim, dim//2, 1)

self.conv_squeeze = nn.Conv2d(2, 2, 7, padding=3)

self.conv_m = nn.Conv2d(dim//2, dim, 1)

def forward(self, x):

attn1 = self.conv0(x)

attn2 = self.convl(attn1)

attn1 = self.conv0_s(attn1)

attn2 = self.conv1_s(attn2)

attn = torch.cat([attn1, attn2], dim=1)

avg_attn = torch.mean(attn, dim=1, keepdim=True)

max_attn, _ = torch.max(attn, dim=1, keepdim=True)

agg = torch.cat([avg_attn, max_attn], dim=1)

sig = self.conv_squeeze(agg).sigmoid()

attn = attn1 * sig[:,0,:,:].unsqueeze(1) + attn2 * sig[:,1,:,:].unsqueeze(1)

attn = self.conv_m (attn)

return x * attnResults

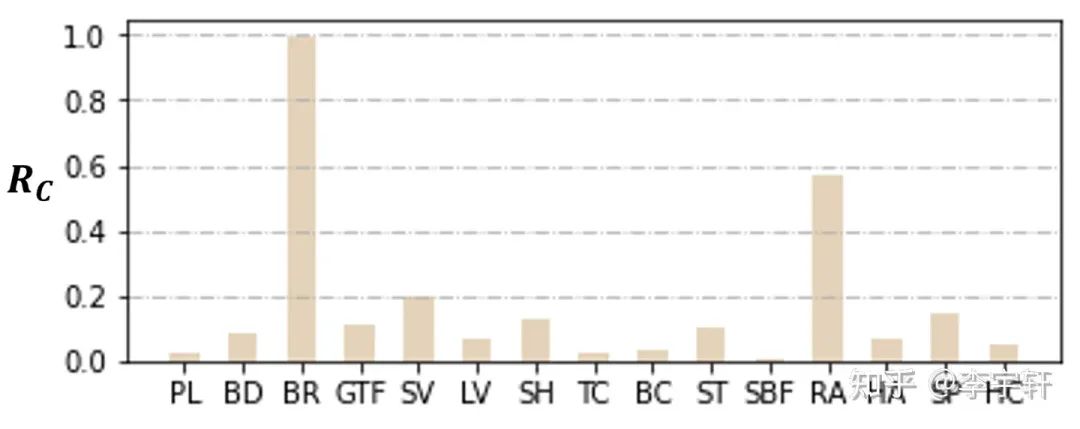

在我们的实验中,我们报告了HRSC2016、DOTA-v1.0和FAIR1M-v1.0数据集上的检测模型结果。为了保证公平性,我们遵循与其他主流方法相同的数据集处理方法和训练方式(如S2A-Net, Oriented RCNN, R3Det...)。

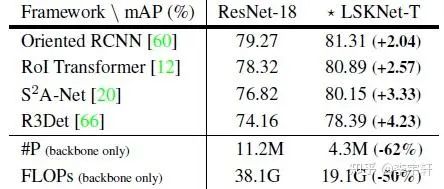

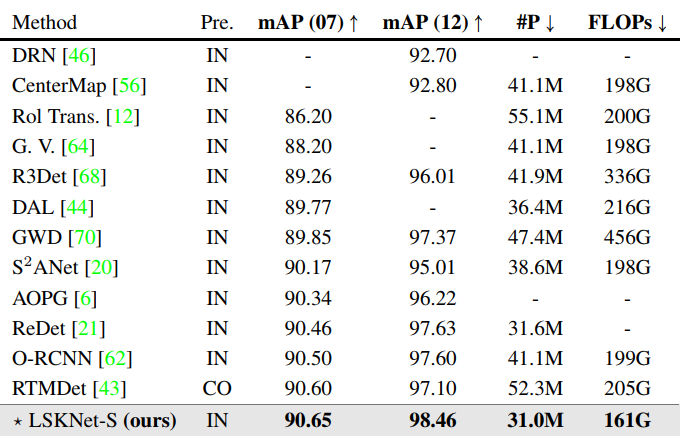

在不同检测框架下,使用我们的LSKNet骨干,模型更轻量,对检测模型性能提升巨大!(表1)

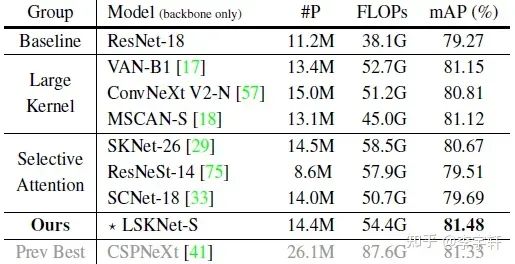

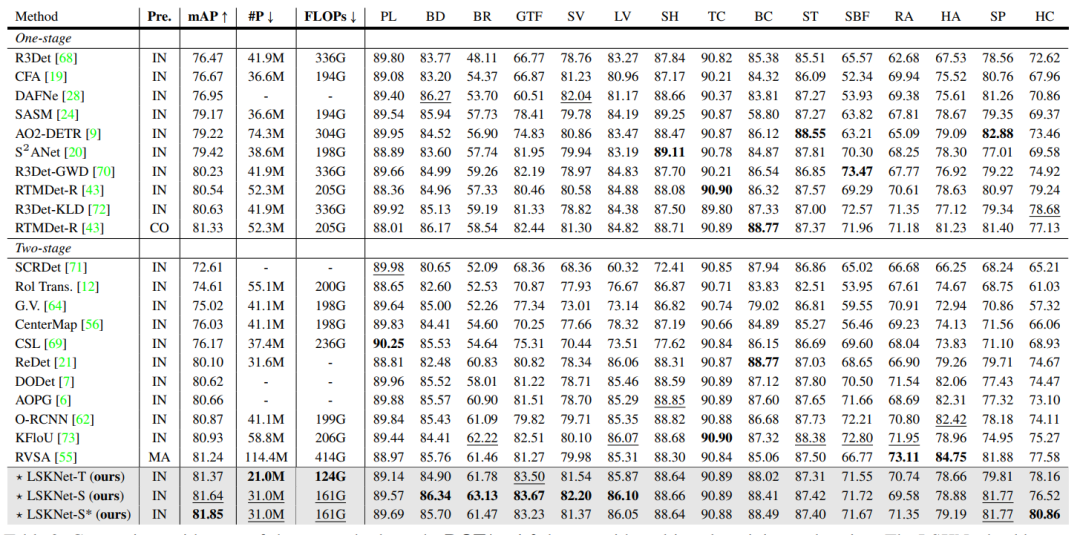

在相同检测框架的不同骨干网络(大卷积核和选择性机制的骨干网络)中,在相似模型复杂的的前提下,我们的LSKNet骨干mAP更强!(表2)

在HRSC2016数据集上,性能超越之前所有的方法!(表3)

在DOTA-v1.0数据集上,性能超越之前所有的方法!(表4)在此数据集上,(近期的方法在性能上近乎饱和,最近的SOTA方法RVSA用了极为重量的模型和在庞大的数据集上做预训练才勉强突破0.81的mAP,RTMDet则是在COCO预训练,36epoch加EMA的微调方式,而其他主流方法都是ImageNet预训练和12epoch w/o EMA微调,才达到81.33的性能。)我们的方法在模型参数量和计算复杂度全面小于其他方法的前提下,性能刷新了新的SOTA!

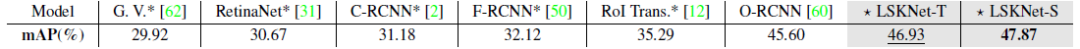

在近期中国空天院提出的FAIR1M-v1.0数据集上,我们也刷新了mAP。

Ablation Study

消融实验部分,为了提高实验效率,我们采用LSKNet-T骨架在ImageNet上做100个epoch的骨干预训练。

Analysis

图5所示,LSKNet-S可以捕捉到更多与检测到的目标相关的背景信息,从而在各种困难情况下有更好的表现,这证明了我们的先验(1)。

为了研究每个物体类别的感受野范围,我们定义物体类别预期感受野和GT框面积的比率:Rc。此数值越大,说明目标需要的额外感受野越大。图6中结果表明,与其他类别相比,桥梁类别需要更多的额外上下文信息,这主要是由于它与道路的特征相似,并且需要语境线索来确定它是否被水所包围。相反,球场类别,如足球场,由于其独特的纹理属性,特别是球场边界线,需要最少的上下文信息。这与我们的常识相吻合,并进一步支持先前的观点(2),即不同的物体类别所需的上下文信息的相对范围有很大不同。

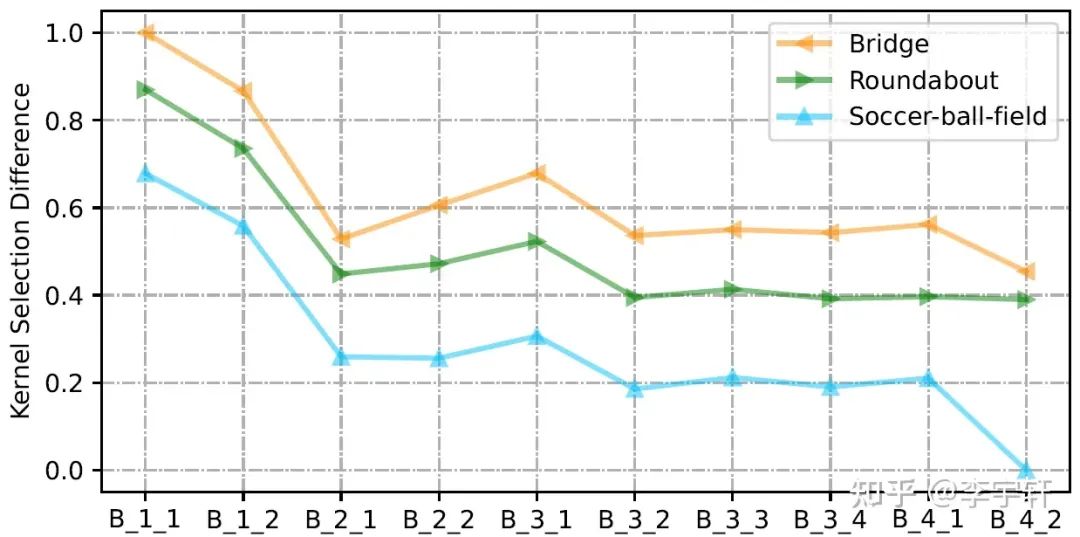

我们进一步研究我们的LSKNet中的大核选择倾向性行为。我们定义了Kernel Selection Difference(较大的感受野卷积核特征图激活值 - 较小的感受野卷积核特征图激活值)。

在图8中,我们展示了三个典型类别的所有图像的归一化Kernel Selection Difference:桥梁、环形路和足球场,以及每个LSKNet-T块的情况。正如预期的那样,Bridge的所有块的大核的参与度高于Roundabout,而Roundabout则高于Soccer-ball-field。这与常识一致,即Soccer-ball-field确实不需要大量的上下文,因为它本身的纹理特征已经足够明显和具有鉴别性。我们还出人意料地发现了LSKNet在网络深度上的另一种选择模式。LSKNet通常在其浅层利用较大感受野的卷积核,而在较高的层次利用较小的。这表明,网络倾向于在网络浅层迅速扩大感受野捕捉信息,以便高层次的语义学能够包含足够的感受野,从而获得更好的辨别力。

ICCV / CVPR 2023论文和代码下载

后台回复:CVPR2023,即可下载CVPR 2023论文和代码开源的论文合集

后台回复:ICCV2023,即可下载ICCV 2023论文和代码开源的论文合集目标检测和Transformer交流群成立

扫描下方二维码,或者添加微信:CVer333,即可添加CVer小助手微信,便可申请加入CVer-目标检测或者Transformer 微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer等。

一定要备注:研究方向+地点+学校/公司+昵称(如目标检测或者Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲扫码或加微信号: CVer333,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉,已汇集数千人!

▲扫码进星球

▲点击上方卡片,关注CVer公众号整理不易,请点赞和在看![]()