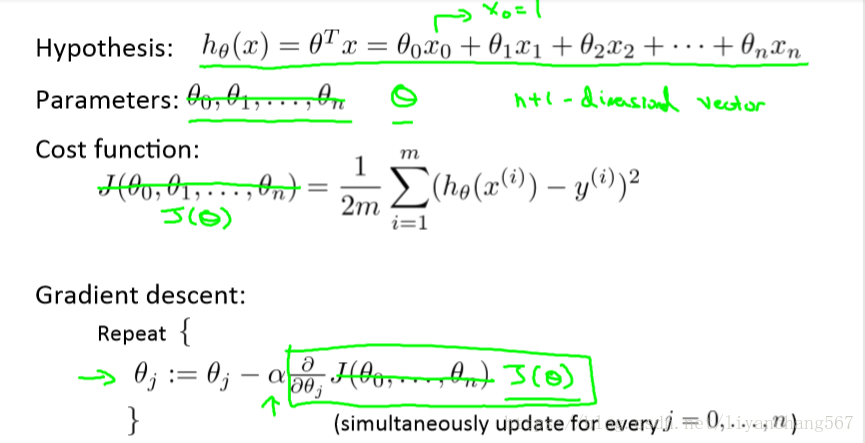

多元线性回归模型

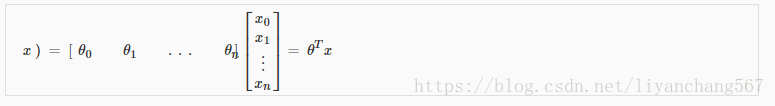

hθ(x)使用矩阵乘法表示,结果如下:

x0=1时,矩阵乘法结果与假设的模型一致

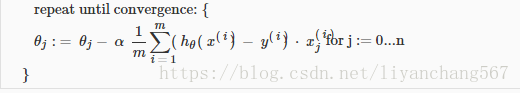

1、梯度下降多变量,θ计算方法如下:

即

多元变量因为数据各自单位差异,直接使用进行迭代时间较长,效率较低。

对变量进行归一化处理,特征值缩放后,可以提高计算效率。

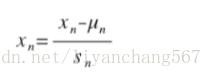

特征值缩放一般方式如下:

或者

- Un表示特征的平均值

- si代表x的max-min的区间值

特征值缩放归一化处理后,xi

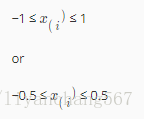

学习效率:

1.如果\alphaα太小:收敛慢。

2.如果\alphaα太大:在每次迭代中可能不会减少,因此可能不会收敛。

如图所示

2、正规方程的方法求θ

θ=( XT X)− 1 XT y

( XT X)− 1如果不存在

冗余功能,其中两个功能密切相关(即它们是线性相关的)

太多特征(例如m≤n), 在这种情况下,删除一些功能或使用“正规化”。

太多特征(例如m≤n), 在这种情况下,删除一些功能或使用“正规化”。

| Gradient Descent | Normal Equation |

|---|---|

| Need to choose alpha | No need to choose alpha |

| Needs many iterations | No need to iterate |

| O (kn^2kn2) | O (n^3n3), need to calculate inverse of X^TXXTX |

| Works well when n is large | Slow if n is very large |

正规方程求θ证明方式请见自己搜索,推荐:

https://blog.csdn.net/perfect_accepted/article/details/78383434

其中一种证明方法的图片(引用其他人证明的材料)如下: