一、说明

在学习RNN的时候,多少有些东西可以作为实例进行原理性实践;而进入LSTM时代,短小的能说明原理的案例实验并不多,相反,对此的参考文献却海啸般地到来,让人来不及消化;本文是万篇论文之一,因其叙述的独特性,被我选入介绍给大家。

二、从循环神经网络说起

人类并不是每时每刻都从头开始思考。当你阅读这篇文章时,你会根据对前面单词的理解来理解每个单词。你不会扔掉所有东西并重新从头开始思考。你的思想有恒心。

传统的神经网络无法做到这一点,这似乎是一个主要缺点。例如,假设您想要对电影中每个点发生的事件类型进行分类。目前尚不清楚传统的神经网络如何利用其对电影中先前事件的推理来为后来的事件提供信息。

循环神经网络解决了这个问题。它们是带有循环的网络,允许信息持续存在。

2.1 循环神经网络的要素

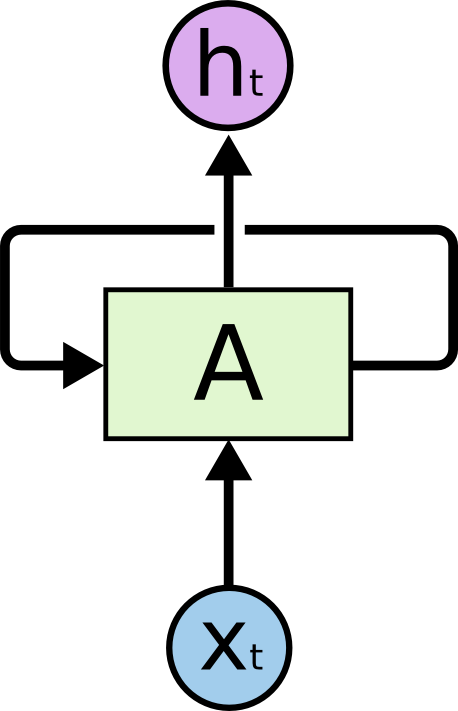

2.1.1 循环神经网络有循环。

在上图中,神经网络的一部分 A 会查看某些输入 xt 并输出值 htℎ 。循环允许信息从网络的一个步骤传递到下一步。

这些循环使循环神经网络显得有些神秘。然而,如果你多想一点,就会发现它们与普通的神经网络并没有什么不同。循环神经网络可以被认为是同一网络的多个副本,每个副本都将消息传递给后继网络。考虑一下如果我们展开循环会发生什么: