1.摘要

图像融合是将同一场景的多幅图像合成一幅新的图像。合成的图像应该适合于人类视觉感知和后续的高级图像处理任务。然而,现有的方法侧重于融合低层次的特征,忽略了高层的语义感知信息。我们提出了一种新的端到端模型,以获得一个更语义一致的图像在红外和可见光图像融合,称为语义监督的双鉴别器生成对抗网络(SDDGAN)。特别是,我们设计了一个信息量判别(IQD)块,以指导融合的进展。对于每个源图像,块确定用于保留每个语义对象的特征的权重。通过这种方式,生成器学习通过不同的权重来融合各种语义对象,以保持它们的特征。同时,采用双鉴别器对融合图像中红外和可见光信息的分布进行鉴别,因此,我们的融合图像信息量更大。红外图像中的热辐射和可见光图像的纹理细节都能得到很好的保留。

2.引言

==在图像融合中,“manually design activity level measurements”(手动设计活动水平测量)指的是通过人工的方式来确定图像中的活动水平或者动态程度。==在图像融合中,我们可能需要将两个或多个图像合并在一起,以创建一个新的图像,使得合并后的图像能够同时展现各个输入图像的关键信息。活动水平是指图像中存在的运动或变化的程度,它可以帮助我们理解图像的动态特征。手动设计活动水平测量意味着我们需要通过人工的方式来评估图像中的活动水平。这可能涉及到观察图像中的运动对象、检测图像中的运动轨迹或者变化区域,并为其分配一个活动水平的度量值。这些度量值可以是连续的(例如,活动水平从低到高的一个数值范围),也可以是离散的(例如,将活动水平分为几个等级)。

本研究的三个主要贡献如下:

- 首先,设计了一个特殊的信息量判别模块(IQD),用于判断融合图像中各个目标的保存程度,并对图像融合过程进行监督,融合图像信息量大,具有较高的场景再现能力;

- 其次,提出的双鉴别器作用于不同的模态(红外/可见光)的语义对象,保留和增强其模态特征的融合图像;

- 第三,所提出的SDDGAN是端到端的,并且以自动的方式统一了特征提取和融合。所提出的SDDGAN是优于目前最先进的方法的效率,因为它更简单的生成器网络。

3.方法

3.1 Problem Formulation

给定红外图像 I r I_r Ir和可见光图像 I v I_v Iv,我们的目标是学习一个生成器G,该生成器可以从源图像中提取最有效的特征,并生成具有增强视觉效果的信息融合图像 I f I_f If,便于后续处理和应用。然而,不同的语义对象具有各自的特征,它们在不同的模态中所代表的场景信息也有很大差异。与其为整个图像设计一系列新的图像融合规则,我们将图像融合问题定义为其中不同语义对象的融合。

更具体地说,我们设计了一个IQD模块,它可以根据每个语义对象自身的特征和内容来确定其在融合图像中的保存程度,以监督图像融合过程。此外,我们在我们的网络中采用双鉴别器来识别红外和可见光信息的分布。

每个鉴别器对融合图像中的语义对象的一个模态进行操作,通过与G的对抗博弈来保留和增强它们的模型特征。因此,G的训练目标可以定义为最小化以下目标函数 L G = L s u p + α L a d v + β L g r a d + γ L m s e , ( 5 ) L_G =L_{sup}+\alpha L_{adv}+\beta L_{grad}+γ L_{mse} ,\quad (5) LG=Lsup+αLadv+βLgrad+γLmse,(5)

其中, L s u p L_{sup} Lsup和 L a d v L_{adv} Ladv分别表示监督损失和对抗损失。具体而言,IQD块可以为每个语义对象生成不同的融合权重, L s u p L_{sup} Lsup表示在不同的融合权重下,融合图像中每个语义对象与源图像之间的总距离。 L a d v L_{adv} Ladv表示生成器G试图欺骗鉴别器的对抗损失。 L g r a d L_{grad} Lgrad和 L m s e L_{mse} Lmse分别是梯度损失和均方误差(MSE)损失,用于强制融合图像保留源图像中的大量信息。α、β和γ是正则化项。因此,鉴别器的目标是最大化对抗损失 L a d v L_{adv} Ladv。

3.2 Information Quantity Discrimination Block

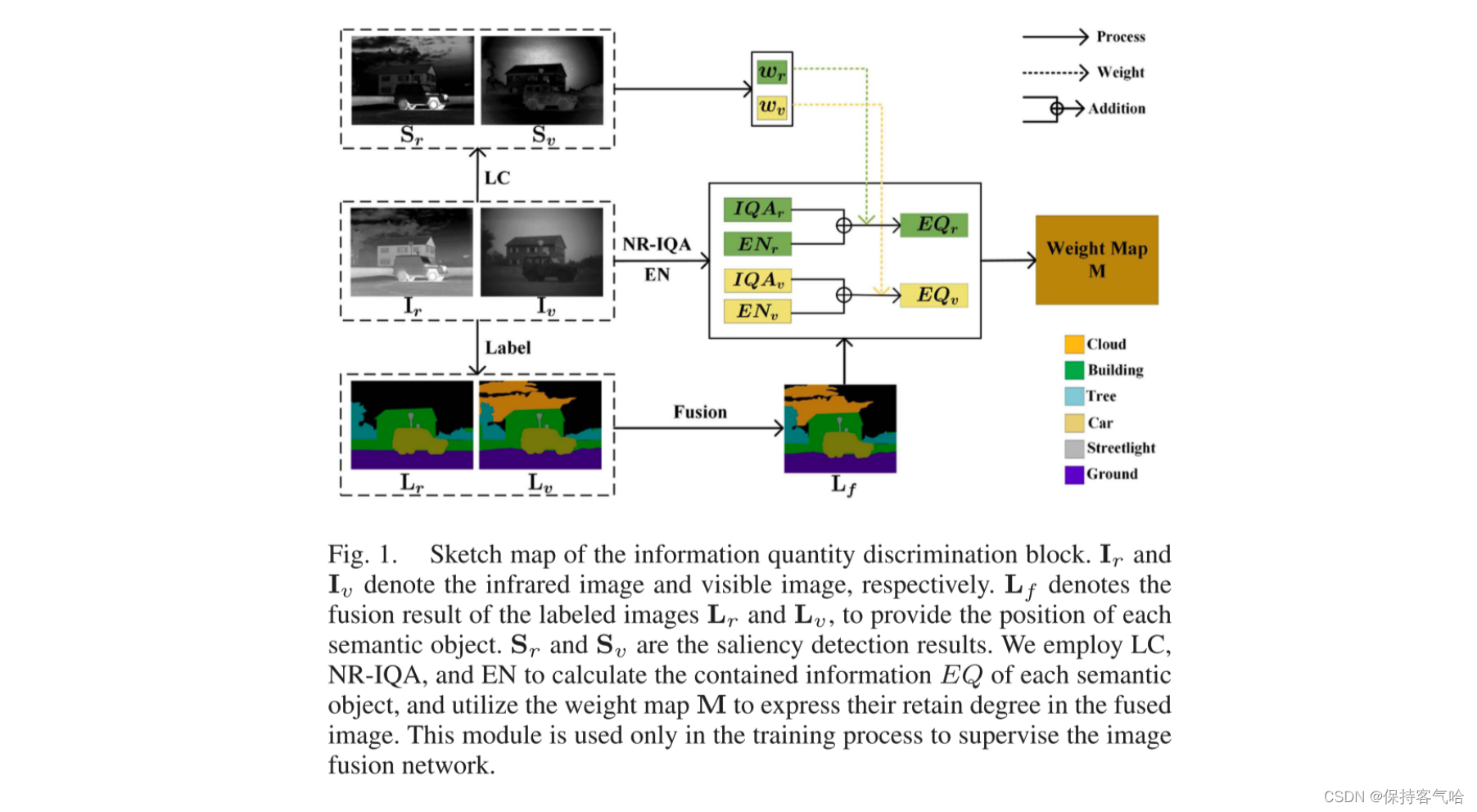

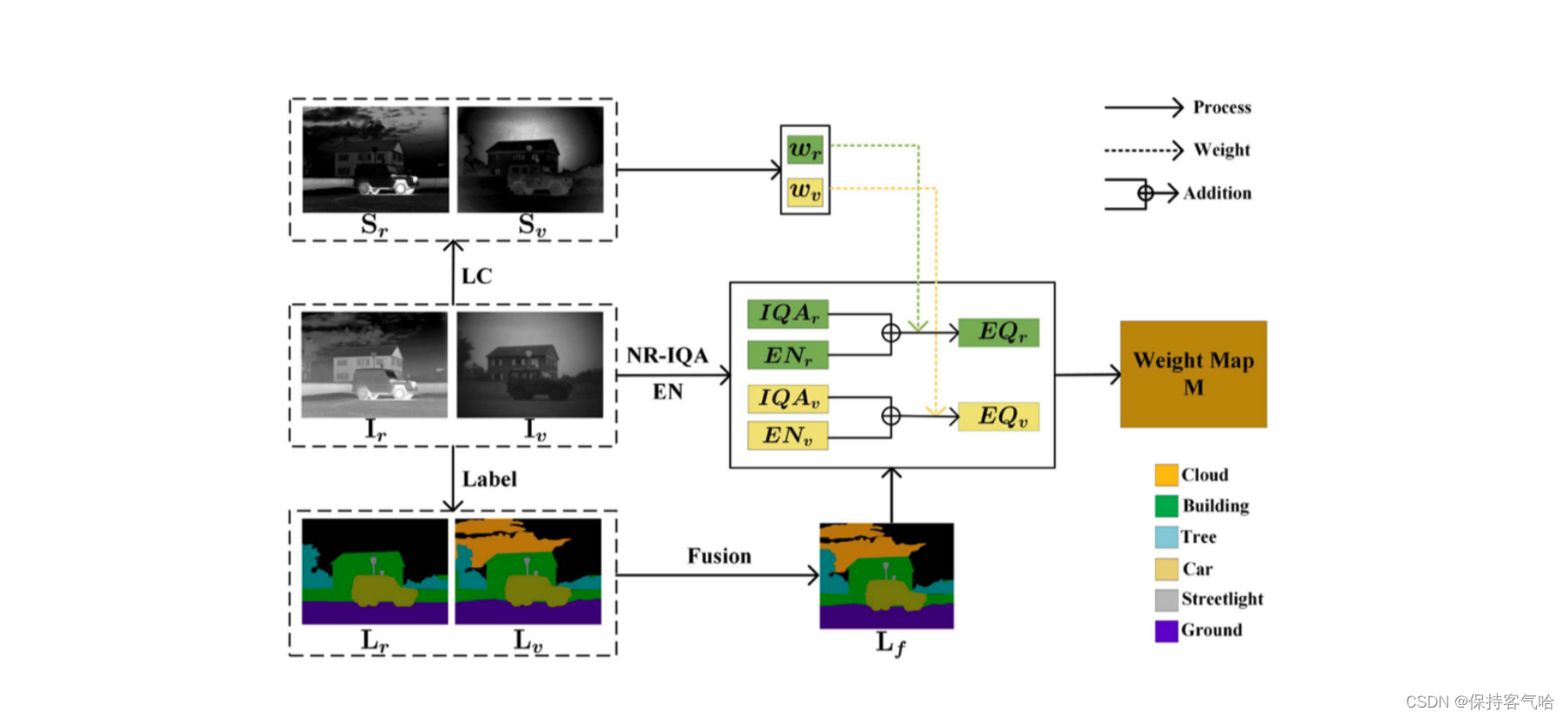

为了评估每个语义对象的保留程度,我们建立了一个特殊的信息量判别(IQD)块,它由无参考图像质量评估(NR-IQA)、熵(EN)和显著性(LC,亮度对比度)组成。如图1所示,我们采用NR-IQA来评估源图像中每个对象区域的质量。它可以测量对象区域质量是否因特定类型的失真而下降,例如模糊、压缩、阻塞效应和各种形式的噪声。

I r I_r Ir和 I v I_v Iv分别表示红外图像和可见光图像。 L f L_f Lf表示标记图像 L r L_r Lr和 L v L_v Lv的融合结果,用于提供每个语义对象的位置。 S r S_r Sr和 S v S_v Sv是显著性检测的结果。我们使用LC、NR-IQA(无参考图像质量评估)和EN来计算每个语义对象所包含的信息量EQ,并利用权重图M来表示它们在融合图像中的保留程度。该模块仅在训练过程中用于监督图像融合网络。

-

如图所示。在图2(a)-(b)中,可见光图像由反射光成像,并且可见光图像中的对象倾向于具有高IQA。然而,IQA只能评估对象区域的质量,而不考虑其他方面。典型的例子如图所示2(c).可见光图像中的云区域具有较高的IQA,而红外图像中的云区域具有更完整的场景表示。直观上,我们更喜欢它的融合结果更接近红外图像。从理论上讲,融合图像中保留的源图像的语义对象信息越多越好。因此,我们应用客观度量EN来估计每个语义对象中的信息量。在数学上,EN定义如下: E N = − ∑ l = 0 L − 1 p l l o g 2 p l ( 6 ) EN = -\sum_{l=0}^{L-1}p_llog_2p_l \quad (6) EN=−l=0∑L−1pllog2pl(6)

- 其中L是灰度级的数量,通常设置为256。 p l p_l pl是相应级别的概率。

-

由于热辐射,红外图像中的汽车和人物非常重要,如图2(d)所示,无法使用熵(EN)和无参考图像质量评估(NR-IQA)来计算。因此,我们添加了显著性(LC)作为评估准则,以确保这些特征能够在融合图像中得到良好的保留。图像I中像素 I k I_k Ik的显著性值定义如下: L C ( I k ) = ∑ i = 1 W ∑ j = 1 H ∣ ∣ I k − ( I ) i , j ∣ ∣ ( 7 ) LC(I_k)=\sum_{i=1}^W \sum_{j=1}^H||I_k-(I)_{i,j}|| \quad(7) LC(Ik)=i=1∑Wj=1∑H∣∣Ik−(I)i,j∣∣(7)

- 其中, I i , j I_{i,j} Ii,j的值在[0,255]的范围内, ∣ ∣ ⋅ ∣ ∣ || · || ∣∣⋅∣∣表示颜色距离度量,通常使用欧氏距离。熵(EN)可以确保在融合图像中获得相当数量的信息,而显著性(LC)可以保持目标区域的显著性。然而,它们对噪声都很敏感。而无参考图像质量评估(NR-IQA)可以评估噪声和其他降低图像质量的问题。因此,NR-IQA、EN和LC的组合是一个综合评估准则,可以有效地计算每个语义对象所包含的信息量。

IQD块的最终目标是生成一个权值图M,该权值图M可以表达融合图像中不同语义对象的保存程度,并监督图像融合过程。如图1所示,首先对红外图像 I r I_r Ir和可见光图像 I v I_v Iv进行标记,得到标记图像 L r L_r Lr和 L v L_v Lv。然而,由于成像原理的差异,某些语义对象的部分仅由 I r I_r Ir或 I v I_v Iv捕捉到。因此,我们使用预先设计的规则将标记图像 L r L_r Lr和 L v L_v Lv进行融合,以获得完整的标签图像 L f L_f Lf,这可以帮助我们确定源图像中每个语义对象的位置。在我们的测试过程中不需要使用标记图像,我们计算 I r I_r Ir和 I v I_v Iv中每个语义对象所包含的信息量EQ,可以定义如下:

E Q r / v p = w r / v p ⋅ ( I Q A ) r / v p + ξ E N r / v p ( 8 ) EQ_{r/v}^p = w_{r/v}^p ·(IQA)_{r/v}^p+ξEN_{r/v}^p \quad (8) EQr/vp=wr/vp⋅(IQA)r/vp+ξENr/vp(8)

- 其中$EQ_{r/v}^p 表示 表示 表示I_r 或 或 或I_v 中语义对象 p 的包含信息。 中语义对象p的包含信息。 中语义对象p的包含信息。(IQA)_{r/v}p,EN_{r/v}p 是使用 N R − I Q A 和 E N 计算的 是使用NR-IQA和EN计算的 是使用NR−IQA和EN计算的I_r 或 或 或I_v 中的 p 值 , 用 ξ 来控制权衡。 中的p值,用ξ来控制权衡。 中的p值,用ξ来控制权衡。wp_r$和$wp_v 分别表示显著性检测结果 分别表示显著性检测结果 分别表示显著性检测结果S_r 和 和 和S_v$中的p的比率

- 其中 w r p w^p_r wrp可以表示为 w r p = ∑ i , j ∈ p ( S r ) i , j ∑ i , j ∈ p ( ( S r ) i , j + ( S v ) i , j ) ( 9 ) w^p_r=\frac{\sum_{i,j\in p}(S_r)_{i,j}}{\sum_{i,j\in p}((S_r)_{i,j}+(S_v)_{i,j})} \quad (9) wrp=∑i,j∈p((Sr)i,j+(Sv)i,j)∑i,j∈p(Sr)i,j(9)

- 因此,$w^p_v $ 被定义为: 1 − w r p 1 −w^p_r 1−wrp

- 最后,源图像对儿的权重图M被计算为: M p = E Q r p E Q r p + E Q v p ( 10 ) M^p=\frac{EQ_{r}^p}{EQ_{r}^p+EQ_{v}^p} \quad(10) Mp=EQrp+EQvpEQrp(10)

- 其中, M p M^p Mp表示权重图M中的语义对象区域p,其值表示p在 I r I_r Ir中的保留程度,而p在 I v I_v Iv中的保留程度定义为: 1 − M p 1−M_p 1−Mp。如果 M p M_p Mp<0.5,则 I v I_v Iv中的p包含丰富的纹理细节。如果 M p M_p Mp>0.5,则 I r I_r Ir中的p由于热辐射而显著

3.3. Generative Adversarial Network With Dual Discriminators

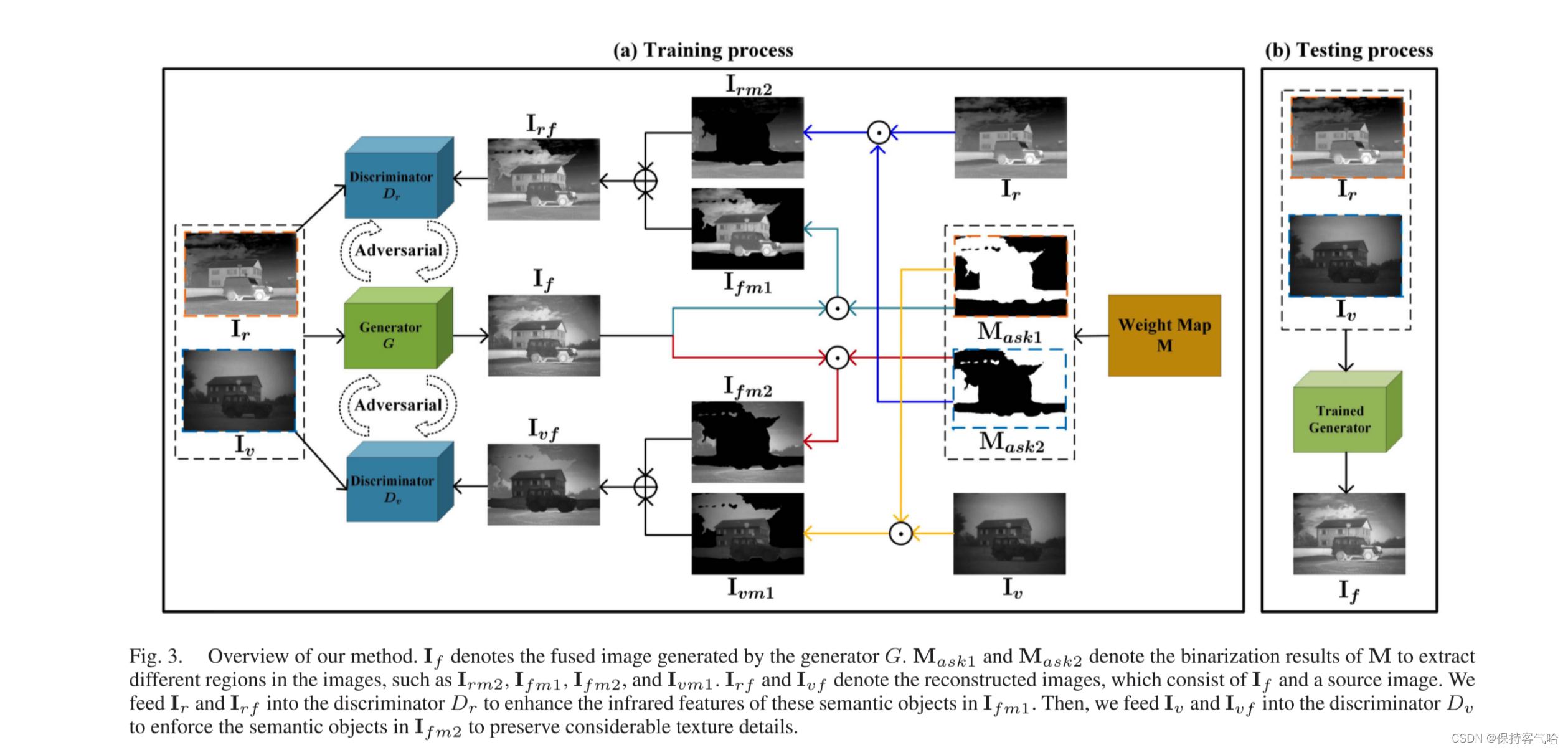

上述图中: I f I_f If表示由生成器G生成的融合图像。 M a s k 1 M_{ask1} Mask1和 M a s k 2 M_{ask2} Mask2表示M的二值化结果,用于提取图像中的不同区域,如 I r m 2 、 I f m 1 、 I f m 2 和 I v m 1 I_{rm2}、I_{fm1}、I_{fm2}和I_{vm1} Irm2、Ifm1、Ifm2和Ivm1。 I r f 和 I v f I_{rf}和I_{vf} Irf和Ivf表示重构图像,由 I f I_f If和源图像组成。我们将 I r I_r Ir和 I r f I_{rf} Irf输入鉴别器 D r D_r Dr,以增强 I f m 1 I_{fm1} Ifm1中这些语义对象的红外特征。然后,我们将 I v 和 I v f I_v和I_{vf} Iv和Ivf输入鉴别器 D v D_v Dv,以强制 I f m 2 I_{fm2} Ifm2中的语义对象保留显著的纹理细节。

我们SDDGAN的整体框架如图3(a)所示。我们使用两个鉴别器 D r D_r Dr和 D v D_v Dv与生成器G进行对抗训练;分别将 I r I_r Ir和 I v I_v Iv视为真实数据。特别地,我们不使用 I f I_f If作为 D r 和 D v D_r和D_v Dr和Dv的虚假数据,而是使用重构的图像 I r f 和 I v f I_{rf}和I_{vf} Irf和Ivf,其中 I r f I_{rf} Irf可以定义为: I r f = I f ◦ M a s k 1 + I r ◦ M a s k 2 = I f m 1 + I r m 2 , ( 11 ) I_{rf} = I_f ◦M_{ask1} + I_r ◦M_{ask2} = I_{fm1} + I_{rm2},\quad (11) Irf=If◦Mask1+Ir◦Mask2=Ifm1+Irm2,(11)

注:其实这就是将融合图像中的红外信息提取出来,以及把红外图像中的可见光信息提取出来得到最终的红外图像中的所有重要信息

其中, M a s k 1 M_{ask1} Mask1是权重图M的二值化结果,而 M a s k 2 = 1 − M a s k 1 M_{ask2} = 1−M_{ask1} Mask2=1−Mask1。 M a s k 1 M_{ask1} Mask1中的白色区域由M中值大于0.5的语义对象组成,该区域的融合结果应该接近于 I r I_r Ir。相反,黑色区域表示其中的语义对象的融合结果应该接近于 I v I_v Iv。我们使用来自真实数据 I r I_r Ir的 I r m 2 I_{rm2} Irm2来替代 I f I_f If中的非红外偏好部分。

因此,鉴别器 D r D_r Dr被训练用于识别 I r I_r Ir的分布,并限制生成器G在红外语义对象区域保留重要特征。类似地,鉴别器 D v D_v Dv用于识别 I v I_v Iv的分布,并训练以区分真实图像 I v I_v Iv和由 I v I_v Iv和 I f I_f If组成的虚假图像 I v f I_{vf} Ivf。因此, D v D_v Dv迫使G生成保留可见语义对象区域纹理细节的结果。两个鉴别器在 I f I_f If的不同部分上进行操作,彼此之间不进行交互。因此,在训练后,融合图像 I f I_f If可以保留红外图像和可见光图像的期望特征,并且无需寻找生成器和鉴别器之间的平衡点。

3.4 Loss Function

我们提出的SDDGAN的损失函数可以分为两部分:生成器G的损失函数和两个鉴别器 D r D_r Dr和 D v D_v Dv的损失函数。生成器的损失 L G L_G LG可以用公式(5)表示,包括监督损失 L s u p L_{sup} Lsup、对抗损失 L a d v L_{adv} Ladv、梯度损失 L g r a d L_{grad} Lgrad和均方误差损失 L m s e L_{mse} Lmse。

-

监督损失 L s u p L_{sup} Lsup可以定义为: L s u p = 1 W H ∑ i = 1 W ∑ j = 1 H ( ( M ) i , j ◦ ( ( I f ) i , j − ( I r ) i , j ) 2 + η ( 1 − ( M ) i , j ) ◦ ( ( I f ) i , j − ( I v ) i , j ) 2 ) , ( 12 ) L_{sup}=\frac{1}{WH}\sum_{i=1}^W\sum_{j=1}^H((M)_{i,j}◦((I_f)_{i,j}-(I_r)_{i,j})^2+η(1-(M)_{i,j})◦((I_f)_{i,j}-(I_v)_{i,j})^2),\quad (12) Lsup=WH1i=1∑Wj=1∑H((M)i,j◦((If)i,j−(Ir)i,j)2+η(1−(M)i,j)◦((If)i,j−(Iv)i,j)2),(12)

- 其中,W和H分别表示输入图像的宽度和高度。M中的 ( M ) i , j (M)_{i,j} (M)i,j表示源图像中不同语义对象的融合权重,它们在不同的语义区域中具有不同的值。因此,它可以确定融合图像中每个语义对象的保留程度。η是一个正参数,用于控制两个项之间的权衡。

-

第二损失 L a d v L_{adv} Ladv表示生成器G与两个鉴别器之间的对抗损失,其可以被定义为: L a d v = 1 N ∑ n = 1 N ( ( 1 − D r ( I r f n ) ) 2 + λ ( 1 − D v ( I v f n ) ) 2 ) , ( 13 ) L_{adv}=\frac{1}{N}\sum_{n=1}^N((1-D_r(I_{rf}^n))^2+\lambda (1-D_v(I^n_{vf}))^2),\quad (13) Ladv=N1n=1∑N((1−Dr(Irfn))2+λ(1−Dv(Ivfn))2),(13)

- 其中, I r f n I_{rf}^n Irfn和 I v f n I_{vf}^n Ivfn表示具有n∈INN的重构图像,N表示重构图像的数量。λ是一个正参数;常数1表示生成器希望鉴别器相信虚假数据。

-

第三损失 L g r a d L_{grad} Lgrad表示梯度约束。我们强制融合图像 I f I_f If具有类似于 I r I_r Ir和 I v I_v Iv的梯度,其可以表示如下: L g r a d = 1 W H ( ∣ ∣ ∇ I f − ∇ I r ∣ ∣ 2 2 + μ ∣ ∣ ∇ I f − ∇ I v ∣ ∣ 2 2 ) , ( 14 ) L_{grad}=\frac{1}{WH}(||∇I_f-∇I_r||_2^2+\mu ||∇I_f-∇I_v||^2_2),\quad (14) Lgrad=WH1(∣∣∇If−∇Ir∣∣22+μ∣∣∇If−∇Iv∣∣22),(14)

- 其中∇表示梯度算子,μ用于在两项之间取得平衡。

-

第四个损失 L m s e L_{mse} Lmse表示MSE损失。我们应用MSE损失来约束融合图像包含来自源图像的大量信息,其可以定义为: L m s e = 1 W H ∑ i = 1 W ∑ j = 1 H ( ( ( I f ) i , j − ( I r ) i , j ) 2 + k ( ( I f ) i , j − ( I v ) i , j ) 2 ) , ( 15 ) L_{mse}=\frac{1}{WH}\sum_{i=1}^W\sum_{j=1}^H(((If)_{i,j}-(I_r)_{i,j})^2+k((I_f)_{i,j}-(I_v)_{i,j})^2) ,\quad (15) Lmse=WH1i=1∑Wj=1∑H(((If)i,j−(Ir)i,j)2+k((If)i,j−(Iv)i,j)2),(15)

- 其中κ用于达到平衡。

鉴别器被训练以区分真实的和虚假数据,并输出估计来自真实数据而不是G的输入的概率的标量。这两个鉴别器的对抗损失定义如下:

L D r = 1 N ∑ n = 1 N ( ( 1 − D r ( I r n ) ) 2 + ( D r ( I r f n ) ) 2 ) , ( 16 ) L_{Dr}=\frac{1}{N}\sum_{n=1}^N((1-D_r(I_r^n))^2+(D_r(I_{rf}^n))^2),\quad(16) LDr=N1n=1∑N((1−Dr(Irn))2+(Dr(Irfn))2),(16)

L D v = 1 N ∑ n = 1 N ( ( 1 − D v ( I v n ) ) 2 + ( D v ( I v f n ) ) 2 ) , ( 17 ) L_{Dv}=\frac{1}{N}\sum_{n=1}^N((1-D_v(I_v^n))^2+(D_v(I_{vf}^n))^2),\quad(17) LDv=N1n=1∑N((1−Dv(Ivn))2+(Dv(Ivfn))2),(17)

3.5 Network Architecture

3.5.1 Generator Architecture

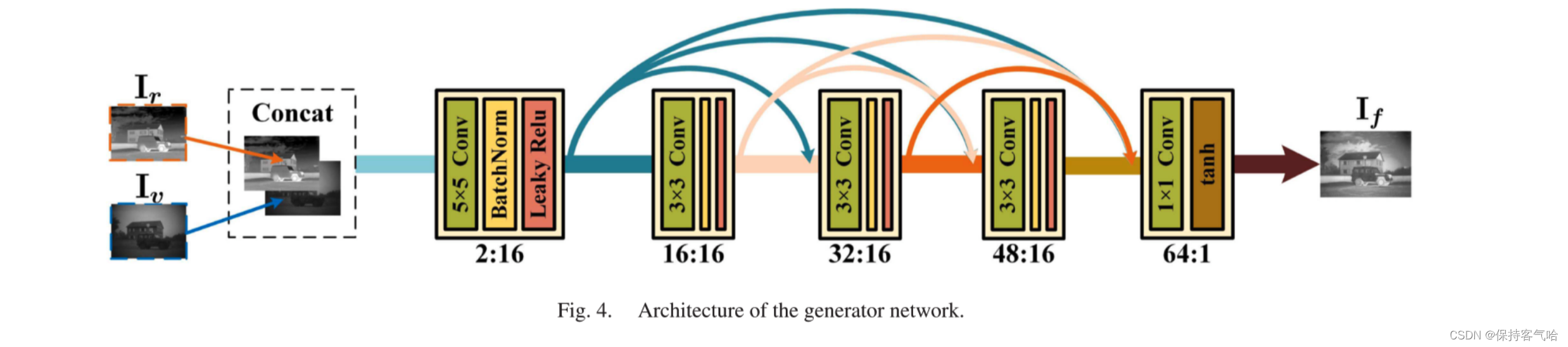

生成器G的网络架构如图4所示。我们将红外图像和可见光图像在通道维度上进行连接,并将它们作为G的输入。输出是最终的融合图像。G由五个普通的卷积层组成。对于每个卷积层,填充设置为SAME,步幅设置为1。因此,特征图的大小不会改变。在所有的卷积层中,我们采用批归一化和激活函数来克服数据初始化的敏感性并避免梯度消失。对于前四个层,我们采用批归一化和Leaky ReLU激活函数来提高G的鲁棒性;对于最后一层,我们只使用tanh激活函数。五个卷积层中的卷积核大小分别为5×5、3×3、3×3、3×3和1×1。卷积核的数量分别为16、16、16、16和1。我们在前四层中应用了来自密集连接卷积网络的密集连接层。如图4中的箭头所示,我们以前向传播的方式在每个层之间建立连接,以进行特征重用,防止在卷积过程中丢失一些重要信息。因此,五个层的输入和输出通道比例为2:16、16:16、32:16、48:16和64:1。

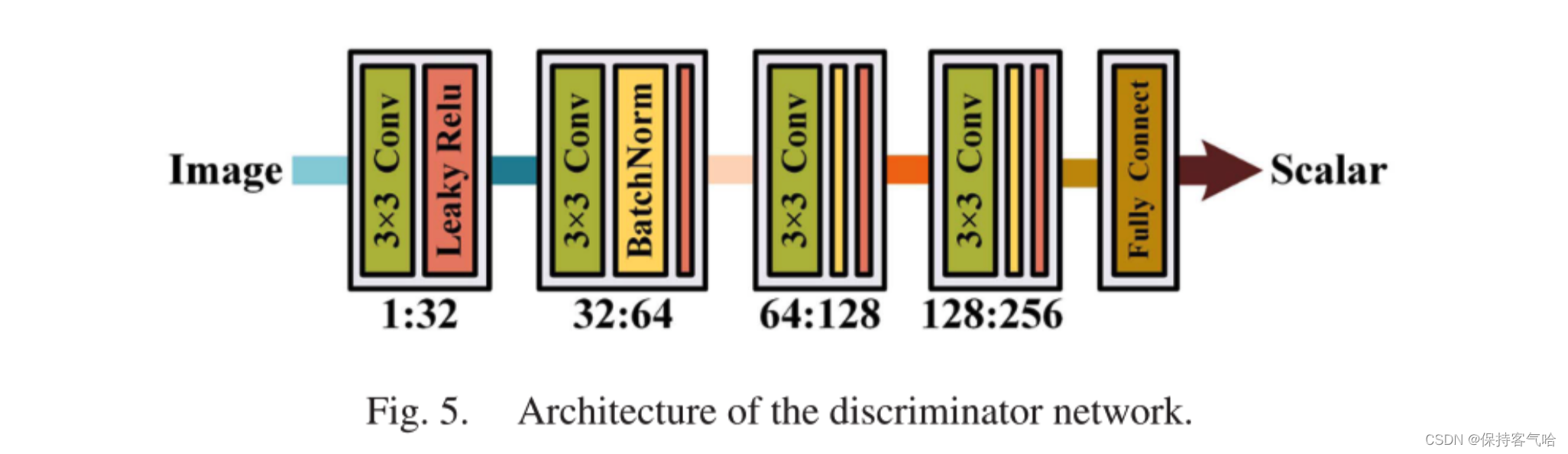

3.5.1 DiscriminatorArchitecture

我们的网络中有两个判别器Dr和Dv。它们具有相同的架构,如图5所示。它们都被用作分类器,生成一个标量来估计输入图像来自真实数据而不是G的概率。我们的判别器的架构是一个简单的五层卷积神经网络。步幅设置为2,填充设置为VALID。因此,不需要池化层。我们在第二、第三和第四个卷积层中应用批归一化,并在前四个层中采用Leaky ReLU激活函数。最后一层是一个全连接层,主要用于分类。从第一层到第四层,卷积核的大小设置为3×3,卷积核的数量设置为32、64、128和256。因此,输入和输出通道比例为1:32,32:64、64:128和128:256。

4. EXPERIMENTAL RESULTS

4.1 Database and Settings

我们从公开可获得的TNO人类因素数据库中选择和标记了56对典型图像,该数据库包含不同军事相关场景的多光谱夜间图像。标记的图像包含12个类别,如人、云、汽车、飞机、烟雾、河流、树木、建筑物、地面、路灯、雨伞和背景,可以全面反映红外和可见光图像的特点。然而,由于光照和烟雾等外部因素的影响,一些语义对象在红外或可见光图像中是不可见或部分可见的(例如人物),导致标记图像之间存在差异。因此,我们使用预先设计的规则将标记的图像 L r L_r Lr和 L v L_v Lv进行融合,得到完整的标签 L f L_f Lf,具体规则如下。不同传感器捕捉到的图像具有不同的特征。例如,由于热辐射,红外图像中的人、汽车和云更加可见,而可见光图像中的树木、地面和建筑物则受益于丰富的纹理细节。因此,我们可以将所有语义对象分为两个类别。一个类别使用红外图像标签(例如人和云),其余的使用可见光图像标签(例如树木和地面)。此外,为了在不同语义对象标签重叠时确定标签,我们给予人、汽车和飞机更高的优先级,因为它们更重要和有价值,以避免在融合过程中丢失语义信息。

我们采用39对图像来训练图像融合网络。具体而言,这39对图像被裁剪成21,730个大小为120×120像素的patch块,以增加训练数据。在测试过程中,我们使用剩下的17对图像来评估所提出的SDDGAN的性能。此外,我们还在公开的INO数据库上进行定性和定量比较,从中选择了37对红外和可见光图像,这些图像是从名为"Trees and runner"的视频中每隔15帧选择的,以验证我们的SDDGAN的泛化能力。

设置方面,我们的方法包含八个超参数:α、β、γ、ξ、η、λ、μ和κ。它们用于保持不同损失项之间的平衡,并确定生成器的偏好。在实践中,为了平衡训练,我们经验性地设计了超参数的初始值,使得损失项的数量级相同,并通过定性和定量实验结果进行优化。它们的值如下:α = 0.3,β = 1.2,γ = 0.1,ξ = 15,η = 0.6,λ = 1.33,μ = 0.5,κ = 1。学习率设置为1e-4,并采用指数衰减。批大小和训练轮数分别设为32和40。

4.2 Experiment on the TNO Database

为了验证我们提出的SDDGAN的性能,我们与九种最先进的方法进行了定性和定量实验,其中包括四种传统方法,即DTCWT ,GTF ,FPDE 和IFEVIP ,以及五种基于深度学习的方法,即DenseFuse ,FusionGAN ,PMGI ,SSGAN 和DDcGAN 。下面的实验结果表明我们的SDDGAN的优越性。

4.2.1 Qualitative comparisons

我们选择了六个典型的图像对进行定性评估,提供直观的实验结果的算法性能。我们的SDDGAN和其他九种比较方法的融合结果如图6所示.与现有的方法相比,我们的SDDGAN有三个明显的优势。首先,我们的融合图像可以突出目标(例如,人和汽车),增强红外图像中的热辐射特征,如第二、第三和第六示例所示,红外图像中目标与背景之间的对比度高于原始对比度,这有利于目标检测。其次,我们的融合图像可以保持丰富的纹理细节从可见光图像。如第一、第二和第五示例中所示,背景(例如,树和地面)信息量更大。我们的融合图像也具有更好的视觉感知。第三,IQD块的应用,我们的融合图像更清晰,融合结果不受红外或可见光图像的低信息含量的影响。如第一、第四和第五示例中所示,每个语义对象的特征可以被很好地保留。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-gZWBfzgO-1685241572884)(/Users/zhangkai/Library/Application Support/typora-user-images/image-20230527215327907.png)]](https://img-blog.csdnimg.cn/6ffcec94a78a4198afb2dd0142a7b6b9.png)

图6显示DTCWT、FPED和DenseFuse不能突出目标,而GTF、FusionGAN和PMGI不能获得丰富的纹理细节。相比之下,IFEVIP、SSGAN和DDcGAN可以获得令人满意的结果,但是它们都遭受一些缺陷。IFEVIP采用四叉树分解和提取红外图像的明亮特征,然后将它们添加到可见光图像。因此,对于任意语义,融合图像中仅可以保留一个模态特征。如第四示例中所示,汽车的窗户在融合图像中完全不可见。此外,如果可见图像明亮或曝光过度,则该方法失败,例如第四个示例中的云。SSGAN采用语义分割的方法将红外图像中的亮目标分解为前景,然后将图像的前景和背景(图像的其余部分)分别融合。然而,该方法受语义分割的影响很大,不良的语义分割结果可能使该方法无效,如第四个示例中所示。

我们的SDDGAN和DDcGAN都使用具有双鉴别器的生成对抗网络,但我们的SDDGAN与DDcGAN有本质的不同。首先,以不同的方式优化生成器。DDcGAN通过红外图像的强度和可见光图像的梯度对网络进行优化,试图同时保持红外图像的热辐射和可见光图像的纹理细节,类似于在红外图像中加入可见光图像的梯度信息,但它没有区分不同模态中不同语义对象的特征,导致融合图像的梯度混淆。如图6所示,一些物体的边界(例如人和汽车)变得模糊,这表明其具有较高的平均梯度(mean gradient),但与源图像的相关性(correlation with source images)和结构相似性(MS_SSIM)较低,如表I所示。相比之下,我们的SDDGAN是语义监督的。

我们设计了一个IQD块来确定融合图像中每个语义对象的保留程度,并监督网络训练。因此,生成器学习了不同语义对象的融合机制,并生成了信息丰富的融合图像。如图6所示,融合图像具有更好的视觉效果,每个语义特征都能得到很好的保留。此外,正如前面提到的,由于应用了IQD块,我们的融合结果不会受到红外或可见图像信息内容较低的影响。IQD块的影响在第IV-C节中进行了详细分析。其次,判别器的操作方式也不同。DDcGAN使用双判别器来识别红外和可见图像的分布,并强制融合图像同时保留红外和可见图像的特征。然而,他们的双判别器作用于整个融合图像,融合图像不能同时模拟红外和可见图像的分布。相反,我们SDDGAN中的判别器用于不同模态的语义对象,它们作用于融合图像的不同部分,互相影响很小。因此,我们的融合图像可以很好地保留红外和可见图像的模态特征。

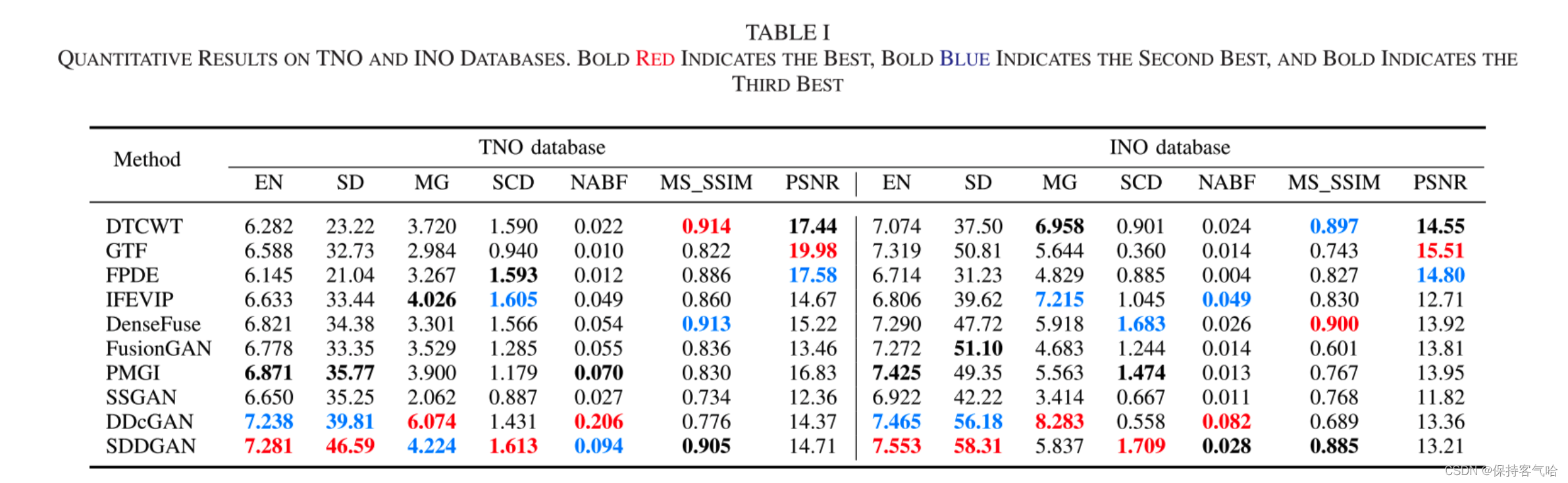

4.2.2 Quantitative Comparisons

我们进一步对我们的SDDGAN和上述九种方法在剩余的17个测试图像对上进行定量比较。我们使用了七个客观指标进行评估,分别是EN 、SD 、MG、SCD 、NABF 、MS_SSIM 和PSNR。EN可以衡量信息量,SD可以衡量图像对比度,MG可以衡量梯度信息,SCD可以衡量与源图像的相关性,NABF可以衡量融合引入的失真、噪声或伪影以及融合图像与源图像之间的补充信息量,MS_SSIM可以衡量与源图像的结构相似性,PSNR可以衡量融合图像的失真程度。定量比较结果如表I所示。从统计结果可以看出,我们提出的SDDGAN在EN、SD和SCD方面的平均值最好。此外,我们的SDDGAN在MG、NABF和MS_SSIM方面取得了可比较的结果,平均值分别为第二、第二和第三。至于PSNR,我们的SDDGAN排名倒数第五;原因如下所述:PSNR可以衡量融合图像的失真程度,其值与均方误差(MSE)值成反比。因此,基于像素级的传统图像融合方法表现更好。此外,设置更大权重在MSE损失中的深度学习方法也可以获得良好的结果,比如PMGI。对于我们的SDDGAN,我们更关注不同模态语义对象的融合以保留它们的特征。如图6所示,我们的融合图像在像素强度上存在差异,但提供了更大的对比度,具有更好的视觉效果,并有助于后续的目标检测等任务。此外,其他指标上的优秀表现表明我们并没有因为像素强度的差异而丢失源图像中的信息。

4.2 Ablation Analysis

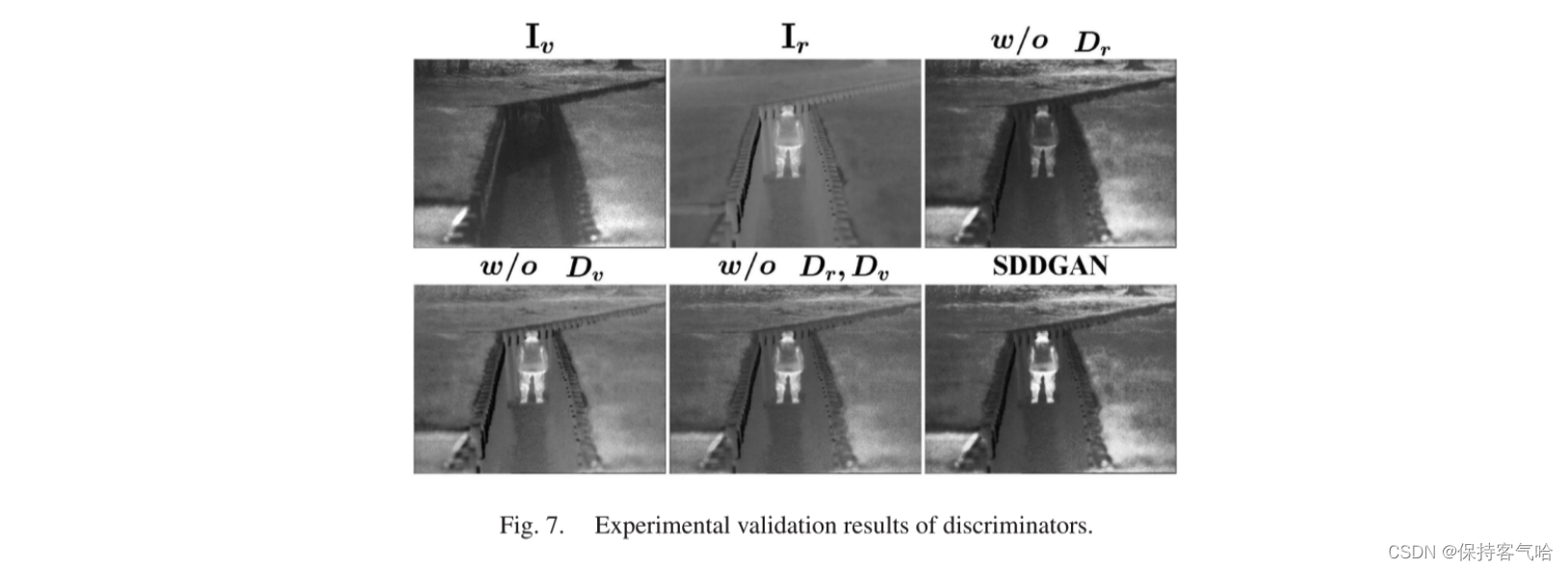

Experimental Validation of Dual Discriminators

我们的SDDGAN包括两个判别器,即 D r D_r Dr和 D v D_v Dv。我们进行了四个比较实验来验证每个判别器的效果。首先,我们从网络架构中移除了判别器 D r D_r Dr。因此,G和 D r D_r Dr之间的对抗关系不再存在。其次,我们从网络架构中移除了判别器 D v D_v Dv,对抗关系只在G和 D r D_r Dr之间建立。第三,我们只使用G在网络架构中。第四,我们使用完整的SDDGAN网络架构生成融合图像。所有这些比较实验都在相同的设置下进行,并且融合结果如图7所示。

在第一个比较实验中,融合图像与可见光图像非常相似,包含丰富的纹理细节,但无法突出目标。相比之下,第二个实验结果可以保持目标区域的重要性,但背景模糊不清。两个判别器被用来识别红外和可见图像的分布,并作用于融合图像中不同语义对象的某个模态(红外/可见)。因此,前两个实验证明 D r D_r Dr主要针对目标,以保持来自红外图像的实质性热辐射。相反, D v D_v Dv主要针对背景,以保留来自可见图像的丰富纹理细节。第三和第四个实验结果表明,两个判别器工作良好,并且几乎不对彼此产生影响。从前面的实验中可以得出结论,经过训练的生成器G能够准确确定每个语义对象的特征,并使用不同的融合权重进行融合,以保留和增强它们的模态特征。

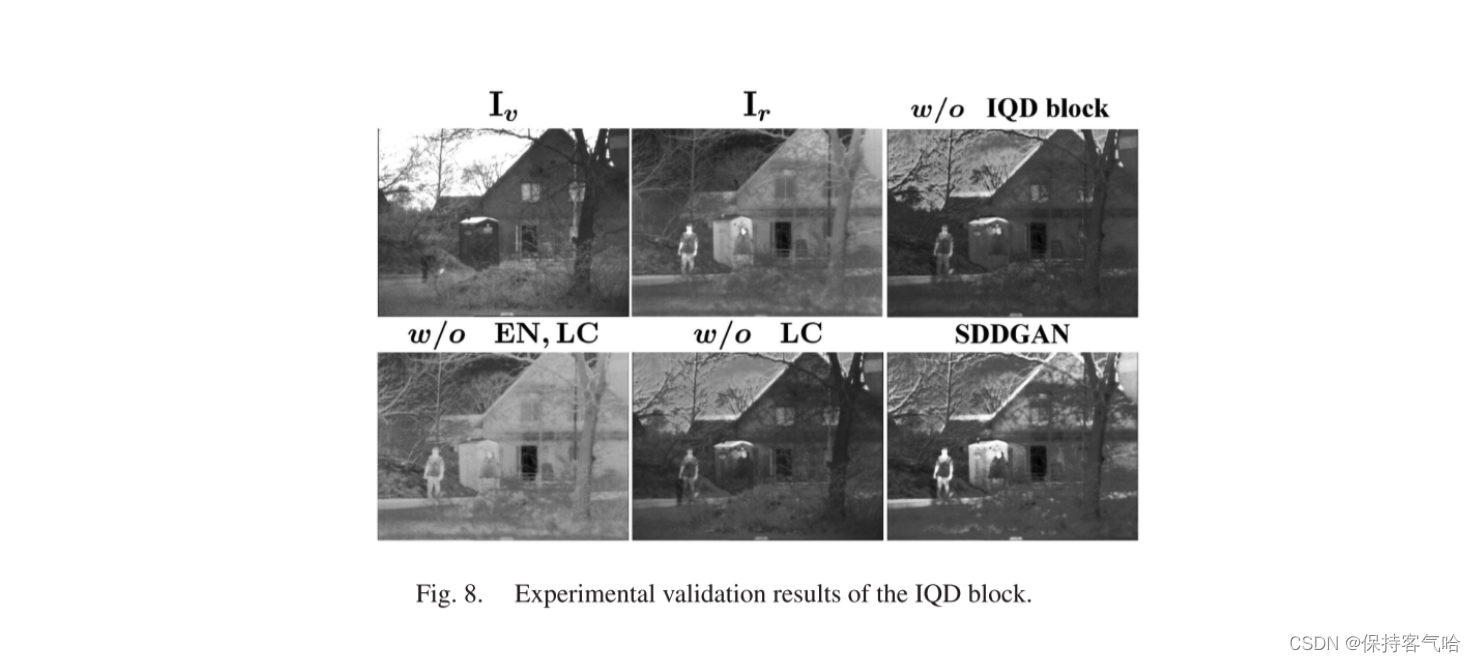

Experimental Validation of the IQD Block

我们在我们的IQD块中采用了三个度量指标(即EN、NR-IQA和LC)来计算红外和可见图像中每个语义对象所包含的信息。为了验证IQD块的有效性,我们进行了四个比较实验。首先,我们删除了我们方法中的整个IQD块,这意味着语义监督机制不再存在。因此,标记图像是不必要的,并且融合图像在输入鉴别器之前没有额外的处理。第二,我们只在IQD块中采用了NR-IQA。因此,不同语义对象的融合权重都由它们的NR-IQA值确定。第三,我们仅从IQD块中删除了 L c L_c Lc。因此,IQD块由EN和NR-IQA组成。第四,我们使用我们提出的完整IQD块生成每个语义对象的融合权重。所有这些比较实验在相同的设置下进行,并且融合结果如图8所示。

在第一个比较实验中,双重鉴别器都作用于整个融合图像。然而,融合图像只能模拟特定的分布。因此,红外图像中的热辐射和可见图像中的纹理细节都会有一定程度的损失。在第二个比较实验中,融合图像相对较差,既丢失了纹理细节,也丢失了热辐射。相反,第三个实验结果包含丰富的纹理细节,并符合人类的视觉感知。第二和第三个实验表明,EN和NR-IQA的组合可以有效评估每个语义对象所包含的信息,并为它们生成适当的融合权重。然而,红外图像中对于目标检测非常重要的热辐射信息无法使用上述两个度量来计算。因此,融合图像中的目标并不明显。然而,通过LC,热辐射信息也可以得到很好的保留。如第四个实验结果所示,目标区域非常显著,背景清晰。这些实验结果表明了NR-IQA、EN和LC的有效性,以及它们的组合可以有效计算每个语义对象所包含的信息。因此,在IQD块的监督下,生成器学习了每个语义对象的融合机制,使得在融合图像中保留和增强了它们的特征,并提高了融合图像的语义表达能力和语义一致性。

Experimental Validation of the Generator Loss

生成器G的损失函数包括四个部分:监督损失 L s u p L_{sup} Lsup,对抗损失 L a d v L_{adv} Ladv,梯度损失 L g r a d L_{grad} Lgrad和均方误差损失 L m s e L_{mse} Lmse。我们已经分析了每个鉴别器(即 L a d v L_{adv} Ladv)的有效性。在这部分中,进行了三个比较实验来验证其余项的效果。首先,我们在 L G L_G LG中移除了监督损失 L s u p L_{sup} Lsup。因此,网络训练过程不需要使用IQD块进行监督。其次,将梯度损失 L g r a d L_{grad} Lgrad和均方误差损失 L m s e L_{mse} Lmse不纳入 L G L_G LG中,然后仅使用 L s u p L_{sup} Lsup和 L a d v L_{adv} Ladv训练G。第三,我们使用我们提出的SDDGAN中的所有损失项来训练生成器。比较实验在相同的设置下进行,并且融合结果显示在图9中。

在第一个比较实验中,融合图像无法突出显示目标,并且一些重要的语义对象丢失,例如云。相比之下,第二个实验结果包含丰富的热辐射,并且具有改善的视觉效果。然而,从源图像中丢失了一些细节;例如,融合图像中的云区域模糊不清。这两个比较实验表明,监督损失 L s u p L_{sup} Lsup可以在融合图像中保持每个语义对象的特征,并提高其语义一致性。同时,梯度损失 L g r a d L_{grad} Lgrad和均方误差损失 L m s e L_{mse} Lmse可以保留源图像中的大量信息。在第三个实验中,目标明显可见,云清晰可辨。每个语义对象的特征和源图像的纹理细节都得到了很好的保留。从这些实验结果中,我们可以得出结论:生成器损失 L G L_G LG中的每个损失项都是有效的。通过组合这四个损失项,我们的SDDGAN可以生成高质量的融合图像,这对于后续的应用和任务非常有益。

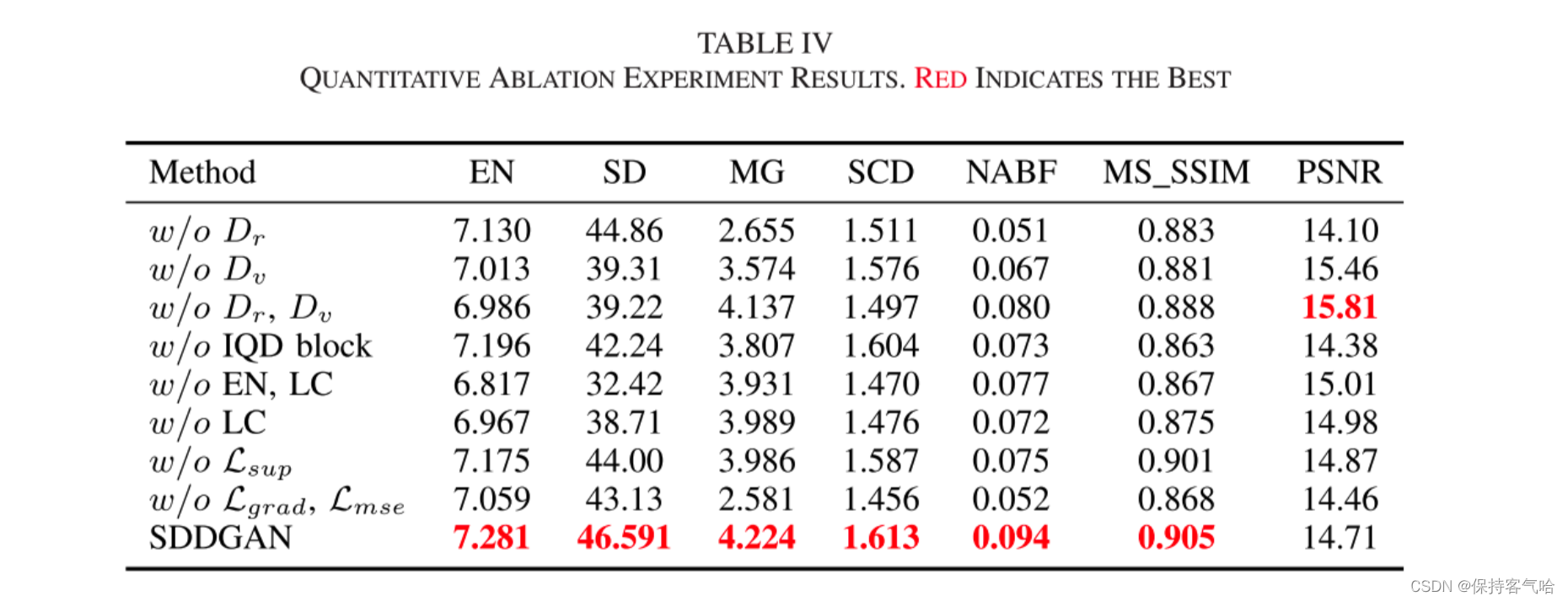

Quantitative Ablation Experiments

为了更直观地展示结果,我们还提供了定量的割减实验结果,如表IV所示。除了PSNR之外,我们的SDDGAN在这些指标上的平均值是最好的。PSNR值与均方误差(MSE)值成反比(融合图像与两个源图像均值之间的像素值越接近,PSNR值越大)。理论上,除了均方误差损失之外,删除其他损失项可以提高PSNR值。如表IV所示,PSNR的最大值出现在删除Dv和Dr的情况下。然而,实际情况可能更为复杂。在我们的方法中,每个损失项都是必要的,并且或多或少地影响了融合图像的像素值,特别是对于决定融合图像风格的双重鉴别器。一旦添加Dv/Dr,融合图像就会趋向于Iv/Ir,而PSNR值会降低。值得注意的是,我们的SDDGAN中的两个鉴别器在融合图像中的作用是不同的,并且几乎不会对彼此产生影响。因此,融合图像中的某些语义对象更接近红外图像(这些部分的PSNR值相当于没有Dv时的值)。其他部分更接近可见光图像(这些部分的PSNR值类似于没有Dr时的值)。因此,我们的方法的PSNR值倾向于表IV中前两组实验的中间值。从定量的割减实验结果可以得出结论:我们的SDDGAN中的每个损失项都是必要的。

5.Conclusion

在本文中,我们提出了一种新的红外和可见光图像融合方法称为SDDGAN。我们设计了一个IQD块来计算每个语义对象所包含的信息,并为它们生成适当的融合权重,以保留它们的语义信息。双鉴别器强制融合图像保持红外图像的热辐射和可见光图像的纹理细节。因此,我们的融合图像是相当丰富的信息,并具有较高的语义表示能力。定性和定量的比较结果与9个目前最先进的方法证明了所提出的方法的优越性。